藤本健のDigital Audio Laboratory

第1020回

AI作曲からVRミキシング、歌唱テクニックの修得支援まで。音楽研究最前線

2024年11月11日 08:40

前回の記事、「FLACよりも圧縮率が優秀!? 日本発のロスレス音声コーデックSRLAとは」でも紹介した通り、8月26日から27日の2日間、東京の駒澤大学・駒沢キャンパスで第141回・音楽情報科学研究会が開催された。

これは、一般社団法人情報処理学会の音楽情報科学研究会(SIGMUS)のシンポジウム。大学や国、企業の研究機関が研究成果を発表する学会になっていて、音楽にまつわる発表内容にフォーカスされている。

昨今の傾向で、AIやディープラーニングに関する発表が増えており、内容的にはかなり難しいものが多いが、基本的には音を鳴らすデモを交えて発表するのがSIGMUSの楽しいところで、デモを見れば誰でもその内容がある程度分かるようになっている。

メインとなるのは壇上でのプレゼンテーションだが、デモセッションの枠も用意されていて、初日の14時から16時まで、全26チームがそれぞれの研究成果を発表した。

今回は、大学の学部生から、企業、理化学研究所の発表の中から、いくつか興味深い研究をピックアップして紹介してみたい。

大学生から理化学研究所まで、さまざまな音楽研究が集合

当日は、実際のポスター発表/デモセッションに先立ち、メインのセミナールームで26のチームが順番に概要発表を行なった。

1人の持ち時間は50秒という短い時間ではあるが、順番に発表した後に、各自の持ち場に戻ってゆく。参加者側も、この50秒のプレゼンテーションを見た上で、それぞれ興味のある発表ブースを回っていくという形態だ。

では、その中で面白かったもの、デモが分かりやすかったものをいくつかをピックアップしていこう。

Melisma:楽譜ラベルに基づく単一モデルによるDNN多楽器・多歌唱者音合成システム/中迫酒菜(神楽音楽出版)

まずはメインのセミナールームでも発表を行なっていた、AIを用いた楽器音合成システムであるMelisma(メリスマ)から。

Melismaについては筆者のブログ「DTMステーション」でも何度か取り上げているので、ご存じの方もいるかもしれない。

Melismaは、従来のシンセサイザとはまったく異なるアプローチのソフトウェアシンセサイザ。たとえば、バイオリンやフルート、オーボエ……といった楽器の実演奏を楽譜とセットで機械学習させると、楽譜を入力するだけでそれに対応する演奏を行なうもの。実際その音の例が下の動画だ。

サンプリングシンセサイザでは不可能な、幅広い表現力を持っているのが分かるだろう。また、バイオリンの演奏を学習させているのも特徴。その中にはたとえばピチカートがあるが、ピチカートを現実にはあり得ないフルートに適用することもできる。今回のSIGMUSでは、そのMelismaがどのような仕組みになっているのかが発表された。

GPT-4におけるメロディ生成能力の検討/刀祢賢志、岡崎光栄、北原鉄朗(日本大学)

対話型AIの代名詞的に言われているOpen AIのChat GPTだが、その最新の基幹エンジンである自然言語処理のためのAIシステムGPT-4を使って自動作曲をしよう、というのが日本大学による研究だ。

作曲をするには、音楽理論を学ぶ必要があるが、学ぶこと自体大変だし、学んだからといってすぐに作曲に活用できるわけでもない。そこで、GPT-4が持つ知識に頑張ってもらおうというのがこの研究だ。

GPT-4で直接音を鳴らすことはできないので、テキストベースのABC Music Notation形式で出力させた上で、これをスタンダードMIDIファイルに変換して、楽譜を生成し、演奏させようというのだ。

しかし、そもそもGPT-4は音楽理論をしっかり理解しているのか。これを確かめるためにいくつかのプロンプトを与えて作曲をさせた、という。

この際、コード進行の構成音だけでメロディ生成できるのか、与えられたスケールの構成音だけでメロディ生成できるのか、休符や三連符が使えるのかなど、実験していったとのことだが、これによってできたのが以下のようなメロディ。

短いものではあるが、結構しっかり曲になっている印象。今後、プロンプトの内容をより抽象的にして音楽生成できないか研究を進めていく、という。

VRを用いた仮想ミキシングシステムの提案/近藤建樹(電気通信大学大学院)

電気通信大学大学院が披露したのは、音楽のミックスを従来のDAWのミキシングコンソールで行なうのではなく、仮想空間を使って、より直感的に行なうという実験的なシステムだ。

一般的なDAWでのミックスは、各音ごとに音量を調整したり、EQで音質を調整したり……と耳を頼りに作業するため、初心者にはなかなかとっつきにくいのも事実。そこで、いろいろなトラック、楽器の音をビジュアライズ化、VR化して、大きなディスプレイに表示させ、わかりやすく操作できるようにしようという試みだ。

具体的には、高さ方向が周波数、横方向が左右のPAN、また明るさが音の強さに対応していて、これを利用してミックスしていくわけだ。

よくミックスの話をしていると「中音域がモコモコしていて、いろいろな音がゴチャゴチャ混ざっているからわかりにくい」といった表現をするが、この画面を見ると、その様子がハッキリと視覚化されてくる。そのうえで、このビジュアルを見ながら音量やEQ、PANなどで整理してやると、目的の音をクッキリと浮かび出すことが可能になるわけだ。

システム的にはDAWに、ここで開発したVSTプラグインを挿し、それを周波数解析などしたうえで、Wi-Fiで送り出しているとのこと。確かにこの音を視覚的に表現する方法を用いることで、より分かりやすいミックス処理ができるようになりそうだ。

Solitude:サウンドスコープフォン新コンテンツ公開/浜中雅俊(理化学研究所)

理化学研究所が展示していたのは、すでにiPhone用、iPad用でアプリを無料配布している実験的な音楽再生システム「SoundScopePhone」「SoundScopePad」のデモだ。

ピアノだけの楽曲やバイオリンのソロなど、1つの楽器の音だけが聴こえているときはいいけれど、同時に演奏される楽器が増えてくると、その中の1つのパートだけを聴くというのは難しくなってくる。

すごく音楽に慣れている人だと、いっぱい鳴っている中で特定の楽器の音だけを追っていくということはできるけれど、普通は難しい。そこで各楽器パートが自分を取り囲むように配置されて鳴っていることを前提として、これまでにない新たな聴き方を提案しているのがこのSoundScopePhoneなのだ。

具体的にはiPhoneやiPadを手に持ってカメラを自分に向けた上で、ぐるりと体を回転させていたり、首を振る形で鳴っている楽器のほうに顔を向けると、向けた方向の楽器の音が強く、ハッキリと聴こえてくる仕組みだ。

これはiPhone/iPadに内蔵されているジャイロセンサーと、カメラによる顔の方向センシングによって実現しているのだが、これまでにない音楽体験ができるのが楽しいところ。以下に理化学研究所で作った紹介ビデオがあるので、これを見るとより実感できるだろう。

会場では特別な楽興を流していたが、このアプリは誰でも無料でダウンロードでき、現時点4曲のデモ曲を楽しむことができるようになっているので、ぜひ試してみてほしい。

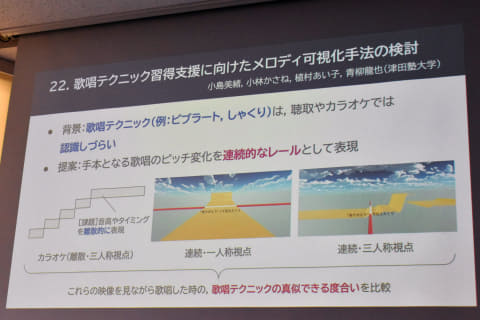

歌唱テクニック習得支援に向けたメロディ可視化手法の検討/小島美緒、小林かさね、植村あい子、青柳龍也(津田塾大学)

楽器の演奏方法を学習するのも難しいが、歌い方を学ぶというのも、分かりやすそうでいて、結構難しい。

言葉としてはビブラートで声を震わせるとか、しゃくりを入れる、こぶしを回す、フォールダウンさせる……など歌い方のテクニックはあるけれど、それを正しく習得するというのは、なかなか難しい。一般的には人の歌い方を真似るわけだが、こうした歌唱テクニックがどこで用いられているのかを認識しづらいこともあって、簡単にはいかない。

そうした課題に対して、津田塾大学が取り組んだのは、メロディの動きをアニメーション的に可視化して、音が上がっていくのか、下がっていくのかなどをわかりやすく表現し、お手本となる歌唱のピッチ変化とユーザーの歌唱をリアルタイムに比較していくというシステムだ。

ビデオゲームのように、一人称視点と三人称視点の2種類のビューで表現。一人称視点の場合、お手本の歌唱が歩いていくレールというか階段のように見えていて、この先上がるのか、下がるのかを事前に心の準備ができるし、現在自分が歌っている音程がどの位置にあるのかも比較できる。

また三人称視点にすると、前後の関係がより見やすくユーザーの歌った履歴も可視化されるため、差分がどの程度だったのかが理解しやすくなっている。

担当者によると、このシステムによって“真似度合い”が向上することを確認しているところとのだが、こんなシステムがカラオケボックスにあれば、即ヒットするのでは、と思った次第だ。

音楽理論に基づいた配列で演奏・合奏を容易にする鍵盤楽器ParoToneの開発/佐藤 那由多、三田真志郎(eMotto株式会社)

最後に紹介するのは、大阪大学院のスタートアップであるeMottoが開発し、すでにクラウドファンディングも実施している「ParoTone」という楽器というかキーボードだ。まずは、下のビデオをご覧いただきたい。

見た目は小さなコンピュータ用キーボードといった感じなのだが、もちろんコンピュータ用キーボードでもなければ、いわゆるMIDI鍵盤とも違う。楽器演奏に挫折した人でも、簡単に弾くことができ、音楽理論というかコード体系が多少分かればさらに積極的に弾いたり、さらには作曲のサポートにもなるという、ユニークな楽器なのだ。

ハードウェア的にはあくまでもただのキーボードで、それがUSBでiPhoneに接続してアプリ側で音を鳴らしているのだが、ここでポイントとなっているのがキーの配列。左側が和音用、右側がメロディ用となっており、ゲーム感覚で簡単に演奏ができるという。

左側のキーボードにはそれぞれ和音=コードが割り当てられていて、1本指で押すだけで和音を鳴らすことができる。そして右側も数少ないボタンでメロディが弾けるようになっている。

技術的に難しいことをしているわけではなく、コード理論に基づいて、弾きやすい形にしているのだ。つまり、演奏する前にちょっと設定を行なうと、その曲で登場するコード、メロディだけが各キーに割り当てられ、難しいことを考えなくても弾ける。

もう少し言うと、和音配列は五度圏にしたがって左から右へとダイアトニックコード、その下に準固有和音、さらに借用和音(セカンダリードミナント)となっているため、押すキーを左から右、また上から下へと動かすだけで、いい感じのコード進行ができてしまう仕掛け。すでに試験的な販売もしているようなので、気になる方はチェックしてみるといいだろう。

以上、26あるデモセッションのうち6つだけをピックアップしてみた。会場では、研究段階のものから、製品化目前といったものまで、音楽や楽器に関する研究の最前線を垣間見ることができた。今後もSIGMUSのシンポジウムにはできるだけ参加したいと思った次第だ。