タグ

- すべて

- *あとで (85)

- .net (31)

- 3D (33)

- AI (83)

- API (454)

- AST (38)

- AWS (1529)

- AdventCalendar (28)

- Angular.js (301)

- Ansible (123)

- App (42)

- Backup (30)

- CDN (33)

- CPU (79)

- CSRF (35)

- CentOS (163)

- Chef (400)

- CloudFront (43)

- CoreOS (79)

- DDD (308)

- DeNA (35)

- Drupal (32)

- E2E (29)

- Embulk (38)

- Excel (45)

- Firebase (98)

- Flux (93)

- GAE (72)

- GCP (177)

- GUI (29)

- GitHubActions (30)

- GraphQL (42)

- Grunt (96)

- HA (36)

- Haskell (416)

- IO (52)

- JVM (93)

- Kibana (59)

- ML (42)

- MLOps (54)

- Netflix (49)

- Nuxt.js (30)

- OpenCV (45)

- PSD (34)

- Processing (32)

- Qiita (248)

- R (62)

- RaspberryPi (55)

- Redmine (52)

- SQLite (32)

- SRE (49)

- SSL (66)

- SVG (51)

- Sketch (36)

- TCP (65)

- TensorFlow (87)

- UI (662)

- UITableViewCell (38)

- WebService (386)

- Xcode (464)

- activerecord (126)

- activity (48)

- adobe (31)

- agile (174)

- ajax (254)

- akka (31)

- algorithm (353)

- amazon (137)

- analytics (86)

- android (1280)

- animation (134)

- apache (244)

- apple (67)

- application (65)

- arc (38)

- architecture (387)

- async (87)

- atom (44)

- audio (36)

- aurora (29)

- autolayout (65)

- awk (55)

- backbone.js (153)

- background (43)

- bash (210)

- bdd (38)

- benchmark (28)

- bigquery (161)

- binary (38)

- block (30)

- blocks (40)

- blog (62)

- bluetooth (28)

- book (564)

- bootstrap (295)

- bot (42)

- browser (118)

- browserify (55)

- brush (55)

- build (43)

- bundler (28)

- business (261)

- button (28)

- c# (33)

- c++ (82)

- cache (117)

- cakephp (63)

- camera (31)

- canvas (107)

- capistrano (70)

- capybara (37)

- career (85)

- chainer (50)

- chrome (206)

- ci (356)

- circleci (53)

- clang (110)

- cli (87)

- cloud (135)

- cloudwatch (50)

- cluster (51)

- cocoa (220)

- cocoaPods (88)

- cocos2d (70)

- code (109)

- codereading (69)

- codereview (64)

- coffeescript (85)

- color (135)

- column (36)

- command (128)

- communication (48)

- compass (31)

- compiler (34)

- concurrency (66)

- config (72)

- consul (108)

- container (124)

- cookbook (41)

- cookie (44)

- cookpad (65)

- coredata (54)

- crawler (33)

- cron (59)

- css (881)

- css3 (468)

- d3.js (48)

- data (435)

- database (394)

- db (281)

- dbt (48)

- debian (31)

- debug (274)

- deeplearning (197)

- deferred (47)

- delegate (48)

- deploy (93)

- design (1627)

- dev (95)

- developer (46)

- development (1334)

- devops (174)

- di (32)

- distributed (31)

- django (92)

- dns (77)

- docker (1158)

- document (144)

- dom (84)

- dropbox (50)

- dynamodb (74)

- ec2 (226)

- eclipse (64)

- ecmascript (97)

- ecs (84)

- editor (157)

- education (52)

- effect (49)

- elasticsearch (269)

- elb (48)

- electron (77)

- elixir (87)

- elm (40)

- emacs (48)

- enchant.js (46)

- engineer (133)

- engineering (65)

- english (369)

- erlang (51)

- error (82)

- es6 (28)

- event (137)

- express (70)

- extension (82)

- facebook (114)

- fashion (34)

- filesystem (48)

- firefox (135)

- fireworks (63)

- flash (59)

- flat (29)

- fluentd (338)

- font (208)

- food (136)

- framework (309)

- free (49)

- frontend (64)

- function (120)

- functional (109)

- furniture (86)

- game (210)

- gc (62)

- gem (191)

- generator (47)

- git (488)

- github (653)

- gmail (31)

- go (1085)

- golang (1609)

- google (318)

- goroutine (53)

- gradle (65)

- grep (32)

- gulp (88)

- hadoop (122)

- haproxy (30)

- hatena (92)

- health (55)

- heroku (197)

- homebrew (47)

- html (338)

- html5 (664)

- http (200)

- http2 (42)

- https (82)

- hubot (57)

- iBeacon (33)

- iOS8 (47)

- iam (56)

- ibm (93)

- icon (213)

- ide (77)

- idea (37)

- illustrator (313)

- image (188)

- imagemagick (37)

- infrastructure (119)

- innodb (102)

- inspiration (29)

- install (95)

- interface (72)

- interior (51)

- interview (49)

- ios (1894)

- ios7 (51)

- ipad (69)

- iphone (426)

- iptables (49)

- isucon (146)

- jasmine (31)

- java (1058)

- javascript (5118)

- jenkins (237)

- jquery (1331)

- jquery mobile (37)

- json (204)

- junit (37)

- kafka (88)

- kaggle (61)

- kernel (209)

- kotlin (88)

- kubernetes (314)

- kvm (37)

- lambda (237)

- layout (81)

- library (671)

- lifehacks (249)

- lightbox.js (30)

- links (66)

- linux (1543)

- lisp (39)

- logging (147)

- logo (35)

- lxc (53)

- mac (661)

- machinelearning (302)

- mail (61)

- management (264)

- map (44)

- markdown (37)

- marketing (88)

- material (499)

- math (126)

- memcached (68)

- memo (47)

- memory (129)

- microservices (110)

- mobile (324)

- model (54)

- module (56)

- monad (53)

- money (87)

- mongodb (159)

- monitoring (211)

- mruby (85)

- ms (29)

- music (76)

- mvc (40)

- mysql (1017)

- nagios (35)

- network (526)

- nginx (430)

- nlp (151)

- node.js (928)

- notification (43)

- npm (61)

- oauth (56)

- objective-c (1954)

- oop (53)

- os (39)

- oss (107)

- pandas (74)

- pattern (78)

- pdf (29)

- performance (831)

- perl (167)

- phantom.js (35)

- photo (88)

- photoshop (897)

- php (1132)

- plagger (48)

- plugin (296)

- podcast (29)

- postgresql (243)

- presentation (76)

- programming (1993)

- promise (35)

- prototype (50)

- prototype.js (47)

- proxy (68)

- puppet (29)

- push (35)

- python (1410)

- rails (1547)

- react.js (342)

- redis (140)

- redux (74)

- reference (100)

- regexp (69)

- rest (72)

- rspec (109)

- rss (51)

- ruby (1937)

- rust (178)

- s3 (64)

- sass (62)

- scala (292)

- scraping (69)

- scrum (74)

- search (82)

- security (938)

- selenium (99)

- sencha (29)

- seo (84)

- serf (29)

- server (248)

- serverless (83)

- serverspec (58)

- shell (229)

- shopping (42)

- slide (601)

- slideshare (91)

- socket.io (32)

- software (191)

- solr (36)

- spark (68)

- sql (292)

- ssh (111)

- startup (41)

- statistics (80)

- storage (34)

- stream (47)

- study (474)

- sublimetext2 (45)

- subversion (47)

- swift (1062)

- tdd (214)

- template (118)

- terminal (55)

- terraform (113)

- testing (900)

- texture (126)

- theme (38)

- thread (36)

- tips (1444)

- titanium (111)

- tmux (63)

- tool (109)

- travel (197)

- tuning (95)

- tutorial (930)

- twitter (104)

- typescript (197)

- ubuntu (77)

- uitableview (50)

- unity (151)

- unix (35)

- ux (131)

- vagrant (214)

- vector (40)

- video (105)

- vim (365)

- visualization (73)

- vue.js (218)

- web (222)

- webdesign (1051)

- websocket (85)

- windows (167)

- wordpress (408)

- work (98)

- xml (43)

- youtube (35)

- zsh (100)

- あとで読む (10310)

- まとめ (1111)

- デザインパターン (50)

- 個人開発 (29)

- 機械学習 (493)

- 統計 (70)

- 自然言語処理 (64)

- 設定 (51)

- 設計 (440)

- 資料 (208)

- 運用 (60)

- あとで読む (10310)

- javascript (5118)

- programming (1993)

- objective-c (1954)

- ruby (1937)

- ios (1894)

- design (1627)

- golang (1609)

- rails (1547)

- linux (1543)

関連タグで絞り込む (127)

- ai

- AI

- Airflow

- albert

- algorithm

- Algorithm

- annotation

- API

- aws

- AWS

- BeautifulSoup

- Bedrock

- bert

- BERT

- bigquery

- book

- bot

- chainer

- chatbot

- ChatGPT

- CNN

- cookpad

- course

- data

- DeepLearning

- deeplearning

- development

- docker

- elasticsearch

- environment

- GCP

- gensim

- ginza

- Ginza

- GO

- go

- golang

- hydra

- infrastructure

- japanese

- javascript

- juman

- Jupyter

- kaggle

- knowledgeGraph

- kuromoji

- kuromoji.js

- lambda

- LangChain

- language

- Library

- llm

- LLM

- Lucene

- machinelearning

- MachineLearning

- mecab

- MeCab

- Mecab

- ML

- mlflow

- mlOps

- MLOps

- module

- monitoring

- ms

- n-gram

- NLP

- nltk

- node.js

- pattern

- performance

- pipeline

- Processing

- programming

- Python

- python

- PyTorch

- Qiita

- RAG

- RakutenMA

- regexp

- research

- ruby

- search

- sed

- sentencepiece

- slide

- Slide

- solr

- spacy

- sphinx

- study

- sudachi

- svm

- swift

- SymPy

- synonym

- TED

- TensorFlow

- testing

- TextMining

- tips

- tuning

- tutorial

- unicode

- vector

- video

- word2vec

- Word2Vec

- あとで読む

- まとめ

- データセット

- データ分析

- レコメンデーション

- 人工知能

- 全文検索

- 勉強会

- 形態素解析

- 機械学習

- 自然言語

- 自然言語処理

- 設定

- 論文

- 資料

nlpに関するclavierのブックマーク (154)

-

clavier 2024/12/19

clavier 2024/12/19- 自然言語処理

- nlp

- レコメンデーション

- あとで読む

リンク -

【GraphRAG プロジェクトを立ち上げます】ナレッジグラフとLLMで「発想力を持つAI」の実現へ|Stockmark

こんにちは。ストックマークのリサーチャーの広田です。今日は私が新しく立ち上げた GraphRAG プロジェクトの仲間を募集するために、GraphRAG プロジェクトについて紹介したいと思います。 広田航 Researcher 大阪大学大学院情報科学研究科を卒業後、米国に渡り Megagon Labs で Conversational AI や entity matching の研究を行う。その後帰国しストックマークに参画。現在はナレッジグラフ構築や LLM を活用した情報抽出の研究を行う。 まず GraphRAG プロジェクトの背景を紹介したいと思います。 ストックマークは「価値創造の仕組みを再発明し人類を前進させる」というミッションを掲げ、「AIと人による新しい価値創造プロセスを発明する」を目指して Research Unit を組成しています。情報の量が急激に増えている現代において、情

-

2023-24年(上期)のKaggleコンペから学ぶ、NLPコンペの精度の上げ方

LLM関係のコンペがかなり多かったですね。 ベースラインノートブック 最近はほとんどのコンペがHuggingfaceのTrainerを使って学習が行われます(テーブルデータにおけるscikit-learnのような立ち位置です)。ChrisのNotebookは非常にシンプルにまとまっているのでぜひ参考にしてください。 分類(+RAG) 回帰、分類 固有表現抽出 NLP・精度上昇で検討すること データを増やす LLMによるデータ生成 + ラベリング(CommonLit2 1st, DAIGT 1st, LLM Sci Exam 5th, PIIDD 1st) LLMによるデータ生成は必ずしも効果があるとは限らない データ生成方法も現状はベストプラクティスはない Mistral, Mixtral系列でデータ生成がよさそうな感じはする なお、LLMがラベル付けできないタスクでは厳しい印象です TT

-

BigQueryとGemini 1.5 Proによるラーメン店クチコミの定量分析 - G-gen Tech Blog

G-gen の神谷です。本記事では、Google Maps API から取得したラーメン店のクチコミデータに対する定量分析手法をご紹介します。 従来の BigQuery による感情分析の有用性を踏まえつつ、Gemini 1.5 Pro の導入によって可能となった、より柔軟なデータの構造化や特定タスクの実行方法を解説します。 分析の背景と目的 可視化イメージ 分析の流れとアーキテクチャ クチコミデータ取得と BigQuery への保存 API キーの取得 データ取得のサンプルコード クチコミ数の制限と緩和策 料金 感情分析とデータパイプライン Dataform の利点 Dataform を使った感情分析のパイプライン定義例 感情分析の結果解釈 ML.GENERATE_TEXT(Gemini 1.5 Pro) 関数を使用した高度な分析 ユースケースに応じた独自の評価観点によるクチコミの定量化

-

RAGでの回答精度向上のためのテクニック集(応用編-A)

はじめまして。株式会社ナレッジセンスの門脇です。普段はエンジニア兼PMとして、「社内データに基づいて回答してくれる」チャットボットをエンタープライズ企業向けに提供しています(一応、200社以上に導入実績あり)。ここで開発しているチャットボットは、ChatGPTを始めとしたLLM(Large Language Models)を活用したサービスであり、その中でもRAG(Retrieval Augmented Generative)という仕組みをガッツリ利用しています。本記事では、RAG精度向上のための知見を共有していきます。 はじめに この記事は何 この記事は、LlamaIndexのAndrei氏による『A Cheat Sheet and Some Recipes For Building Advanced RAG』[1]という記事で紹介されている「RAGに関するチートシート」について、And

-

GPT連携アプリ開発時の必須知識、RAGをゼロから解説する。概要&Pythonコード例

こんにちは。わいけいです。 今回の記事では、生成AI界隈ではかなり浸透している RAG について改めて解説していきます。 「低予算で言語モデルを使ったアプリを開発したい」というときに真っ先に選択肢に上がるRAGですが、私自身もRAGを使ったアプリケーションの実装を業務の中で何度も行ってきました。 今回はその知見をシェア出来れば幸いです。 RAG(Retrieval-Augmented Generation)とは まず、 そもそもRAGとは何ぞや? というところから見ていきましょう。 RAG(Retrieval-Augmented Generation) は自然言語処理(NLP)と特に言語モデルの開発において使用される技術です。 この技術は、大規模な言語モデルが生成するテキストの品質と関連性を向上させるために、外部の情報源からの情報を取得(retrieval)して利用します。 要は、Chat

-

LangChain で社内チャットボット作ってみた

こんにちは、クラウドエース SRE ディビジョン所属の茜です。 今回は、現在最も普及している対話型 AI サービスである ChatGPT で使用されているモデルと、LLM を使ったアプリケーション開発に特化したライブラリである LangChain を用いて社内向けのチャットボットを作成します。 ターゲット 任意のデータを元に回答を行うチャットボットを作成したい方 任意のデータを元に回答させる仕組みを知りたい方 ChatGPT とは ChatGPT とは、ユーザーが入力した質問に対して、まるで人間のように自然な対話形式でAIが答えるチャットサービスです。2022 年 11 月に公開されて以来、回答精度の高さが話題となり、利用者が急増しています。 人工知能の研究開発機関「OpenAI」により開発されました。 執筆時点では、GPT-3.5、GPT-4 という大規模言語モデル (LLM) が使用さ

-

AzureでRAGをガンガン試行錯誤してみて得たナレッジを紹介します!/Azure RAG knowledge share

2024/1/31に開催された【StudyCo×KAGコラボ】Azure・AWSでLLMアプリ開発レベルアップ!事例&ハンズオンで発表した資料です。 AzureでRAGによる社内文章検索をやってみてさまざまな試行錯誤を通して得たナレッジを共有します!

-

Amazon Bedrock(ClaudeV2)でLambdaのコードを生成してみた - Taste of Tech Topics

こんにちは、最近久々にソロキャンプをしてきました菅野です。 AWS上で、 ChatGPTのようなテキスト生成AIを利用できるようになるサービス、Amazon Bedrockがリリースされました。 今回はBedrockで、LambdaのPythonコードを生成してもらいます。 利用するモデルは、ChatGPTと同レベルの性能を有しているClaudeV2を利用します。詳細はこちら。 Bedrockについて執筆した別記事もあわせてご覧ください。 acro-engineer.hatenablog.com acro-engineer.hatenablog.com S3に保存したCSVファイルの平均を求めるLambda関数を作成する 以下のようなcsvをS3からダウンロードし、一分毎、name毎の平均を返却するLambdaを作成してもらいます。 id,name,value,timestamp 1,da

-

LLM で長文から構造化データを抽出する - DROBEプロダクト開発ブログ

はじめに こんにちは、DROBE の都筑です。 みなさん LLM 使っていますか。今回は LLM を利用して長文から構造化データを抽出する手法について記載します。 構造化データの抽出 LLM を利用して構造化データを抽出することを Extraction と呼びます。 Extraction は以下のようなユースケースが考えられます。 テキスト情報から構造化したデータを抽出し DB にインサートする 外部 API を呼ぶために入力を解釈してパラメータを抽出する Extraction は非常に有用ですが、元となるテキストの最大長は利用する LLM の最大 token 数に依存します。 LLM と長文の処理 長文を LLM で扱うユースケースとしては文章要約がアプリケーションとして想定されることが多く、いくつかの方法が考案されています。LangChain の公式ドキュメントを覗くと、以下の 3 つ

-

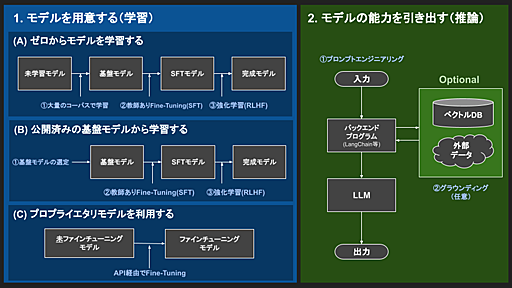

LLM開発のフロー | フューチャー技術ブログ

はじめにこんにちは、SAIG/MLOpsチームでアルバイトをしている板野・平野です。 今回は、昨今注目されている大規模言語モデル(LLM)の開発においてMLOpsチームがやるべきことを考えるため、まずはLLM開発の流れを調査・整理しました。 本記事はその内容を「LLM開発のフロー」という題目でまとめたものです。LLMを本番運用するときに考慮すべきこと、LLM開発・運用を支援するサービスやツール・LLMシステムの構成例などについては、「LLM開発でMLOpsチームがやるべきこと」と題して別記事でご紹介していますので、ぜひ併せてご覧ください。 ここでのLLM開発とは、「LLM自体の開発」および「LLMを活用したシステム開発」の両方を含みます。また、「LLM自体の開発」は学習フェーズ、「LLMを活用したシステム開発」は推論フェーズ、として記載しています。 本記事ではLLM開発における各フェーズの

-

llama2のファインチューニング(QLORA)のメモ|Kan Hatakeyama

2023/11/13追記以下の記事は、Llama2が公開されて数日後に書いた内容です。 公開から数ヶ月経った23年11月時点では、諸々の洗練された方法が出てきていますので、そちらも参照されることをおすすめします。 (以下、元記事です) 話題のLamma2をファインチューニングします。 QLoRAライブラリを使うパターンと、公式推奨の2つを試しました。前者が個人的にはオススメです。 前提Hugging faceで配布されている公式のモデルが必要です。以下を参考に、ダウンロードしておきます。 データセット作成 (7/20 15:20追記 設定ミスってたので修正しました) test.jsonを適当に作ります。 [ { "input": "", "output": "### Human: 富士山といえば?### Assistant: なすび" }, { "input": "", "output":

-

【Techの道も一歩から】第11回「言語処理でのちょっとした前処理」 - Sansan株式会社 | 公式メディア「mimi」

こんにちは。DSOC R&Dグループの高橋寛治です。 形態素解析や系列ラベリングの際の素性抽出などでは、いつも似たようなコードを書きがちです。 今回はその作業を減らすための備忘録として、これらのちょっとした前処理について紹介します。 形態素解析 日本語を対象にした自然言語処理における形態素解析とは、単語分割と品詞付与を指しています。 日本語は単語に分かち書きされていないため、ほとんどのタスクの前段となる非常に重要な処理です。 Pythonで日本語形態素解析を行う際には、MeCabやPure PythonのJanomeがよく使われるかと思います。 私は、MeCabのPython 3バインディングであるmecab-python3をよく使います。 シンプルなインタフェースでMeCabの形態素解析機能がPythonで利用可能です。 まずは、mecab-python3を用いて形態素解析を行い、得られ

-

高速な文字列探索:Daachorseの技術解説 - LegalOn Technologies Engineering Blog

こんにちは。LegalForce Researchで研究員をしている神田 (@kampersanda) です。 LegalForce Researchでは現在、高速なパターンマッチングマシン Daachorse(ダークホース)を開発・運用しています。文字列処理の基礎である複数パターン検索を提供するRust製ライブラリです。以下のレポジトリで公開されています。 github.com 本記事はDaachorseの技術仕様を解説します。具体的には、 複数パターン検索に関係する基礎技術(トライ木・Aho–Corasick法・ダブル配列) Daachorseの実装の工夫と性能 を解説します。 以下のような方を読者として想定します。 文字列処理アルゴリズムやデータ構造に興味のある方 自然言語処理の要素技術に興味のある方 Rustライブラリに興味がある方 Daachorseについて 複数パターン検索の基

-

Elasticsearchで日本語を同義語展開する

全文検索における同義語展開の必要性 全文検索では、基本的に文字列のマッチにより検索を行います。しかし我々が言葉を扱うときには、同じものを違う表現で指し示すことが多々あります。 例えば「独占禁止法」と呼ばれる法律があります。これは経済憲法とも言われる大変重要な法律なのですが、日本では「昭和二十二年法律第五十四号(私的独占の禁止及び公正取引の確保に関する法律)」という法律がそれに該当し、独占禁止法という名前にはなっていません。これを皆、「独占禁止法」や「独禁法」といった代替可能な別表現(同義語)で呼んでいるわけです。 同法律には法令用語で言うところの「題名」は付されておらず、頭書の名称は制定時の公布文から引用したいわゆる「件名」である。独占禁止法ないし独禁法と略称されることも多い。 もし「独禁法」で検索して当該法律がヒットしなければ、ユーザーとしては不満足でしょう。検索システムのクオリティを向

-

spaCyのDependencyMatcherでレビュー文から情報を抽出してみる

これは、自然言語処理 Advent Calendar 2021の20日目の記事です。 新卒2年目のエンジニア、吉成です。 普段はフォルシアのDXプラットフォーム部・技術研究所という2つの部署に所属し、web開発と自然言語処理の二足の草鞋を履いています。二兎を追う者は一兎をも得ずという言葉もありますが、今はひーひー言いながらも二兎を追えるエンジニアを目指しています。 ところで皆さん、依存構造解析してますか? 依存構造解析は自然言語処理の実応用において重要な基礎解析の1つです。文中のどの単語(あるいは句)がどの単語(句)に依存しているか、またそれらの単語(句)間はどんな関係を持っているのか(依存構造)を解析します。一般的に依存構造解析は、文を単語や形態素に分割したり、単語や形態素に品詞のラベルを付与したりする形態素解析と呼ばれる処理の後に行われます。 (画像:「部屋から見える夜景が美しかった。

-

Ginzaで形態素解析、係り受け解析、固有表現抽出、ユーザー辞書追加 - iMind Developers Blog

概要 Ginzaを使ってNLPでよく使ういくつかの処理を動かしてみる。 バージョン情報 ginza==2.2.0 Python 3.7.4 インストール pipで入れられる。 $ pip install "https://github.com/megagonlabs/ginza/releases/download/latest/ginza-latest.tar.gz" 詳細は下記参照。 https://megagonlabs.github.io/ginza/ 形態素解析 Ginzaは内部的にはSudachiPyを利用している。 import spacy nlp = spacy.load('ja_ginza') doc = nlp('庭にいる犬が鳴いてる') for sent in doc.sents: for token in sent: print( 'token.i={}'.forma

-

言語処理100本ノック(2024年度)

Copied from: Public/Study NLP100 2023 実践的な課題に取り組みながら,プログラミング,データ分析,研究のスキルを楽しく習得することを目指します.具体的には, Unix環境でのターミナルの操作. 研究室の実験環境の体験. Pythonプログラミングのチュートリアル. Pythonの実行環境のインストール. Pythonの基礎. Jupyter notebook, IPython, pipの使い方など. この勉強会では言語処理100本ノック 2020を教材として用います.自然言語処理に関するプログラムを実際に作ってもらい,互いにコードレビューを行います. 問題に対する答えは一つではありません.どんな方法でも構いませんので,自力で問題を解き,他人のコードを読むことで,よいプログラムとは何かを体感してください. This study group aims at

-

トピックモデルを使って問い合わせ内容を分析した話 - Classi開発者ブログ

この記事はClassi developers Advent Calendar 2021の18日目の記事です。 昨日は基盤インフラチームのめるさんによる「バックエンドエンジニアが基盤インフラチームに異動して半年ほど経った話」でした。 こんにちは、データAI部でデータサイエンティストをしている高木です。 弊社では顧客である先生、生徒、保護者からClassiの機能や契約に関する問い合わせを日々頂いております。 これらの問い合わせの内容を分析し、Classiの現状の課題や今後解決していくための施策などを社内で検討しています。 今回は問い合わせ内容を言語処理技術の一つであるトピックモデルを使って分析した内容についてご紹介します。 なぜ分析する必要があったのか? Classiへの問い合わせやその対応の内容は、担当者によってテキスト化された状態で管理されています。 弊社のカスタマーサポート・カスタマーサ

-

ヤフーにおける自然言語処理モデルBERTの利用

ヤフー株式会社は、2023年10月1日にLINEヤフー株式会社になりました。LINEヤフー株式会社の新しいブログはこちらです。LINEヤフー Tech Blog こんにちは。Yahoo! JAPAN研究所で自然言語処理の研究開発をしている柴田です。 私は自然言語処理の研究と、最新の自然言語処理技術を社内のサービスに適用できるようにする開発の両方を行っています。今日は後者の話をします。 この記事ではBERTというモデルに焦点をあて、BERTの概要と、社内でのBERTの利用、最後に具体例として検索クエリのカテゴリ分類について紹介します。 ※この記事で取り扱っているデータは、プライバシーポリシーの範囲内で取得したデータを個人が特定できない状態に加工しています。 1. BERTとは 2018年にGoogleからBERT (Bidirectional Encoder Representations

公式Twitter

- @HatenaBookmark

リリース、障害情報などのサービスのお知らせ

- @hatebu

最新の人気エントリーの配信

処理を実行中です

キーボードショートカット一覧

j次のブックマーク

k前のブックマーク

lあとで読む

eコメント一覧を開く

oページを開く