Regresion Lineal

Regresion Lineal

Cargado por

nicoulloalCopyright:

Formatos disponibles

Regresion Lineal

Regresion Lineal

Cargado por

nicoulloalTítulo original

Derechos de autor

Formatos disponibles

Compartir este documento

Compartir o incrustar documentos

¿Le pareció útil este documento?

¿Este contenido es inapropiado?

Copyright:

Formatos disponibles

Regresion Lineal

Regresion Lineal

Cargado por

nicoulloalCopyright:

Formatos disponibles

PONTIFICIA UNIVERSIDAD CATOLICA DE CHILE

FACULTAD DE AGRONOMIA E INGENIERIA FORESTAL

DEPARTAMENTO DE CIENCIAS FORESTALES

REGRESIÓN LINEAL

APUNTES DE CLASES

Horacio Gilabert

Magíster en Recursos Naturales – Econometría

PONTIFICIA UNIVERSIDAD CATOLICA DE CHILE

FACULTAD DE AGRONOMIA E INGENIERIA FORESTAL

DEPARTAMENTO DE CIENCIAS FORESTALES

Análisis de Regresión Lineal

Indice

1. La regresión lineal (RL) como modelo de predicción .........................................................3

2. El modelo de regresión lineal simple (RLS) ........................................................................6

2.1 Modelo de regresión lineal simple (RLS) ..................................................................7

2.2 Significado de los parámetros del modelo .................................................................8

2.3 Estimación de los parámetros del modelo RLS: Método de Mínimos Cuadrados

Ordinarios (MCO).................................................................................................................8

2.4 Precisión del Modelo de Regresión ......................................................................... 10

3. Inferencia en el modelo RLS ............................................................................................... 12

3.1 Distribución del estimador b1 ................................................................................. 13

3.2 Intervalos de confianza para 1 .............................................................................. 13

3.3 Pruebas de hipótesis para 1 ................................................................................... 14

3.4 Distribución del estimador b0 ................................................................................. 14

3.5 Intervalos de confianza para E(Y) = 0 + 1X ....................................................... 15

3.6 Intervalos de confianza para una nueva observación, Y ....................................... 16

3.7 Análisis de varianza (ANDEVA) del modelo RLS .................................................. 16

3.8 Prueba F de 1=0 vs 1≠0 ....................................................................................... 18

4. Modelo de regresión lineal múltiple (RLM) ................................................................... 22

4.1 El modelo de regresión lineal múltiple (RLM) ....................................................... 22

4.2 Uso de matrices y estimación de los coeficientes de regresión por Cuadrados

Mínimos ............................................................................................................................... 26

4.3 Valores estimados, residuos y ANDEVA ................................................................ 26

5. Inferencia en el modelo RLM ......................................................................................... 30

5.1 ANDEVA .................................................................................................................. 30

5.2 Inferencias respecto de los parámetros de regresión .............................................. 30

5.3 Intervalos de confianza para E(Y), y para una nueva observación Y.................... 32

5.3.1 Respuesta esperada, E(Y) ................................................................................ 32

5.3.2 Predicción de una nueva observación en Y, Yh(n) ............................................ 33

5.4 Coeficiente de determinación múltiple (R2) ............................................................ 34

5.5 Suma de Cuadrados Extra ...................................................................................... 35

5.5.1 Uso de la suma de cuadrados extra en la prueba de hipótesis i=0 ................ 37

6. Violaciones a los supuestos del modelo RLM: diagnósticos y alternativas.................... 39

6.1 Multicolinealidad y sus Efectos ............................................................................... 43

6.1.1 Efectos de la Multicolinealidad ........................................................................ 45

6.1.2 Diagnóstico de Multicolinealidad .................................................................... 46

6.1.3 Medidas de Corrección .................................................................................... 47

Magíster en Recursos Naturales – Econometría

PONTIFICIA UNIVERSIDAD CATOLICA DE CHILE

FACULTAD DE AGRONOMIA E INGENIERIA FORESTAL

DEPARTAMENTO DE CIENCIAS FORESTALES

1. La regresión lineal (RL) como modelo de predicción 1

La regresión lineal es un método o una técnica que sirve para obtener una relación matemática entre

una variable dependiente (respuesta) y un conjunto de variables independientes (predictoras). La

relación involucra la determinación de una serie de parámetros desconocidos i, que relacionan el valor

de la variable dependiente Y con el valor de la(s) variables independientes (Xi). En general este tipo de

funciones se utilizan para predecir o estimar el valor de la variable dependiente a partir de una serie (1 o

más) de variables independientes. La expresión general del modelo es:

Y 0 1 X 1 2 X 2 ... p X p

Y : Variable dependiente (respuesta).

Xi : Variables independientes (predictoras).

i : Parámetros del modelo.

: Error de estimación (aleatorio)

Este es el modelo de regresión lineal múltiple (RLM) que contempla más de una variable independiente

que en el caso del modelo RLS es una sola. La relación matemática es lineal en los parámetros

desconocidos i) — y por esto se habla de un modelo de regresión lineal — pero no necesariamente en

las variables. Por ejemplo es posible tener un modelo con las siguientes variables:

Y 0 1 X 1

Y = Log(altura del árbol)

X1 = (diámetro del árbol)2

La variación en las variables independientes se "transmite" a la variable dependiente (su

comportamiento) pero generalmente no es posible explicar toda la variación de Y en función de la

variación en las Xi. Por consiguiente, el error de estimación (i) es un componente importante del modelo

lineal. Entre las ventajas más importantes de un modelo lineal están:

1. La mayoría de los problemas industriales pueden ser aproximados por un modelo lineal

(dentro de un rango de variación debidamente acotado). Por ejemplo, si el costo de producción de

un proceso que cambia de tecnología según el nivel de producción corresponde a Y = (x)*X,

entonces es posible aproximar el comportamiento del sistema por Y = 1*X*I1 + , ..., + n*X*I n

donde Ii = 1 si X {Ai} y 0 de lo contrario. Por lo tanto, un problema no lineal puede ser

modelado como una serie de modelos lineales tal como se ve en la figura 1.

2. Se dispone de métodos matemáticos (Álgebra Lineal) que permiten manipular eficientemente

1

Partes de este capitulo contienen material escrito originalmente por el Ingeniero Forestal (Ph.D) André Laroze para

el curso Análisis de Regresión de la FAIF-PUC.

Magíster en Recursos Naturales – Econometría

PONTIFICIA UNIVERSIDAD CATOLICA DE CHILE

FACULTAD DE AGRONOMIA E INGENIERIA FORESTAL

DEPARTAMENTO DE CIENCIAS FORESTALES

gran cantidad de datos (bajo las condiciones del modelo lineal). Un claro ejemplo es la solución

de sistemas de ecuaciones lineales.

X

A1 A2 A3

Figura 1. Aproximación de una relación no lineal mediante aproximaciones lineales

En último término los objetivos del análisis de regresión lineal son tres:

1. Estimar los parámetros desconocidos del modelo en base a los datos disponibles y ciertos

supuestos acerca del comportamiento del sistema.

2. Determinar como afectan los cambios en una variable independiente el valor de la variable

dependiente.

3. Determinar la calidad predictiva del modelo y validar los supuestos utilizados para su generación

(y si no se cumplen analizar en que medida la violación de los supuestos afecta la capacidad

explicativa del modelo)

Antes de pasar a la sección en la que se define el modelo RLS es necesario hacer una distinción que aclara

lo que denominamos relación matemática entre dos variables. En este contexto se pueden distinguir

dos tipos de relaciones entre dos variables X e Y, relaciones funcionales y relaciones estadísticas. Una

relación funcional se expresa mediante una fórmula como la siguiente:

Y f X

Donde Y es la variable dependiente, X es la variable independiente y f() es una función. La característica

más importante de este tipo de relaciones es que para cada valor de X, la función entrega un valor

único para Y. Así, al graficar los valores de X e Y generados usando la función se encuentra que todos

los pares XY caen sobre una curva. Por ejemplo si X es el lado de un cuadrado e Y es el área del

cuadrado, la relación funcional entre X e Y es Y = X2, que puede verse en la figura 2.

Magíster en Recursos Naturales – Econometría

PONTIFICIA UNIVERSIDAD CATOLICA DE CHILE

FACULTAD DE AGRONOMIA E INGENIERIA FORESTAL

DEPARTAMENTO DE CIENCIAS FORESTALES

60

49

50

40 36

Y

30 25

20 16

9

10

4

1

0

0 1 2 3 4 5 6 7 8

Figura 2. Relación funcional entre X e Y (Y = X2)

En este gráfico la relación entre X e Y es determinística. Esto quiere decir que el valor de X determina

inequívocamente cuál es el valor de Y, y por esto todos los puntos caen en una sola curva, definida por la

función Y=f(X).

El caso alternativo es el de relación estadística, donde la relación no es perfecta. En este tipo de

relaciones los puntos (X,Y) no caen sobre una curva sino que conforman una nube de puntos, que puede o

no tener alguna tendencia notoria. La figura 3 muestra la relación que existe entre el diámetro (dap) sin

corteza y la altura total de árboles de Pino Oregón. En este gráfico se observa que para un determinado

valor de X (dap s/c) existe potencialmente más de un valor de Y (altura total). La variabilidad natural de

los individuos lleva a que para cada diámetro existen árboles con distintas alturas y para cada altura

existen varios árboles con diferente diámetro. En este caso la pregunta lógica es qué opciones se tienen

para estimar la altura a partir del diámetro. El análisis de regresión proporciona criterios objetivos

para estimar parámetros y responder estas preguntas.

Finalmente este tipo de relaciones son aquellas en las que estamos interesados ya que en presencia de más

de un valor potencial u observado para la variable dependiente en función de la o las variables

independientes resulta lógico tratar de estimar el valor más probable de entre los valores posibles para Y.

La regresión lineal es en último término un instrumento (matemático) de predicción.

Magíster en Recursos Naturales – Econometría

PONTIFICIA UNIVERSIDAD CATOLICA DE CHILE

FACULTAD DE AGRONOMIA E INGENIERIA FORESTAL

DEPARTAMENTO DE CIENCIAS FORESTALES

25

20

Altura total, m

15

10

0

0 10 20 30 40 50

dap s/c,cm

Figura 3. Relación estadística entre el dap y la altura de árboles.

Esta parte del curso esta estructurada en 5 secciones que pretenden introducir los conceptos básicos del

análisis de regresión en forma gradual y en creciente grado de complejidad. La primera sección presenta

el modelo de regresión lineal simple con sus supuestos y que constituye la forma más simple de análisis

usando regresión lineal. La sección siguiente trata el problema de inferencia (prueba de hipótesis e

intervalos de confianza) y se introduce para esto el supuesto de normalidad de los errores aleatorios i. En

esta sección se introduce además el análisis de varianza para el análisis de regresión simple, concepto que

es aplicable también al caso de regresión múltiple que constituye la sección siguiente a la de inferencia.

En la sección del modelo de regresión múltiple (RLM) se introducen los conceptos básicos de este

modelo y se presenta la notación matricial con la que habitualmente es presentado. De la misma forma

que para el modelo RLS, la sección siguiente es de inferencia en el modelo RLM y se introduce el

concepto de suma de cuadrados extra. La ultima sección se concentra en los supuestos del modelo RLM y

propone herramientas de diagnostico de violaciones a estos supuesto y medidas de corrección.

2. El modelo de regresión lineal simple (RLS)

Un modelo de regresión es una manera de expresar formalmente dos elementos de una relación entre una

variable (dependiente) y una o un conjunto de variables (independientes). El primer elemento es la

tendencia de los valores de la variable dependiente a variar sistemáticamente con los valores de la

variable independiente. El segundo elemento es el agrupamiento de los pares (X,Y) en torno a una curva

que define la relación entre ambas variables. El modelo de regresión incorpora estos dos elementos

postulando que existe una distribución de probabilidad de los Y para cada nivel de X y que las

medias de esta distribución varían sistemáticamente con el valor de X.

La existencia de una relación estadística entre la variable dependiente Y y la variable independiente X no

implica que Y depende en forma funcional de X, i.e., no implica una relación causa-efecto. Si es

importante diferenciar entre los que llamamos variable dependiente y variable(s) independiente(s). La

relación básica es de variación conjunta y sistemática de Y con X y la distinción es que se asume que el

Magíster en Recursos Naturales – Econometría

PONTIFICIA UNIVERSIDAD CATOLICA DE CHILE

FACULTAD DE AGRONOMIA E INGENIERIA FORESTAL

DEPARTAMENTO DE CIENCIAS FORESTALES

valor de Y varía sistemáticamente con el valor de X, pero no lo contrario. Por ejemplo, en la relación

entre presión sanguínea y edad se puede asumir que la variable independiente es la edad y la dependiente

es la presión. Si bien se puede pensar que la presión sanguínea de una persona puede ser una función de la

edad, no es razonable asumir que la edad puede ser determinada por la presión. Esta distinción es básica.

2.1 Modelo de regresión lineal simple (RLS)

El modelo RLS considera sólo una variable independiente y tiene las siguientes características

(Netter et al., 1996):

1. El valor de Yi es descompuesto en dos componentes, el valor constante 0+1Xi y el término

aleatorio i. Por lo tanto Yi es también una variable aleatoria.

2. Dado que E(i)=0, se deriva que E(Yi)=0+1Xi. Por lo tanto la variable Yi cuando el valor de

la variable X es Xi proviene de una distribución cuya media es E(Yi)=0+1Xi, que puede ser

expresada también como E(Yi|Xi)=0+1Xi.

3. La diferencia entre el valor de la variable dependiente Yi y el valor estimado por el modelo RLS

es igual a i.

4. Se asume que los términos de error i tienen varianza única 2 y por lo tanto la variable Yi tiene

también varianza única igual a 2.

5. Se asume que los términos i y j son no correlacionados y por lo tanto Yi no está correlacionado

con Yj, para todo i ≠ j.

6. En resumen el modelo RLS implica que Yi proviene de una distribución con medias (o

esperanza) iguales a E(Yi)=0+1Xi y con varianzas iguales a 2, donde Yi e Yj no se

correlacionan (Cov(Yi, Yj)=0).

La figura 5 resume la mayor parte de las propiedades del modelo RLS. En general al valor E(Yi) se le

llama valor predicho o estimado de Yi que se puede simbolizar de ahora en adelante como Yˆi (Yi gorro).

Yi

i

E(Yi)

Yi=0+1Xi

X

Xi

Figura 5. Elementos del modelo RLS

Magíster en Recursos Naturales – Econometría

PONTIFICIA UNIVERSIDAD CATOLICA DE CHILE

FACULTAD DE AGRONOMIA E INGENIERIA FORESTAL

DEPARTAMENTO DE CIENCIAS FORESTALES

2.2 Significado de los parámetros del modelo

Los parámetros 0 y 1 son llamados coeficientes de regresión y tienen una interpretación geométrica.

El coeficiente 1 es la pendiente de la recta de regresión y representa la tasa de cambio de la media de la

distribución de probabilidad de los Y por unidad de incremento de X. El coeficiente 0 es llamado

intercepto y representa la media condicional de Y cuando X=0, donde este sea un valor incluido en el

rango de valores de X. La siguiente figura muestra los datos y la curva de regresión ajustada entre la edad

como variable independiente y la altura total como variable independiente para 23 individuos de Pino

Oregón creciendo en un bosque natural de Idaho, USA.

45

40

35

30

Altura

25

20

15 A

10

1=A/B

5 B

0

0

0 20 40 60 80 100 120 140

Edad

Altura Pronóstico Altura

Figura 6. Datos y línea de regresión para 23 árboles

El modelo ajustado es Altura 2.6884 0.3008 Edad y la figura indica los valores en el gráfico. El

intercepto representa la altura de un árbol cuando la Edad es cero y la pendiente (1) representa el

incremento en altura por año.

2.3 Estimación de los parámetros del modelo RLS: Método de Mínimos Cuadrados Ordinarios

(MCO)

En la sección introductoria mencionamos que una de las ventajas más notables de trabajar con modelos

lineales es que existen métodos matemáticos para manipular gran cantidad de datos y que existen métodos

eficientes para estimar los parámetros del modelo. Asimismo se cuenta con criterios objetivos para juzgar

la calidad del modelo y validar su capacidad de predicción. El método de mínimos cuadrados ordinarios

es el más conocido de los métodos para estimar el valor de los parámetros 0 y 1 en el contexto del

modelo RLS. Además utiliza un argumento teóricamente robusto e intuitivo que es fácil de interpretar. El

Magíster en Recursos Naturales – Econometría

PONTIFICIA UNIVERSIDAD CATOLICA DE CHILE

FACULTAD DE AGRONOMIA E INGENIERIA FORESTAL

DEPARTAMENTO DE CIENCIAS FORESTALES

modelo RLS fue planteado como:

Yi 0 1 X i i

Existen distintos criterios para estimar el valor de los parámetros desconocidos 0 y 1, varios métodos

de estimación que generan distintos estimadores. Así, el método de máxima verosimilitud (MV) genera

los estimadores de MV. En el caso de los estimadores MCO el criterio es minimizar la suma del

cuadrado de los errores de estimación i para toda la información disponible. Es decir, se buscan los

valores de 0 y 1 que minimicen la suma S de los cuadrados de los errores i para los n pares de

observaciones (Xi,Yi):

2 i 1 Yi 0 1 X i

n n 2

Minimizar: S i 1 i

Este es un problema de optimización no acotada que se puede resolver usando métodos numéricos o bien

derivando S con respecto a los parámetros, igualando a cero y despejando 0 y 1.

Veamos un ejemplo. La siguiente tabla contiene los datos de edad y altura de los 23 árboles que se

observan en la figura 6.

Datos de edad y altura para 23 árboles

Edad, X Altura, Y Edad, X Altura, Y

56 27.04 85 32.61

83 27.42 123 39.81

74 21.23 87 31.70

81 24.96 91 30.18

81 29.99 16 4.95

87 28.07 14 5.26

82 23.43 14 5.58

83 32.45 15 6.47

91 30.10 19 8.91

75 25.85 85 33.30

83 31.83 96 19.39

108 31.35

Las sumatorias y datos correspondientes son:

X 1629 X 2

138143

Y 551.8 Y 2

15668.22

XY 45934.18 n 23

Entonces,

b1= (45934.18 – (1629*551.8)/23) / (138143-(16292)/23) = 0.3008

b0 = (551.8)/23 – 0.3008*(1629/23) = 2.687

Magíster en Recursos Naturales – Econometría

PONTIFICIA UNIVERSIDAD CATOLICA DE CHILE

FACULTAD DE AGRONOMIA E INGENIERIA FORESTAL

DEPARTAMENTO DE CIENCIAS FORESTALES

Las diferencias con los valores estimados en la sección anterior se deben a las aproximaciones en los

términos intermedios.

Este modelo permite obtener entonces estimadores de los valores poblacionales 0, 1, y i:

ˆ 0 b0

ˆ1 b1

ˆi ei Yi Yˆi Yi b0 b1X i

n 2

e

ˆ 2

i 1 i

n2

(recuerda que el “gorro” significa “estimado”)

El modelo ajustado por MCO tiene las siguientes propiedades:

1. e 0

i

2. e es mínimo

2

i

3. Y Yˆ

i i

4. X e Yˆ e 0

i i i i

5. La regresión siempre pasa por el punto X , Y

2.4 Precisión del Modelo de Regresión

En cualquier regresión se observara variación de la respuesta Yi. La desviación de cada observación Yi

respecto del promedio ( Yi Y ) tiene dos componentes:

1. La diferencia del valor observado (Yi) con respecto la valor estimado ( Yˆi ), Yi- Yˆi = ei

2. La diferencia del valor estimado ( Yˆi ) con respecto al promedio ( Y ), Yˆi Y

La siguiente relación se cumple para todo i, y se puede observar en la figura 7 (donde E(Yi) se asimila al

Y estimado o Yˆi e Yp se asimila al Y promedio o Y ) :

Yi Y Yi Yˆi Yˆi Y

Magíster en Recursos Naturales – Econometría

PONTIFICIA UNIVERSIDAD CATOLICA DE CHILE

FACULTAD DE AGRONOMIA E INGENIERIA FORESTAL

DEPARTAMENTO DE CIENCIAS FORESTALES

Yi

i

E(Yi)

E(Yi)-Yp Yi=0+1Xi

Yp

X

Xi

Figura 7. Elementos del modelo RLS

Además se cumple la siguiente relación:

Y

n

i 1 i Y Y Yˆ Yˆ Y

2 n

i 1 i i

2 n

i 1 i

2

Por consiguiente, la suma del cuadrado de las desviaciones del valor observado con respecto al promedio

(suma de cuadrados corregida) es igual a la suma del cuadrado de las desviaciones del valor estimado con

respecto a la media (suma de cuadrados debida a la regresión o variación explicada) más la suma del

cuadrado de las desviaciones del valor observado con respecto al valor estimado (suma de cuadrados

residuales o variación no-explicada).

Una forma de evaluar la capacidad predictiva del modelo es determinar que proporción de la variación de

las observaciones con respecto al promedio es explicada por la regresión evaluada a través del índice R2:

Y Yˆ

n 2

i 1 i i

Coeficiente de determinación: R 2

Y Y

n 2

i 1 i

Mientras mayor es el valor de R2 ( 1) mejor es el modelo ya que explica una mayor proporción de la

variabilidad de los valores observados Yi. Este coeficiente — y su interpretación— será descrito en más

detalle en las secciones siguientes de esta parte del curso.

Ver documento RLS

Magíster en Recursos Naturales – Econometría

PONTIFICIA UNIVERSIDAD CATOLICA DE CHILE

FACULTAD DE AGRONOMIA E INGENIERIA FORESTAL

DEPARTAMENTO DE CIENCIAS FORESTALES

3. Inferencia en el modelo RLS

No importa cual sea la forma de la distribución de los errores i (y por lo tanto de los valores observados

Yi), el método de MCO entrega b0 y b1 que son estimadores insesgados de 0 y 1 y que son además

estimadores de mínima varianza entre los estimadores lineales insesgados (teorema de Gauss-

Markov).

Sin embargo para calcular intervalos de confianza y hacer pruebas de hipótesis en este modelo es

necesario hacer algún supuesto respecto de la forma de la distribución de los errores aleatorios i. El

supuesto estándar es que los errores tienen distribución normal, supuesto que es justificable en gran

parte de las situaciones donde se aplica análisis de regresión y que simplifica enormemente la teoría de

regresión, incluyendo la de inferencia. Recordemos que se ha asumido hasta ahora del modelo RLS.

El modelo es:

Yi 0 1 X i i

Yi es el valor de la variable dependiente en la i-ésima observación,

Xi es el valor de la variable independiente en la i-ésima observación, un valor conocido,

i es un término de error aleatorio con las siguientes características:

a. E(i)=0

b. Var(i)=2

c. Cov(i,j)=0 para todo i ≠ j, i=1,…..,n

0, 1 son los parámetros del modelo.

En este momento (y de ahora en adelante) se reemplazan los supuestos a,b y c de los errores por el

siguiente:

Los i son variables aleatorias (v.a.) independientes N(0, 2), es decir los errores son variables

aleatorias independientes y se distribuyen normalmente con media cero y varianza sigma cuadrado.

El modelo definido de esta manera se denomina modelo de RLS con errores normales. Nótese que:

Dado que se asume que los errores son normales, el supuesto inicial de no correlación entre

errores se convierte en el de independencia en este modelo,

Este ultimo supuesto implica que los valores observados Yi son v.a. normales independientes con

media (esperanza) igual a 0+1Xi y varianza 2,

El supuesto de normalidad para i se justifica en muchas situaciones porque este termino de error

representa los efectos de los factores omitidos en el modelo y que pueden afectar el valor de la

variable dependiente (Y), y que varían aleatoriamente sin relacionarse con el valor de X.

Magíster en Recursos Naturales – Econometría

PONTIFICIA UNIVERSIDAD CATOLICA DE CHILE

FACULTAD DE AGRONOMIA E INGENIERIA FORESTAL

DEPARTAMENTO DE CIENCIAS FORESTALES

Bajo el supuesto adicional de normalidad de los errores, es posible proponer intervalos de confianza y

pruebas de hipótesis para 0, 1 y las observaciones Yi.

3.1 Distribución del estimador b1

En el modelo de RLS la prueba de hipótesis más relevante es:

H0: 1 = 0 y Ha: 1 0

Para esto, es necesario conocer la distribución del estimador b1 bajo H 0. En la sección anterior se muestra

que b1 es un estimador obtenido como una combinación lineal de los Yi, es decir como una combinación

de v.a. independientes que se distribuyen ~ N(0+1Xi, 2).

Dado que la combinación lineal de n v.a. normales independientes también se distribuye normalmente

tenemos que b1 se distribuye normalmente. Es decir:

b1 ~ N 1,

2

, donde S xx i 1 X i X

n

2

S xx

2 b1 1

Entonces dado que b1 ~ N 1, , tenemos que ~ N (0,1) . Sin embargo, la varianza 2 es

S xx 2

S xx

n 2

e

un parámetro desconocido que es estimado por la expresión ˆ 2

i 1 i

, que veremos mas adelante se

n2

llama cuadrado medio del error, CME.

b1 1

De esta manera tenemos que finalmente la expresión ~ t (n 2) , donde SE b1 CME

SE b1 S xx

Es decir la expresión anterior tiene una distribución t-Student con (n-2) grados de libertad.

3.2 Intervalos de confianza para 1

De la sección anterior tenemos que:

b1 1

1. ~ t (n 2) . Esto implica que

SE b1

b1 1

2. P t / 2; n 2 t 1 / 2; n 2 1

SE b1

Magíster en Recursos Naturales – Econometría

PONTIFICIA UNIVERSIDAD CATOLICA DE CHILE

FACULTAD DE AGRONOMIA E INGENIERIA FORESTAL

DEPARTAMENTO DE CIENCIAS FORESTALES

3. Usando la simetría de la distribución t-Student tenemos que t(/2; n-2)=-t(1-/2; n-2) y por lo

tanto los limites confidenciales 1- para 1 son:

b1 t 1 / 2; n 2 SE b1

3.3 Pruebas de hipótesis para 1

Prueba a dos colas: H 0 : 1 0 vs. H a : 1 0

b1

o Estadístico: T

SE b1

o Regla de decisión (al nivel de significancia )

Si |T| t(1-/2; n-2), no se puede rechazar H0,

Si |T| > t(1-/2; n-2), rechazar H0.

Prueba a una cola: H 0 : 1 0 vs. H a : 1 0

b1

o Estadístico: T

SE b1

o Regla de decisión (al nivel de significancia )

Si T t(1-; n-2), no se puede rechazar H0,

Si T > t(1-; n-2), rechazar H0.

Prueba cuando: H 0 : 1 1A o H 0 : 1 1A

b1 1A

o Estadístico: T ~ t n 2

SE b1

o Regla de decisión (al nivel de significancia )

Si T t(1-; n-2), no se puede rechazar H0,

Si T > t(1-; n-2), rechazar H0.

3.4 Distribución del estimador b0

El estimador para 0 es b0, y recordemos que:

b0 Y b1 X

Por el mismo argumento con cuál se derivaron los estimadores de la esperanza y varianza de b1

(combinación lineal de las v.a. normales independientes Yi), se encuentra que:

Magíster en Recursos Naturales – Econometría

PONTIFICIA UNIVERSIDAD CATOLICA DE CHILE

FACULTAD DE AGRONOMIA E INGENIERIA FORESTAL

DEPARTAMENTO DE CIENCIAS FORESTALES

X

2

2 1

b0 ~ N 0,

n S xx

Entonces, sabiendo que el estimador de 2 es CME se tiene que el intervalo de confianza al nivel de

confianza (1-) para 0 es:

1 X 2

b0 t 1 / 2, n 2 SEb0 , donde SE b0 CME

n S xx

3.5 Intervalos de confianza para E(Y) = 0 + 1X

El estimador de E(Y) = 0 + 1X, que llamamos Y gorro es:

Yˆ b0 b1X

Los estimadores de b0 y b1 son combinaciones lineales de los valores observados Yi. Entonces b0+b1*Xi

es también una combinación lineal de Yi y tiene por lo tanto una distribución normal. De esta manera se

pueden derivar la esperanza y la varianza de Y gorro:

E Yˆ E b0 b1X E 0 1X

Var Yˆ 2

1

X X 2

n S xx

Usando CME como estimador de 2, tenemos finalmente que:

SEYˆ 2 1 X X

CME

2

n S xx

Entonces el intervalo de confianza (1-) es:

Yˆ t 1 / 2, n 2 SE Yˆ

Un estadístico de test para H 0 : E Yˆ YˆA vs H a : E Yˆ YˆA es:

Yˆ YˆA

T ~ t n 2

SE Yˆ

Donde:

o Regla de decisión (al nivel de significancia )

Si T t(1-; n-2), no se puede rechazar H0,

Magíster en Recursos Naturales – Econometría

PONTIFICIA UNIVERSIDAD CATOLICA DE CHILE

FACULTAD DE AGRONOMIA E INGENIERIA FORESTAL

DEPARTAMENTO DE CIENCIAS FORESTALES

Si T > t(1-; n-2), rechazar H0.

3.6 Intervalos de confianza para una nueva observación, Y

Muchas veces hay confusión cuando se usa la palabra predicción. Obviamente el estadístico

Yˆ b0 b1X 0 — un punto en la línea de regresión en X=X 0 — sirve el doble propósito como estimador

de la respuesta esperada (E[Y] en X = X0) y del valor predicho para X= X0. Sin embargo, este valor no es

apropiado para establecer cualquier forma de inferencia en una observación individual de Y (a diferencia

de E[Y]). El contraste es importante ya que E(Y) se refiere a un valor esperado para el nivel de X= X 0 y

en este caso estamos preguntando por un valor individual de Y en X=X 0. Este valor puede ser un valor

particular de interés o un valor futuro de Y para un X no observado. Llamemos a este valor individual Yˆ0 .

Dado que el valor real observado de Y varía alrededor de su esperanza con varianza igual a 2, el valor

predicho de una observación individual sigue siendo igual a b0+b1*X, pero su varianza está dada por:

1 X X

1

2 2

n S xx

Que estimada por la expresión

1 X X

CME 1

2

SE Yˆ 2

n S xx 0

El intervalo de confianza (1-) para el valor Yˆ0 es entonces:

Yˆ0 t 1 / 2, n 2 SE Yˆ0

Y el estadístico para las pruebas de hipótesis H 0 : E Y Yˆ0 es:

T

E Yˆ0 Yˆ0

~ t n 2 , donde E Yˆ0 b0 b1 X 0

SE Yˆ 0

3.7 Análisis de varianza (ANDEVA) del modelo RLS

El ANDEVA está basado en la partición de la suma de cuadrados y los grados de libertad asociados a

la variable de respuesta Y. En cualquier regresión se observa variación en las respuestas Y, y en este

caso pondremos especial atención en la variación de Yˆ e Yi. Recordando la descomposición de la

variación de Yi en torno a su promedio derivada en la sección de Precisión del modelo de regresión se

Magíster en Recursos Naturales – Econometría

PONTIFICIA UNIVERSIDAD CATOLICA DE CHILE

FACULTAD DE AGRONOMIA E INGENIERIA FORESTAL

DEPARTAMENTO DE CIENCIAS FORESTALES

tiene que:

Y Y Y Yˆ Yˆ Y

n 2 n 2 n 2

i 1 i i 1 i i i 1 i

Es decir, la variación de los valores observados Yi en torno a su promedio se puede descomponer en dos

fuentes distintas de variación. La primera es la variación de los valores observados en torno a los

valores estimados por el modelo de regresión (representada por el primer término a la derecha del signo

=) diferencias que conocemos como los errores ei. Expresado de otra manera, la variabilidad de los

valores observados en torno a su esperanza (b0+b1X). El segundo término corresponde a la variación de

los valores estimados (Y gorro) en torno al promedio de los valores observados Y .

Esta partición de la suma de cuadrados se entiende como:

SCTO = SCR + SCE

Y Y

n 2

SCTO = Suma de cuadrados totales = i 1 i

SCR = Suma de cuadrados de la regresión = Yˆ Y

n 2

i 1 i

SCE = Suma de cuadrados del error = Y Yˆ

n 2

i 1 i i

Si todas las observaciones son iguales se tiene que SCTO = 0, y entonces mientras mayor sea la variación

de los Yi en torno a su promedio mayor será el valor de esta suma de cuadrados. Entonces, SCTO es una

medida de la incertidumbre asociada a Yi cuando no se toma en cuenta su relación con la variable

independiente X. Cuando se utiliza la variable independiente X, la variación que refleja la incertidumbre

de los valores reales Yi está expresada por la variación de los valores observados Yi en torno a la línea o

curva de regresión y que se expresa por las diferencias entre los valores estimados y los valores

observados (SCE). En el extremo si todos los valores observados caen sobre la línea de regresión, SCTO

es igual a SCR ya que SCE es igual a cero y la variación de los valores observados Yi puede explicarse

completamente usando la variable independiente X. Lo que denominamos SCR puede ser considerado

como una medida de la variación de los Yi que está asociada con la línea de regresión.

Esta partición de las sumas de cuadrados es presentada bajo la forma de una tabla de ANDEVA:

ANDEVA para el modelo RLS

Fuente de Suma de Grados de Cuadrado medio

variación Cuadrados Libertad

Regresión

Yˆ Y

1 CMR = SCR / 1

n 2

SCR = i 1 i

SCE = Y Yˆ

Error n 2 n-2 CME = SCE / (n-2)

i 1 i i

SCTO = Y Y

Total n 2 n-1

i 1 i

Magíster en Recursos Naturales – Econometría

PONTIFICIA UNIVERSIDAD CATOLICA DE CHILE

FACULTAD DE AGRONOMIA E INGENIERIA FORESTAL

DEPARTAMENTO DE CIENCIAS FORESTALES

Donde cuadrado medio corresponde a la definición estándar de una suma de cuadrados dividido por

los grados de libertad asociados.

Utilizando las esperanzas de los cuadrados medios CMR y CME — que se derivan a partir de sus

distribuciones muestrales — es posible hacer inferencias usando el ANDEVA.

E CME 2

E CMR 2 12 i 1 X i X

n

2

Este resultado sugiere que la comparación de CMR y CME resultaría útil para probar si 1=0. Si CMR y

CME son del mismo orden de magnitud, esto indicaría que 1=0 y por el contrario si CMR es

X

2

sustancialmente mayor que CME se sugiere que 1≠0 ya que el término 12

n

i 1 i X tendería a

ser positivo. Esta es la idea básica detrás del ANDEVA.

3.8 Prueba F de 1=0 vs 1≠0

Para el modelo RLS el ANDEVA provee una prueba de hipótesis para:

H 0 : 1 0

H a : 1 0

El estadístico de prueba se denomina F* = (CMR/CME) y se deriva utilizando la distribución muestral

de esta razón bajo H0. Bajo H0, la razón F* es una razón entre dos chi-cuadrado independientes:

2 1 2 n 2

F* ~

1 n2

Es decir, F* tiene una distribución F(1,n-2). Intuitivamente valores altos de F* indicaría que H a es correcta

y valores cercanos a 1, que H0 es correcta. La regla de decisión para el nivel de confianza (1-) es la que

sigue:

Si F* F(1- 1, n-2), aceptar H0.

Si F* > F(1- 1, n-2), no se puede aceptar H0.

Una derivación más formal y detallada — y muy clara — del ANDEVA para el análisis de regresión se

puede encontrar en Neter et al., Applied Linear Statistical Models, sección 2.7, páginas 69-78, 4ª edición.

1996.

Magíster en Recursos Naturales – Econometría

PONTIFICIA UNIVERSIDAD CATOLICA DE CHILE

FACULTAD DE AGRONOMIA E INGENIERIA FORESTAL

DEPARTAMENTO DE CIENCIAS FORESTALES

Los siguientes cuadros presentan el resultado entregado por Excel® al invocar el módulo de análisis de

regresión (HerramientasAnálisis de datosRegresión). En esta ventana se definen los rangos de datos

X e Y, y algunas otras opciones que tienen relación con el tipo y ubicación (otra planilla, otro archivo) de

los resultados que se quieren.

El primer elemento del output es una serie de estadísticos del ajuste del modelo. Este resumen incluye el

R-cuadrado (coeficiente de determinación), el R-múltiple — que corresponde a la raíz cuadrada del R-

cuadrado, y que se conoce también como coeficiente de correlación — el R-cuadrado ajustado que

corresponde a una expresión de R-cuadrado ajustada por los grados de libertad de las correspondientes

sumas de cuadrados y el error estándar o típico de la regresión que es simplemente la raíz del CME.

Listado resumen de regresión (Excel®)

Regression Statistics

Multiple R 0.92127

R Square 0.84874

Adjusted R Square 0.84153

Standard Error 4.18138

Observations 23

ANDEVA entregado por Excel®

ANOVA

df SS MS F Significance F

Regression 1 2060.13 2060.13 117.83 4.52073E-10

Residual 21 367.16 17.48

Total 22 2427.29

Coeficientes y sus estadísticos entregados por Excel®

Coefficients Standard Error t Stat P-value Lower 95% Upper 95%

Intercept 2.6884 2.1477 1.2518 0.2244 -1.7779 7.1547

Edad,X 0.3008 0.0277 10.8549 0.0000 0.2432 0.3584

Donde

2

Y Yˆ

n

i 1 i i

2

SCR

1

SCE

Y Y

R n 2

SCTO SCTO

i 1 i

0 R2 1

SCE /( n 2)

R 2 ajustado 1

SCTO /( n 1)

Se puede interpretar R2 como la reducción proporcional de la variación total asociada con el uso de la

Magíster en Recursos Naturales – Econometría

PONTIFICIA UNIVERSIDAD CATOLICA DE CHILE

FACULTAD DE AGRONOMIA E INGENIERIA FORESTAL

DEPARTAMENTO DE CIENCIAS FORESTALES

variable independiente X. Mientras el valor de R2 este más cerca de 1 mayor es el grado de asociación

lineal entre X e Y. En el extremo, si todas las observaciones caen sobre la línea de regresión, se tiene que

SCTO = SCR y por lo tanto R2=1. Si bien el R2 es una medida muy intuitiva de la calidad de un modelo

de regresión también es necesario aclarar sus limitaciones. Existen dos errores muy frecuentes. En primer

lugar un valor alto de R2 no implica un buen ajuste. En aquellos casos donde la relación entre X e Y es

curvilínea, es posible tener un valor alto para R2 ajustando una línea recta, cuando conceptualmente es

correcto ajustar una relación curvilínea. La figura 8 ilustra este caso, la relación XY es claramente

curvilínea y sin embargo la recta de regresión tiene un R 2 de 0.72. El otro error es pensar que cuando se

tiene un R 2 cercano a cero no existe relación entre X e Y. De hecho la relación entre X e Y puede ser casi

perfecta y aún así tener valores de R2= 0. La figura 9 ilustra esta afirmación, la relación entre X e Y es

muy cercana a Y = X2, pero el R2 de la regresión es 0.014. Estos errores son inducidos porque el R 2 mide

el grado de asociación lineal entre X e Y, y no resulta adecuado para relaciones no lineales.

Los listados siguientes a las estadísticas de ajuste presentan el ANDEVA y una tabla con los coeficientes

(estimadores) b0 y b1, sus errores estándar, el valor t-Student calculado para la hipótesis nula de que el

parámetro correspondiente es igual a cero (bi/SE[bi]) y el valor de probabilidad asociado con este valor t

calculado bajo H0:i=0. Asimismo se entrega un intervalo de confianza del 95% para el valor de los

coeficientes. Al observar la tabla de ANDEVA en este ejemplo se observa que se entrega el valor de

probabilidad asociado con el estadístico F* calculado (Significance F). Los valores de probabilidad

calculados tanto en la tabla de ANDEVA como en la de los coeficientes, entregan la probabilidad del

valor observado bajo H 0, es decir la pregunta que se responde es cuál es la probabilidad de un valor tal

como el que se calculó bajo el supuesto que la hipótesis nula es la correcta, es decir bajo el supuesto que

— por ejemplo — 1=0. La hipótesis nula es por lo general una hipótesis de no-relación entre X e Y, y la

probabilidad reportada entrega una medida de esta relación para el modelo RLS.

En este caso el resultado es que se puede afirmar con confianza que existe una relación entre X e Y (es

decir 1≠0) ya que de acuerdo al ANDEVA, la probabilidad de encontrar sólo por azar (H 0 verdadera), un

valor observado de F* = 117.83 es de 0.00000000045 (aproximadamente 1 en 2200 millones), es decir

muy pero muy baja. Este resultado coincide con lo que se puede observar en la tabla de los coeficientes,

ya que el estadístico t calculado para 1 es 10.8549, lo que entrega una probabilidad igual a la anterior (de

1 en 2200 millones).

Magíster en Recursos Naturales – Econometría

PONTIFICIA UNIVERSIDAD CATOLICA DE CHILE

FACULTAD DE AGRONOMIA E INGENIERIA FORESTAL

DEPARTAMENTO DE CIENCIAS FORESTALES

14

12

10

8

Y

0

0 2 4 6 8 10

X

Y Pronóstico para Y

Figura 8. Relación curvilínea XY, y línea de regresión ajustada con alto R2

18

16

14

12

10

Y

8

6

4

2

0

0 2 4 6 8 10 12

X

Y Pronóstico para Y

Figura 9. Ilustración de una relación cercana entre X e Y, y un R2 cercano a cero

Magíster en Recursos Naturales – Econometría

PONTIFICIA UNIVERSIDAD CATOLICA DE CHILE

FACULTAD DE AGRONOMIA E INGENIERIA FORESTAL

DEPARTAMENTO DE CIENCIAS FORESTALES

4. Modelo de regresión lineal múltiple (RLM)

4.1 El modelo de regresión lineal múltiple (RLM)

El modelo de regresión lineal múltiple considera más de una variable independiente X para explicar el

comportamiento o la variabilidad en una variable dependiente o respuesta Y. Hay numerosos

ejemplos en los que el uso de más de una variable resulta lógico dado el carácter de la variable

dependiente y de las relaciones que se establecen con otras variables. El uso de una sola variable

independiente muchas veces determina una descripción inadecuada del comportamiento de Y, ya que

frecuentemente existen varios factores que influencian las respuestas y la variabilidad de Y,

especialmente en ambientes naturales.

Así por ejemplo, las dimensiones de un determinado árbol dentro de un bosque — su altura por ejemplo

— no dependen sólo de su edad sino que de una serie de otras variables como especie, estado sanitario,

características de su copa o las dimensiones de árboles vecinos. La biomasa de un arbusto de Quillay

puede ser predicha usando por ejemplo el diámetro de su copa, pero factores como el número de varas, el

diámetro de esas varas y su largo son factores que establecen diferencias entre la biomasa de individuos

con aproximadamente los mismos radios de copa e incorporar estas variables en un modelo de regresión

permite explicar en mejor forma las variaciones en biomasa. La figura 10 muestra las variaciones en

volumen total (vtt) para árboles de distinto diámetro a 1.3 mts desde el suelo (dcc). Si bien el uso de dcc

como variable independiente para explicar el comportamiento del volumen total resulta adecuado ya que

se observa una tendencia muy clara en el gráfico, persiste el hecho que árboles con el mismo dcc tienen

volúmenes muy distintos. Esta variación en volumen NO está explicada entonces por las diferencias en

dcc sino que por otros factores, que pueden o no incluirse en el modelo de regresión.

Figura 10. Gráfico volumen-diámetro para 240 árboles.

Magíster en Recursos Naturales – Econometría

PONTIFICIA UNIVERSIDAD CATOLICA DE CHILE

FACULTAD DE AGRONOMIA E INGENIERIA FORESTAL

DEPARTAMENTO DE CIENCIAS FORESTALES

En estos casos, tratar de explicar la variación en la variable respuesta mediante una sola variable

predictora implica un bajo grado de precisión (mayores errores de estimación). Para describir

adecuadamente el comportamiento de la variable dependiente se debe utilizar una relación funcional

(modelo) que considere múltiples variables independientes, cada una de las cuales contribuye a explicar

parte de la variación observada en la variable estimada: modelos más complejos (completos) generan

estimaciones más precisas.

En el modelo de RLM existen (p-1) variables independientes X1, X2, ...., Xp-1, y que junto con la variable

dependiente Y, se observan en i individuos o unidades. Entonces, la formulación del modelo de RLM es:

Yi 0 1 X i ,1 2 X i ,2 ..... p 1 X i , p 1 i

donde

Xi,j : Valor de la j-ésima variable independiente en la i-ésima unidad de observación,

Yi : Valor de la variable dependiente en la i-ésima unidad de observación,

i : error aleatorio independiente y distribuido N(0,2), lo que implica que Cov(i, j) = 0, para i≠j

i: : coeficientes de regresión parcial.

i=1,...., n; j=1,....., p-1

Este es el modelo RLM con errores normales y que representa a una familia de modelos que incluyen:

1. Modelos con p-1 variables independientes.

2. Modelos polinomiales: donde las Xi son potencias de una o más variables independientes.

3. Modelos con predictores cualitativos: donde algunas de las variables son cualitativas como sexo

(M o F), estado sanitario (atacado, no atacado) o fertilización (si, no). Estas clases se representan

mediante variables binarias 0/1 (dummy variables). De esta manera se pueden formular modelos

con pendientes (i) y/o interceptos (0) distintos para distintas clases de observaciones. Las clases

están determinadas por las variables cualitativas. Por ejemplo, supongamos que se desea usar un

modelo de regresión para estimar el volumen por hectárea en una región donde se pueden

distinguir tres tipos forestales (A, B y C). Sea Yi alguna expresión de volumen por hectárea y sea

X1 el número de árboles por hectárea en el bosque. Un modelo posible es:

Yi 0 1 X 1 2 X 2 3 X 3 i

Donde

X2=1 si el bosque es del tipo forestal A, y X2= 0 de lo contrario

X3=1 si el bosque es del tipo forestal B, y X3= 0 de lo contrario

Nótese que se necesitan dos variables para tres clases (en general c-1 variables para c clases).

Entonces la predicción del volumen para un bosque del tipo forestal A con Xi,1 árb./ha es:

Magíster en Recursos Naturales – Econometría

PONTIFICIA UNIVERSIDAD CATOLICA DE CHILE

FACULTAD DE AGRONOMIA E INGENIERIA FORESTAL

DEPARTAMENTO DE CIENCIAS FORESTALES

Yi ( ˆ0 ˆ2 ) ˆ1 X i ,1

4. Modelos con variables transformadas: donde las variables independientes o la variable

dependiente son transformadas por razones teóricas o para corregir algún defecto en el modelo

(algo de esto veremos en la sección de violaciones a los supuestos) y la regresión se hace usando

la(s) variable(s) transformadas. Por ejemplo, es muy común estimar la biomasa de una planta

usando relaciones alométricas del tipo: biomasa = D, donde D es alguna medida del tamaño

de la planta (altura, cobertura, número de tallos, etc.) y , son parámetros del modelo. Este

modelo es habitualmente ajustado en su forma logarítmica, es decir el modelo que se ajusta es

Log(biomasa) = ' + D, con '= log(). En este caso las estimaciones que interesan son las de

biomasa, pese a que el modelo es ajustado con su logaritmo como variable dependiente.

5. Modelos con interacciones: en algunos casos se asume que los efectos de alguna variable

independiente sobre la variable Y no son aditivos y que los efectos dependen en parte de los

niveles de otras variables. Estos modelos tienen términos de interacción. Por ejemplo, asumamos

que se quiere estimar el rendimiento de un determinado cultivo y se piensa que existen tres

factores determinantes, X 1 = control de maleza, X 2 = densidad inicial del cultivo, y X 3 =

disponibilidad de agua (no nos preocupemos ahora de las unidades). El modelo más obvio es:

Yi 0 1 X i ,1 2 X i , 2 3 X i ,3 i

Sin embargo, después de examinar estudios de rendimientos parecidos al nuestro, encontramos

que la literatura reporta una posible interacción entre el nivel de control de malezas y la

disponibilidad de agua. Se puede incluir esta interacción usando simplemente un nuevo término

X1X3, que podemos llamar X4. Es decir Xi,,4 = Xi,1Xi,3. El modelo es entonces:

Yi 0 1 X i ,1 2 X i , 2 3 X i ,3 4 X i , 4 i

Así, las variables Xi no necesitan representar diferentes variables y no necesitan ser continuas, pueden ser

transformaciones de las variables originales, interacciones, potencias o valores 0/1.

Los casos especiales presentados anteriormente permiten concluir que el concepto de regresión lineal se

aplica a modelos que son lineales en los parámetros pero no necesariamente en las variables. Esto

implica que un modelo RLM determinado puede tener una superficie de respuesta que sea distinto de un

hiperplano o un plano sí hablamos de 2 variables independientes. Los siguientes gráficos ilustran distintos

tipos de superficies de respuestas que pueden ser modeladas mediante regresión lineal múltiple.

Magíster en Recursos Naturales – Econometría

PONTIFICIA UNIVERSIDAD CATOLICA DE CHILE

FACULTAD DE AGRONOMIA E INGENIERIA FORESTAL

DEPARTAMENTO DE CIENCIAS FORESTALES

0.0012

0.001

0.0008

0.0006

0.0004

0.0002

Figura 11. Superficie de respuesta curvilínea.

0.9

0.8

0.7

0.6

0.5

0.4

0.3

0.2

0.1

Figura 12. Superficie de respuesta curvilínea.

En el modelo RLM el significado de los coeficientes de regresión parcial i sigue siendo esencialmente

el mismo. El valor de 0 representa el valor donde la superficie de respuesta (plano, hiperplano u otro)

intercepta el eje de Yi cuando todas las variables independientes toman el valor cero, es decir el valor de

E(Yi) cuando todas las Xi son cero. El valor de cada coeficiente i representa la tasa de cambio de la

variable dependiente por unidad de cambio de Xi, cuando todas las otras variables independientes (i≠j )

permanecen constantes, es decir, Yi cambia en i unidades cuando Xi cambia en una unidad y todo el

resto de las Xi permanece constante.

Por ejemplo, la regresión de la altura de los 23 árboles de la figura 6, pero usando en este caso la Edad y

el dap como variables independientes arroja el siguiente modelo ajustado:

Altura 2.17 0.31 dap 0.18 Edad

Altura en metros, dap en centímetros y edad en años.

Magíster en Recursos Naturales – Econometría

PONTIFICIA UNIVERSIDAD CATOLICA DE CHILE

FACULTAD DE AGRONOMIA E INGENIERIA FORESTAL

DEPARTAMENTO DE CIENCIAS FORESTALES

Esto implica que — de acuerdo al modelo postulado y ajustado — un árbol con dap=0 y edad=0 tiene una

altura de 2.17 (metros en este caso), y que por cada centímetro de aumento en dap — para una edad fija—

la esperanza de la altura aumenta en 0.31 metros. El modelo ajustado se puede observar en la figura 13.

80

70

60

50

altura

40

30

20

10

Figura 13. Modelo de predicción de altura (plano).

4.2 Uso de matrices y estimación de los coeficientes de regresión por Cuadrados Mínimos

Ver documento RLM

Ver sobre matrices

4.3 Valores estimados, residuos y ANDEVA

El vector de valores estimados se estima con:

Yˆ1

ˆ

Y2

ˆ

Y Yˆ3 Xb

....

Yˆ

n

El vector de residuos estimados ( ei Yi Yˆi ) se estima con:

e1

e

2

e e3 Y Xb .

....

en

Magíster en Recursos Naturales – Econometría

PONTIFICIA UNIVERSIDAD CATOLICA DE CHILE

FACULTAD DE AGRONOMIA E INGENIERIA FORESTAL

DEPARTAMENTO DE CIENCIAS FORESTALES

Si se define la matriz H (matriz gorro o hat) como H X X T X

nxn

1

X , se puede definir Yˆ HY , y

e I H Y , donde I es la matriz identidad de orden n. Además la matriz de varianza-covarianza es:

2 e 2 I H , que es estimada por s 2 e CME I H

nxn nxn

Las sumas de cuadrados del ANDEVA también se pueden expresar mediante notación matricial:

1

SCTO Y T Y Y T JY

n

1

SCR bT X T Y Y T JY

n

SCE Y Y b X T Y

T T

1 1 ... 1

1 1 ... 1

Donde J es una matriz con todos sus elementos igual a 1, J ij=1 para todo i,j.

nxn ... ... ... ...

1 1 ... 1

La tabla del ANDEVA es:

ANDEVA para el modelo RLM

Fuente de Suma de Grados de Cuadrado medio

variación Cuadrados Libertad

Regresión 1

SCR = bT X T Y Y T JY p-1 CMR = SCR /(p-1)

n

Error SCE = Y Y b X T Y

T T n-p CME = SCE / (n-p)

Total 1 T n-1

SCTO = Y Y Y JY

T

n

El ajuste de los coeficientes del vector b se puede hacer en Excel® usando el módulo de análisis de datos

o simplemente utilizando las funciones de inversión y multiplicación de matrices de la planilla. La ventaja

de utilizar el módulo de análisis de datos (HerramientasAnálisis de DatosRegresión) es que provee

una serie de resultados muy útiles para inferencia y comprobación de los supuestos del modelo RLM

normal. La siguiente figura muestra los datos de volumen total por hectárea para 1564 rodales de pino

radiata.

Magíster en Recursos Naturales – Econometría

PONTIFICIA UNIVERSIDAD CATOLICA DE CHILE

FACULTAD DE AGRONOMIA E INGENIERIA FORESTAL

DEPARTAMENTO DE CIENCIAS FORESTALES

1000

900

800

700

Volumen total, m3/há

600

500

400

300

200

100

0

0 5 10 15 20 25 30

Edad

Figura 14. Volumen por hectárea para 1564 rodales de pino radiata

Un simple modelo de predicción del volumen total por hectárea es:

Vha 0 1 Nha 2 Edad 3Gha 4 H

El modelo ajustado por Excel® es reportado en las siguientes tablas (p=5, n=1564):

Regression Statistics

Multiple R 0.9848

R Square 0.9699

Adjusted R Square 0.9698

Standard Error 30.84

Observations 1564

ANOVA

df SS MS F Significance F

Regression 4 47718264.68 11929566.17 12546.5241 0

Residual 1559 1482338.339 950.8264

Total 1563 49200603.02

Coefficients Standard Error t Stat P-value Lower 95% Upper 95%

Intercept -162.1234 5.1208 -31.6599 0.0000000 -172.1677 -152.0790

NHA -0.0110 0.0030 -3.6593 0.0002613 -0.0169 -0.0051

EDAD 8.6138 0.5471 15.7452 0.0000000 7.5408 9.6869

GHA 8.1056 0.0993 81.6074 0.0000000 7.9107 8.3004

HPA 1.6312 0.4158 3.9235 0.0000911 0.8157 2.4468

Vha : Volumen del rodal, m3/ha,

Nha : Número de árboles por hectárea del rodal,

Edad : Edad desde plantación del rodal, años,

Gha : Área basal por hectárea del rodal, m2/ha,

Hpa : Altura promedio aritmética de los árboles del rodal, m.

Magíster en Recursos Naturales – Econometría

PONTIFICIA UNIVERSIDAD CATOLICA DE CHILE

FACULTAD DE AGRONOMIA E INGENIERIA FORESTAL

DEPARTAMENTO DE CIENCIAS FORESTALES

La interpretación de los estadígrafos de la regresión y de las sumas de cuadrados en la tabla de

ANDEVA son los mismos que para el modelo RLS. Hay una diferencia respecto de la hipótesis nula que

se prueba en el ANDEVA pero esto se verá en detalle en la sección siguiente.

Respecto del cálculo con matrices las matrices básicas del modelo son:

XTX

Variable n x1=nha x2=edad x3=gha x4=hpa

n 1564.0 1519480.5 21319.0 53324.3 29606.1

x1=nha 1519480.5 1983340034 19411154 59657606.73 26432704.51

x2=edad 21319.0 19411154 316423 784598.3 442591.5

x3=gha 53324.3 59657606.73 784598.3 2349401.45 1106479.47

x4=hpa 29606.1 26432704.51 442591.5 1106479.47 627718.67

XTY

Variable X'Y

y 393862.9

y*x1 425696994.3

y*x2 6137134.2

y*x3 18304482.77

y*x4 8714089.29

(XTX)-1

0.027578582 -1.3567E-05 -0.000783449 0.000374314 -0.000836845

-1.3567E-05 9.5242E-09 -3.00826E-08 -2.72832E-07 7.40958E-07

-0.000783449 -3.00826E-08 0.000314773 -2.85842E-07 -0.000183218

0.000374314 -2.72832E-07 -2.85842E-07 1.03754E-05 -2.42528E-05

-0.000836845 7.40958E-07 -0.000183218 -2.42528E-05 0.000181795

b = (XTX)-1XTY

-162.1233602

-0.01101201

8.613844448

8.105552839

1.631247888

Todas estas operaciones son posibles usando las funciones incorporadas en Excel® (MMULT,

MINVERSA, SUMAPRODUCTO, SUMA.CUADRADOS y SUMA). En este caso Excel® no puede

desplegar las matrices H y s.e.2(e) ya que ambas tienen dimensión (n x n), (1564x1564) en este caso.

Magíster en Recursos Naturales – Econometría

PONTIFICIA UNIVERSIDAD CATOLICA DE CHILE

FACULTAD DE AGRONOMIA E INGENIERIA FORESTAL

DEPARTAMENTO DE CIENCIAS FORESTALES

Como se puede observar las estimaciones para b son las mismas. En todo caso es recomendable utilizar el

módulo de análisis de datos por la cantidad de información adicional que proporciona.

5. Inferencia en el modelo RLM

5.1 ANDEVA

La hipótesis nula del ANDEVA para el modelo establece que no hay relación de regresión entre la

variable dependiente y el conjunto de variables independientes contenidas en la matriz X. Esto es:

H 0 : 1 2 3 .... p1 0

H a : i 0 , para algún i = (1, 2, …, p-1)

La hipótesis alternativa establece que al menos existe un coeficiente estimado bi que es significativo, no

establece cuál ni cuantos. En este sentido es sólo una indicación preliminar de la calidad del modelo de

regresión. El estadístico de prueba es el mismo que para el modelo RLS, F* = (CMR/CME) y se compara

con el valor tabulado de la distribución F para un determinado nivel de confianza . La regla de decisión

es exactamente la misma que para RLS:

Si F* F(1- p-1, n-p), aceptar H0.

Si F* > F(1- p-1, n-p), no se puede aceptar H0.

En este caso el valor calculado para F* es de 12546.5241 que es mucho mayor que los valores tabulados

de F(1-, 4, 1559) para =0.05 (F=2.3776) y =0.01 (F=3.3311) que son los niveles de confianza más

frecuentes. La conclusión es que existe al menos un i (i = 1, 2, 3, 4) que es significativamente distinto de

cero con un nivel de confianza del 99%.

5.2 Inferencias respecto de los parámetros de regresión

El estimador MCO de b tiene una matriz de varianza-covarianza que contiene las varianzas necesarias

para hacer pruebas de hipótesis y calcular intervalos de confianza sobre los i. El listado entregado por

Excel® entrega estos errores estándar. La matriz de varianza-covarianza se define como:

2 b0 b0 , b1 ... b0 , b p 1

b1 , b0 2 b1 ... b1 , b p 1

2 b

pxp ... ... ... ...

b p 1 , b0 b p 1 , b1 ... 2 b p 1

pxp

Esta matriz es calculada por 2 b 2 X T X 1

y que tiene como estimador a s2(b):

Magíster en Recursos Naturales – Econometría

PONTIFICIA UNIVERSIDAD CATOLICA DE CHILE

FACULTAD DE AGRONOMIA E INGENIERIA FORESTAL

DEPARTAMENTO DE CIENCIAS FORESTALES

s 2 b0 sb0 , b1 ... sb0 , b p 1

sb1 , b0 s 2 b1 ... s b1 , b p 1

s b

2

pxp

... ... ... ...

= CME X T X

1

s b p 1 , b0 s b p 1 , b1 ... s 2 b p 1

Para la regresión del volumen por hectárea presentada anteriormente se tiene que CME = 950.8264 y X TX

se puede observar en la sección anterior. Entonces:

s2(b)

26.222443 -0.012900 -0.744924 0.355907 -0.795694

-0.012900 0.00000906 -0.000029 -0.000259 0.000705

-0.744924 -0.000029 0.299294 -0.000272 -0.174209

0.355907 -0.000259 -0.000272 0.009865 -0.023060

-0.795694 0.000705 -0.174209 -0.023060 0.172856

Desde donde se pueden extraer los errores estándar para los coeficientes b 0 a b4 desde la diagonal:

s.e.(b0) 5.120785

s.e.(b1) 0.003009

s.e(b2) 0.547078

s.e.(b3) 0.099324

s.e.(b4) 0.415759

bi i

En el modelo con errores normales se tiene que ~ t (n p) . Por lo tanto un intervalo de

SE bi

confianza para i con un nivel de confianza (1-) es bi t 1 / 2; n p SE bi

Asimismo una prueba de hipótesis referida a un i específico es

H 0 : i 0 vs. H a : i 0

bi

El estadístico de prueba es: T , y la regla de decisión es:

SE bi

Si |T| t(1-/2; n-p), no se puede rechazar H0,

Si |T| > t(1-/2; n-p), rechazar H0.

Supongamos que deseamos probar la hipótesis nula 2 =0, es decir que la edad no tiene una relación

significativa con el volumen. El estadístico es T=8.6138/0.5471=15.74. Este valor se compara con el

valor tabulado para un 95% de confianza (=0.05, /2=0.025) y 1559 grados de libertad, t(0.975,1559) ≈

1.9615. Como el valor calculado de T es mayor que el valor crítico se concluye que se rechaza H 0, y por

Magíster en Recursos Naturales – Econometría

PONTIFICIA UNIVERSIDAD CATOLICA DE CHILE

FACULTAD DE AGRONOMIA E INGENIERIA FORESTAL

DEPARTAMENTO DE CIENCIAS FORESTALES

lo tanto se puede decir que la edad tiene una relación lineal significativa con el volumen. Esta relación se

denomina relación o asociación lineal estadística.

Este resultado puede ser rápidamente extraído del listado que entrega Excel®. El listado entrega los

coeficientes bi, sus errores estándar s.e.(bi), el estadístico T (t Stat) para la prueba de la hipótesis nula

H0:i=0, y la probabilidad asociada al valor del estadístico T calculado (P-value). Este valor P es en

términos simples la probabilidad de que en un valor del estadístico T con un valor igual al calculado haya

sido generado puramente por azar bajo el supuesto de que la hipótesis nula es verdadera. Entonces,

valores pequeños de probabilidad estarán asociados al rechazo de la hipótesis nula y valores altos al no

rechazo de H0. De hecho, basta comparar el valor P asociado al correspondiente coeficiente con el nivel

de la prueba de hipótesis que se esta haciendo. Si P> entonces no se puede rechazar H0, si P< entonces

se puede rechazar H0. Estos resultados se aplican solamente para H0: i=0 vs. Ha i≠0. Las dos últimas

columnas del listado entregan los límites inferior y superior del intervalo de confianza del 95% para el

correspondiente coeficiente i. El intervalo de confianza al nivel (1- ) para el parámetro 2 es:

8.6138 1.9615 0.5471 7.5407 2 9.6870

Que es igual al reportado por Excel®. Las diferencias se deben solo a aproximaciones. Este resultado

viene a confirmar lo expresado por la prueba de hipótesis de que el coeficiente 2 es distinto de cero ya

que el intervalo de confianza no incluye al cero.

5.3 Intervalos de confianza para E(Y), y para una nueva observación Y.

5.3.1 Respuesta esperada, E(Y)

Para una combinación particular de valores en las variables X1,X2, …. ,Xp-1 que llamaremos

Xh,1,Xh,2,….,Xh,p-1, la respuesta esperada es E Yh Yˆh . Definamos el vector Xh como:

X h ,1

X

h,2

X h X h ,3

px1

...

X h , p 1

El estimador de E(Yh) es entonces X hT b , que tiene varianza 2 Yˆh 2 X hT X T X

Xh . 1

Esta varianza puede ser expresada como una función de la matriz de varianza-covarianza de los

coeficientes de regresión estimados:

Magíster en Recursos Naturales – Econometría

PONTIFICIA UNIVERSIDAD CATOLICA DE CHILE

FACULTAD DE AGRONOMIA E INGENIERIA FORESTAL

DEPARTAMENTO DE CIENCIAS FORESTALES

2 Yˆh X hT 2 bX h

Que es estimado por la expresión:

s 2 Yˆh CME X hT X T X X h X hT s 2 b X h

1

El intervalo de confianza (1-) para E(Yh) es:

Yˆh t 1 / 2; n p s Yˆh

5.3.2 Predicción de una nueva observación en Y, Yh(n)

La predicción de una nueva observación Yh(n) en el nivel Xh de las variables independientes tiene la

misma esperanza que E(Y), es decir igual a X hT b . El intervalo de confianza (1-) para Yh(n) en este caso

es:

Yˆh t 1 / 2; n p sYh( n) , donde

s 2 Yh( n ) CME s 2 Yˆh CME 1 X hT X T X

1

Xh

Por ejemplo supongamos que se desea un intervalo de confianza para el valor esperado del volumen por

hectárea de un rodal que tiene 28 años (Edad=28), 750 árboles por hectárea (Nha=750), un área basal de

55 m2/ha (Gha=55) y una altura promedio de 25 metros (Hpa=25). Entonces:

1

750

X h 28

55

25

De donde E Yh Yˆh X hT b

= b0*1+ b1*Nha+b2*Edad+b3*Gha+b4*Hpa

= -162.1235*1-0.0110*750+8.6138*28+8.1056*55+1.6312*25 = 557.4 m3/ha.

La varianza de E(Yh) es igual a 37.811. Esto implica que el error estándar de E(Yh), s 2 Yˆh = 6.15. El

intervalo de confianza del 95% (=0.05) para E(Yh) es:

Magíster en Recursos Naturales – Econometría

PONTIFICIA UNIVERSIDAD CATOLICA DE CHILE

FACULTAD DE AGRONOMIA E INGENIERIA FORESTAL

DEPARTAMENTO DE CIENCIAS FORESTALES

557.4 1.9615 6.15 545.34 Yˆh 569.46

5.4 Coeficiente de determinación múltiple (R2)

El coeficiente de determinación múltiple — R2— es definido (ver final de sección 2) como:

SCR SCR SCE

R2 1

SCTO SCE SCR SCTO

Este índice mide en este caso la reducción proporcional de la variación total de Y asociada con el uso

del conjunto de variables X 1 a Xp-1, y tal como en el caso del modelo RLS varía entre 0 y 1. Este

coeficiente es igual a 1 cuando todas las observaciones caen exactamente sobre la superficie de respuesta

y toma el valor 0 cuando todos los bk (k=1,…, p-1) son iguales a cero. Remitiéndose al modelo RLS la

siguiente figura ejemplifica los patrones esperados en los valores de R2 cuando se observan los datos y la

línea de regresión ajustada.

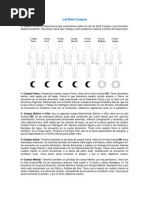

A. B.

C. D.

Figura 15. El R2 como medida de ajuste de una línea recta

En esta figura A. representa un R2 = 1 y B. un R2=0. Los casos C y D corresponden a valores de R2

grandes o cercanos a 1 (caso C.) y valores de más R2 pequeños.

El de R2 siempre se incrementa cuando se agrega una nueva variable independiente a la regresión lo que

no implica que el modelo sea mejor o mejore. Como una manera de ajustar el valor de R2 por el número

de variables X del modelo es que se ha propuesto el llamado R2-ajustado que es calculado como:

Magíster en Recursos Naturales – Econometría

PONTIFICIA UNIVERSIDAD CATOLICA DE CHILE

FACULTAD DE AGRONOMIA E INGENIERIA FORESTAL

DEPARTAMENTO DE CIENCIAS FORESTALES

SCE

n p n 1 SCE

Ra2 1 1

SCTO n p SCTO

n 1

Este coeficiente ajusta el índice por el número de variables en el modelo usando los grados de

libertad de las sumas de cuadrado totales y del error. Tiene la misma interpretación que el R 2original

pero tiene la ventaja que puede disminuir cuando se agrega una variable al modelo. Esto pasa cuando la

disminución en la SCE no es compensada por la perdida del grado de libertad en el denominador (n-p).

5.5 Suma de Cuadrados Extra

La suma de cuadrados extra mide el incremento marginal en la suma de cuadrados debido a la

regresión (proporción de la variación total de la variable dependiente que es explicada por el

modelo) al incluir una variable independiente adicional. En forma equivalente, la suma de cuadrados

extra mide la reducción marginal en la suma de cuadrados residuales cuando una nueva variable

independiente se agrega al modelo de regresión (la ganancia marginal depende de las variables

predictoras que ya están presentes en el modelo). Por ejemplo, una de las funciones de estimación más

comunes en recursos forestal es la que estima el volumen de un árbol como en base a diámetros y altura.

Consideremos, las siguientes variables:

a. Volumen total del árbol (vtt) , m3

b. dap al cuadrado del árbol (d2cc), cm2

c. altura del árbol (alt), m

d. diámetro a los 6 metros de altura al cuadrado (d62), cm2

Y consideremos ahora una secuencia de modelos en los que se agregan las variables b, c y d. El primer

modelo modelos es vtt=b0+b1*d2cc tiene el siguiente ANDEVA (extraído desde ARC):

Source df SS MS F p-value

Regression 1 11.2509 11.2509 2846.71 0.0000

Residual 238 0.940636 0.00395225

Cuando se agrega la altura el modelo es vtt=b0+b1*d2cc+b2*alt, y el ANDEVA es:

Source df SS MS F p-value

Regression 2 11.4897 5.74487 1940.06 0.0000

Residual 237 0.7018 0.00296118

El modelo al que se agrega el diámetro a 6 metros es vtt=b0+b1*d2cc+b2*alt+b3*d26, que tiene el

siguiente ANDEVA:

Source df SS MS F p-value

Regression 3 11.9964 3.9988 4835.98 0.0000

Residual 236 0.195145 0.000826885

Magíster en Recursos Naturales – Econometría

PONTIFICIA UNIVERSIDAD CATOLICA DE CHILE

FACULTAD DE AGRONOMIA E INGENIERIA FORESTAL

DEPARTAMENTO DE CIENCIAS FORESTALES

Si definimos

SCTO: Suma de cuadrados debido a la variación de las observaciones de la variable respuesta Y1,….Yn.

Se tiene que por definición SCTO = SCR + SCE

SCE(X1, …,Xh):

Suma de cuadrados residuales cuando el modelo considera las variables independientes X 1, … Xh

SCR(X1,…,Xh):

Suma de cuadrados de la regresión cuando el modelo considera las variables independientes X1, ... Xh.

SCR(Xh+1 | X1,……,Xh):

Incremento marginal en la suma de cuadrados de la regresión al agregar la variable Xh+1 a un modelo que

incluye las variables predictoras X1, …,Xh.

SCR(Xh+1 |X1,…,Xp) = SCR(X1,…,Xh,Xh+1) – SCR(X1,…,Xh)

Entonces se puede descomponer la suma de cuadrados de la regresión SCR en sumas de cuadrados

extras:

SCTO = SCR(X1,…Xh,Xh+1) + SCE(X1,…,Xh,Xh+1)

SCTO= SCR(X1,…Xh) + SCR(Xh+1| X1,…Xh) + SCE(X1,…Xh,Xh+1), y se tiene además que

SCTO= SCR(X1,…Xh) + SCE(X1,…,Xh)

Por consiguiente:

SCR(Xh+1| X1,…Xh) = SCE(X1,…Xh) – SCE(X1,…Xh,Xh+1),

donde

SCR(Xh+1 | X1,…Xh)

Reducción en la suma de cuadrados residuales al agregar la variable Xh+1 a un modelo que incluye las

variables predictoras X1,…,Xh.

Por ejemplo:

SCR(d62|d2cc, alt) = SCR(d62, d2cc, alt) – SCR(d2cc, alt) = 11.9964-11.4897 = 0.5067

SCR(d62|d2cc, alt) = SCE(d2cc, alt) – SCE(d2cc, alt, d26) = 0.7018-0.195145=0.506655

(la diferencia 0.000045 se debe a aproximaciones de ARC)

Lo interesante de esta derivación teórica es que se pueden construir tablas de análisis de varianza

descomponiendo la suma de cuadrados debido a la regresión en suma de cuadrados extra como se muestra

en la siguiente tabla y el ejemplo correspondiente.

Magíster en Recursos Naturales – Econometría

PONTIFICIA UNIVERSIDAD CATOLICA DE CHILE

FACULTAD DE AGRONOMIA E INGENIERIA FORESTAL

DEPARTAMENTO DE CIENCIAS FORESTALES

Fuente de Suma de grados de Cuadrados

variación Cuadrados libertad medios

Regresión SCR(X1,X2,X3) 3 CMR(X1,X2,X3)

X1 SCR(X1) 1 CMR(X1)

X2 | X1 SCR(X2|X1) 1 CMR (X2|X1)

X3 | X1,X2 SCR(X3|X1, X2) 1 CMR (X3|X1,X2)

Error SCE(X1,X2,X3) n-4 CME(X1,X2,X3)

Total SCTO n-1

Fuente de Suma de grados de Cuadrados

variación Cuadrados libertad medios

Regresión 11.9964 3 3.9988

d2cc 11.2509 1 11.2590

alt | d2cc 0.2388 1 0.2388

d62 | d2cc, alt 0.5067 1 0.5067

Error 0.195145 236 0.000827

Total SCTO 239

La suma de cuadrados extra es de interés porque se utiliza para pruebas de hipótesis relacionadas con

los coeficientes de regresión. En particular, para determinar si es conveniente eliminar determinadas

variables del modelo.

5.5.1 Uso de la suma de cuadrados extra en la prueba de hipótesis i=0

Se puede utilizar la partición de sumas de cuadrados para comprobar si vale la pena eliminar una

variable de un modelo de RLM. Consideremos el modelo vtt=b0+b1*d2cc+b2*alt+b3*d26 que se usó

en la sección anterior. Designemos como SCE(F) a la suma de cuadrados del error para el modelo

completo (del inglés Full). En este caso SCE(F)=0.195145 que tiene (n-4) = 236 grados de libertad. Si se

desea probar que el diámetro a 6 metros de altura al cuadrado (d26) es una variable que debe salir del

modelo, la prueba apropiada es:

H 0 : 3 0

H a : 3 0

Para la prueba de hipótesis se define el modelo reducido vtt=b0+b1*d2cc+b2*alt que tiene una suma de

cuadrados del error SCE(R)=0.7018, que tiene (n-3)=237 grados de libertad. Este modelo reducido es el

modelo “adecuado” si H0 es verdadera.

El estadístico de prueba se llama F* y es igual a:

Magíster en Recursos Naturales – Econometría

PONTIFICIA UNIVERSIDAD CATOLICA DE CHILE

FACULTAD DE AGRONOMIA E INGENIERIA FORESTAL

DEPARTAMENTO DE CIENCIAS FORESTALES

SCE R SCE F

F* gl R gl F

SCE F

gl F

Que para el ejemplo es:

SCE d 2cc, alt SCE d 2cc, alt , d 26

F* n 3 n 4

SCE d 2cc, alt , d 26

n4

Sin embargo la resta de cuadrados de error en el numerador de F* es de hecho una suma de

cuadrados extra:

SCEd 2cc, alt SCE d 2cc, alt , d 26 SCRd 26 | d 2cc, alt

Entonces,

SCRd 26 | d 2cc, altR

CMRd 26 | d 2cc, altR

F* 1

SCE d 2cc, alt , d 26 CME d 2cc, alt , d 26

n4

Lo que se observa es que la prueba de hipótesis b3=0 es una prueba condicionada (marginal) al hecho

que d2cc y alt ya están incluidas en el modelo. Esta prueba tal como está planteada aquí se denomina test

F parcial.

Para el ejemplo, el valor de F* = (0.5067/1)/0.000826885=612.78 que se compara con el valor crítico

F(1-, 1, n-4) que en este caso y para =0.01 es F(0.99,1, 236) =6.74. Como el valor de F* >> F se

concluye que se rechaza H0 (el valor p asociado a F* es cercano a 2 x 10 elevado a menos 67).

Entonces si se quiere probar la hipótesis:

H0 : k 0

Ha : k 0

El estadístico de prueba es:

SCRX k | X 1 , X 2 ,...., X k 1 , X k 1 ,......., X p 1

SCE X 1 , X 2 ,.........., X p 1

F* 1

n p

Magíster en Recursos Naturales – Econometría

PONTIFICIA UNIVERSIDAD CATOLICA DE CHILE

FACULTAD DE AGRONOMIA E INGENIERIA FORESTAL

DEPARTAMENTO DE CIENCIAS FORESTALES

CMRX k | X 1 , X 2 ,...., X k 1 , X k 1 ,......., X p1

~ F 1 ,1, n p

CME F

6. Violaciones a los supuestos del modelo RLM: diagnósticos y alternativas

Cuando se ajusta un modelo de RLM (Ver: Problemas en el ajuste de un modelo RLM) es importante

verificar de alguna manera que los supuestos establecidos para su derivación sean cumplidos y

eventualmente en que grado son violados en aquellos casos donde no se cumplan. Este ejercicio es

importante por varias razones. En primer lugar es necesario determinar si el modelo es apropiado para los

datos a los que se está ajustando de manera de considerar eventualmente otro tipo de modelos (no

lineales, logístico). Es necesario saber además que supuesto no se cumple y en que grado para tomar

medidas de corrección. Asimismo es necesario verificar que el modelo es estadísticamente correcto antes

de hacer inferencias o recomendaciones basadas en sus predicciones. En este caso estadísticamente

correcto implica que los supuestos relativos a los errores (y por ende a los valores estimados Y gorro) se

cumplen. Por último todo modelo es perfectible y un buen análisis de supuestos puede derivar en un

mejor modelo.

El modelo RLM con errores normales tiene los siguientes supuestos:

1. Las variables independientes Xi,j son constantes conocidas.

2. Se asume que entre las variables Xi,j no existe una relación lineal exacta o que en otras

palabras no son colineales. Este supuesto se agrega en el modelo RLM ya que existe más

de una variable independiente. Formalmente la no colinealidad o no multicolinealidad

implica que no existe un conjunto de números 1, 2p-1 tales que X i, j 0 .

j j

Si tal relación se cumple sólo cuando todo j=0, entonces se dice que los Xi,j son

linealmente independientes y no existe multicolinealidad.

3. Los errores aleatorios i se distribuyen N(0, 2) (varianza única y distribución normal)

4. Cov(i,j)=0 para todo i≠j (es decir son independientes)

La mayor parte de las pruebas de diagnóstico establecidas para verificar estos supuestos son gráficos de

los errores (o residuos) o de sus transformaciones. Asimismo, el análisis de los datos básicos (los X´s y

los Y´s), tal como se describe en la clase de Análisis Exploratorio de Datos de este curso, forma parte