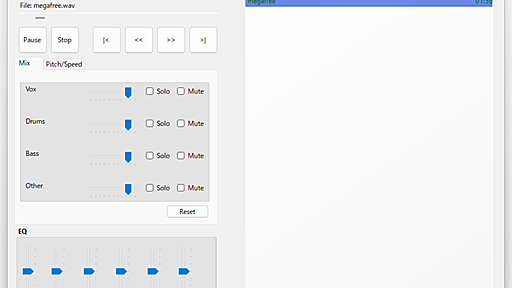

例えば、こちらのブログですが、グラフィカルな解説部分が、画像になっています。 Claudeはマルチモーダルに対応しているので、画像を添付した状態で「文字を抽出して」というと文字を抽出してくれますが、日本語で要約して回答したり、元の文章を正確に抽出する のは、意外と難しいと感じていました。 以下は、Claude.aiを使って「添付画像から文字を抽出して」と依頼した際の結果です。 原文そのままを正確に抽出したいときってありますよね?それを解決する方法を編み出しました。 方法は、「 HTMLで再現させる 」です! 本投稿の先頭の画像を添付して「添付画像をHTMLで再現して」と依頼した際の結果がこちらです。 感動!!! (注:右側が画像をもとに生成したHTMLを、プレビューした状態です。Claude.aiのArtifactsという機能です) アイコンがちょっと違うとか省略されてるとかはありますが、