MIDI

MIDI (siglas de Musical Instrument Digital Interface o en español “Interfaz Digital de Instrumentos Musicales”) es un estándar tecnológico que describe un protocolo, una interfaz digital y conectores que permiten que varios instrumentos musicales electrónicos, ordenadores y otros dispositivos relacionados se conecten y comuniquen entre sí.[1] Una simple conexión MIDI puede transmitir hasta dieciséis canales de información que pueden ser conectados a diferentes dispositivos cada uno.

El sistema MIDI transporta mensajes de eventos que especifican notación musical, tono y velocidad (intensidad); señales de control para parámetros musicales como lo son la dinámica, el vibrato, panoramización en dos dimensiones, cues y señales de reloj que establecen y sincronizan el tempo entre varios dispositivos. Estos mensajes son enviados mediante un cable MIDI a otros dispositivos que controlan la generación de sonidos u otras características. Estos datos también pueden ser grabados en un hardware o software llamado secuenciador, el cual permite editar la información y reproducirla posteriormente.[2]: 4

La tecnología MIDI fue estandarizada en 1983 por un grupo de representantes de la industria de fabricantes de instrumentos musicales llamado MIDI Manufacturers Association (MMA). Todos los estándar MIDI son desarrollados y publicados en conjunto por la MMA en Los Ángeles, California (Estados Unidos) y para Japón, el comité MIDI de la Association of Musical Electronics Industry (AMEI), en Tokio.

Las ventajas del uso de MIDI incluyen el pequeño tamaño de los ficheros (una canción completa puede ser codificada en unos cientos de líneas, por ejemplo en algunos kilobytes) y la fácil manipulación, modificación y selección de los instrumentos.[3]

Historia

[editar]Desarrollo del MIDI

[editar]Hacia finales de los años setenta, los dispositivos electrónicos musicales se volvieron más comunes y menos costosos en América del Norte, Europa y Japón. Los primeros sintetizadores analógicos eran usualmente monofónicos y controlados mediante el voltaje producido por sus teclados. Los fabricantes usaron este voltaje para conectar instrumentos en conjunto y así un solo dispositivo podría controlar uno u otros más, sin embargo este sistema no era adecuado para los sintetizadores polifónicos y digitales.[2] Algunos fabricantes crearon sistemas que permitían que sus propios equipos fueran interconectados, pero los sistemas no eran compatibles externamente (como sucedía con otras tecnologías), es decir que los sistemas de unos fabricantes podrían no ser sincronizados con los de otros.[2]: 4

En junio de 1981, el fundador de Roland, Ikutaro Kakehashi, propuso la idea de una estandarización al fundador de Oberheim Electronics, Tom Oberheim, que en ese entonces habló con el presidente de Sequential Circuits, Dave Smith. En octubre de 1981, Kakehashi, Oberheim y Smith discutieron la idea con los representantes de Yamaha, Korg y Kawai.[4]

Los ingenieros y diseñadores de sintetizadores de Sequential Circuits, Dave Smith y Chet Wood, concibieron la idea de una interfaz para sintetizadores universal, que permitiera una comunicación directa entre equipos sin importar que fueran de distintos fabricantes. Smith propuso este estándar en noviembre de 1981 a Audio Engineering Society.[2] Por los siguientes dos años, el estándar fue discutido y modificado por representantes de compañías como Roland, Yamaha, Korg, Kawai, Oberheim y Sequential Circuits,[5] renombrado como Musical Instrument Digital Interface.[2] El desarrollo del MIDI fue presentado al público por Robert Moog en octubre de 1982 en la revista Keyboard.[6]: 276

En la exhibición NAMM de enero de 1983, Smith logró presentar la conexión MIDI entre el sintetizador analógico Prophet 600 (de Sequential circuits inc) y el Jupiter-6 (de Roland). El protocolo MIDI 1.0 fue publicado en agosto de 1983.[4] El estándar MIDI fue publicado por Ikutaro Kakehashi y Dave Smith, quienes en 2013 recibieron el Grammy técnico por su papel en el desarrollo del MIDI.[7][8]

Impacto del MIDI en la industria de la música

[editar]El uso del MIDI estaba originalmente limitado a aquellos que quisieran hacer uso de instrumentos electrónicos en la producción musical de la música pop. El estándar permitía que diferentes instrumentos pudieran comunicarse con otros y con las computadoras. Esto causó una rápida expansión en las ventas y en la producción de instrumentos electrónicos y software musical.[5] Esta intercompatibilidad permitió que un dispositivo pudiera ser controlado desde otro, lo que ayudó a los músicos que tuvieran la necesidad de utilizar distintos tipos de hardware.[9] La introducción del MIDI coincidió con la llegada de las computadoras personales, samplers (los cuales permiten reproducir sonidos pregrabados en presentaciones en vivo para incluir efectos que previamente no eran posibles fuera de los estudios) y los sintetizadores digitales, los cuales permitían almacenar sonidos pre programados y posteriormente ser utilizados simplemente pulsando un botón.[10] Las posibilidades creativas que permitió la tecnología MIDI ayudaron a revivir la industria de la música durante los ochenta.[11]

El MIDI introdujo muchas capacidades que transformaron la manera en que los músicos trabajaban. La secuenciación MIDI hizo posible que un usuario sin habilidad para la escritura musical pudiera desarrollar arreglos complejos.[12] Un acto musical con uno o dos miembros, ambos operando unos pocos dispositivos MIDI, podían representar un sonido similar a grupos con un número mucho mayor de músicos.[13] El costo de contratar músicos para un proyecto podría ser reducido o eliminado,[2] y producciones complejas pueden ser realizadas en un sistema pequeño como una estación de trabajo MIDI, un sintetizador con un teclado integrado y un secuenciador. Músicos profesionales podían realizar esto en un espacio llamado home recording, sin la necesidad de alquilar un estudio de grabación profesional con personal. Trabajando la preproducción en tal entorno, un artista puede reducir los costos de grabación, llegando al estudio con un trabajo que está parcialmente completo. Las partes rítmica y de fondo pueden ser secuenciadas y posteriormente reproducidas en el escenario.[2] Las actuaciones requieren menor transporte de material y tiempo de preparación del equipo debido a las diferentes y reducidas conexiones necesarias para reproducir varios sonidos.[cita requerida] La tecnología educativa compatible con MIDI ha transformado también la educación musical.[14]

En 2012, Ikutaro Kakehashi y Dave Smith recibieron el Grammy técnico por el desarrollo del MIDI en 1983.[15]

Aplicaciones

[editar]Control de instrumentos

[editar]El MIDI fue inventado para que los instrumentos musicales se pudieran comunicar unos con otros y que un instrumento pudiera controlar a otro. Los sintetizadores analógicos que no tenían un componente digital y que fueron construidos antes del desarrollo del MIDI pueden ser ajustados con kits que convierten los mensajes MIDI a voltajes de control analógicos.[6]: 277 Cuando una nota es tocada en un instrumento MIDI, esta genera una señal digital que puede ser usada para activar la misma nota en otro instrumento.[2]: 20 La capacidad de un control remoto permite que instrumentos de gran tamaño sean remplazados con pequeños módulos de sonido. Esto permite a los músicos combinar instrumentos para alcanzar un sonido pleno o para crear combinaciones como un piano acústico y cuerdas.[16] MIDI también permite que otros parámetros de los instrumentos sean controlados de manera remota. Los sintetizadores y los samplers tienen varias herramientas para el modelado de un sonido. La frecuencia de un filtro y el ataque de una envolvente, o el tiempo que tarda un sonido en llegar a su valor máximo son ejemplos de los parámetros de los sintetizadores, y pueden ser controlados de manera remota a través de MIDI. Dispositivos de efectos tienen diferentes parámetros, como el tiempo de reverberación o delay. Cuando el número de un controlador MIDI es asignado a estos parámetros, el dispositivo responderá a los mensajes que reciba de dicho controlador. Se pueden utilizar controles como perillas, switches y pedales para enviar estos mensajes. Se puede guardar en la memoria de un dispositivo un conjunto de parámetros establecidos como un patch. Estos patches pueden ser seleccionados de manera remota a través de cambios de programa MIDI. El MIDI estándar permite una selección de 128 programas diferentes, pero hay muchos dispositivos que pueden permitir muchos más ajustando sus patches en bancos con 128 programas cada uno y combinando el mensaje de cambio de programa para la selección de un banco.[17]

Composición

[editar]Los eventos MIDI pueden ser secuenciados a través de un editor MIDI o una estación de trabajo especializada. Varias DAW están específicamente diseñadas para trabajar MIDI como componente integral. Las secuencias MIDI han sido desarrolladas en varios DAW para que los mensajes MIDI puedan ser modificados.[18] Estas herramientas permiten a los compositores probar y editar su trabajo con una mayor rapidez y eficiencia que otras soluciones como la grabación multipista, mejorar la eficiencia de compositores y permitir crear arreglos complejos sin necesidad de un entrenamiento.[19]

Debido a que el MIDI es un conjunto de comandos que crean sonidos, las secuencias MIDI pueden ser manipuladas de diferentes maneras en comparación con el audio pregrabado. Es posible cambiar la tonalidad, la instrumentación o el tempo de un arreglo MIDI,[20] y re-acomodar sucesiones de manera individual.[21] La habilidad de componer ideas y escucharlas de manera inmediata permite a los compositores experimentar.[19] Programas de composición algorítmica permiten que ejecuciones generadas por computadora puedan ser utilizadas como ideas para canciones o acompañamiento.[2]: 122

Algunos compositores aprovecharon la tecnología MIDI 1.0 y el General MIDI (GM) que permitía transferir datos musicales entre varios instrumentos utilizando un set de comandos y parámetros estandarizado. Los datos compuestos a través de una secuencia MIDI pueden ser guardados como Standard MIDI File (SMF), distribuidos de manera digital y reproducidos por cualquier computadora o instrumento electrónico que esté adherido al mismo estándar MIDI, GM, y SMF. Los datos MIDI son mucho más pequeños que las grabaciones de archivos de audio.

MIDI y las computadoras

[editar]En la época en que el MIDI fue introducido la industria de la computación estaba enfocada en computadoras mainframe. Las computadoras personales no eran muy comunes. El mercado de la computadora personal se estabilizó al mismo tiempo en que el MIDI apareció, con ellos las computadoras se convirtieron en una opción viable para la producción musical.[6] En los años posteriores a la ratificación de la especificación MIDI, las características MIDI fueron adaptadas a varias de las primeras plataformas de computación, incluyendo Apple II Plus, IIe y Macintosh, Commodore 64 y Amiga, Atari ST, Acorn Archimedes, y PC DOS.[6] Macintosh fue la favorita entre los músicos estadounidenses. Se encontraba a un precio competitivo, y sería años después que la eficiencia y su interfaz gráfica sería igualada por las PC's. El Atari ST fue el favorito de Europa, donde las Machintosh eran más caras.[6] Las computadoras Apple incluían un hardware de audio que era más avanzado que el de sus competidores. La Apple IIGS usaba un chip de sonido digital diseñado para el sintetizador Ensoniq Mirage. En posteriores modelos se empleó un sistema especializado de audio con procesadores mejorados, los cuales llevaron a las demás compañías a mejorar sus productos.[6] El Atari ST era preferido debido a que los conectores MIDI estaban integrados directamente en la computadora.[6]: 329 La mayoría del software musical de la primera década de publicación del MIDI fue para la Apple o el Atari.[6] Para el lanzamiento del Windows 3.0 en 1990, las PC's habían mejorado su interfaz gráfica junto con sus procesadores, por lo que diferentes softwares comenzaron a aparecer en diferentes plataformas.[6]

Archivos MIDI estándar

[editar]El formato estándar MIDI (SMF) permite una manera estandarizada para almacenar, transportar y abrir secuencias en otros sistemas. El tamaño compacto de estos archivos ha permitido que sean implementados de manera numerosa en computadoras, ringtones, páginas de Internet y tarjetas de felicitaciones. Fueron creados para su uso universal e incluir información como el valor de las notas, tiempo y nombre de las pistas. La lírica puede ser incluida como metadata, que puede ser visualizada en máquinas de karaoke.[22] La especificación SMF fue desarrollada y mantenida por MMA. Los SMF's son creados como formato para exportar información a secuenciadores software o estaciones musicales de trabajo. Organizan los mensajes MIDI en una o más pistas y en marcas temporales para volver a reproducir las secuencias. Una cabecera contiene la información del número de pistas, tempo y en cuál de los tres formatos SMF está el archivo. Un archivo del tipo 0 contiene la información de una presentación completa en una sola pista, mientras que las de tipo I contienen la información de cada una de las pistas ejecutadas de manera sincronizada. Los archivos de tipo II raramente son utilizados[23] y guardan múltiples arreglos, cada uno tiene su propia pista para ser reproducida en secuencia. Microsoft Windows empaqueta el SMF con Downloadable Sounds (DLS) en un archivo informático para el intercambio de recursos (RIFF), con archivos RMID con extensión .rmi. RIFF-RMID ha sido depreciado a favor de Extensible Music Files (XMF).[24]

Intercambio de archivos

[editar]Un archivo MIDI no es una grabación de la música. Más bien, es una secuencia de instrucciones, que suele ocupar del orden de 1000 veces menos espacio en bits que una grabación.[25] Esto hizo que los arreglos hechos en archivos MIDI se convirtieran en una manera más atractiva de compartir música, antes de la llegada del internet y dispositivos con un almacenamiento superior. Los archivos MIDI licenciados se encontraban disponibles en formato de disquete en tiendas de Europa y Japón durante los noventa.[26] La mayor desventaja de esto era la gran variedad que existía ente las tarjetas de audio de los usuarios y las muestras de audio o sonidos sintetizados en la tarjeta que el MIDI retomaba de manera simbólica. Aun una tarjeta de sonidos con samples de alta calidad puede tener inconsistencias entre la calidad de un instrumento a otro,[25] mientras que diferentes modelos de tarjetas no garantizaban un consistencia en el sonido de un mismo instrumento. Las primeras tarjetas económicas, como AdLib y Sound Blaster, utilizaban una versión simplificada de la tecnología de síntesis por modulación de frecuencias de Yamaha[27] reproducida a través de convertidores digitales-analógicos de baja calidad. La baja calidad de reproducción[25] de estas tarjetas ubicuas[27] se asumía que de algún modo era debido al MIDI. Esto creó la percepción del MIDI como audio de bajo calidad, mientras que en realidad el MIDI no tiene un sonido[28] y la calidad de su reproducción depende totalmente de la calidad el dispositivo que lo reproduzca (y los samples del dispositivo).[20]

Software MIDI

[editar]La principal ventaja de las computadoras personales en un sistema MIDI es que puede ser utilizado con diferentes propósitos, dependiendo del software utilizado.[2] La capacidad multitareas de los sistemas operativos permite la operación de varios programas de manera simultánea que puedan compartir los datos unos con otros.[2]

Secuenciadores

[editar]Un software para secuencia permite ciertos beneficios para un compositor u arreglista. Permite que el MIDI grabado sea manipulado utilizando a través de las características de edición básicas de una computadora como cortar, copiar y pegar o arrastrar y soltar. Los atajos de teclado pueden ser utilizados para agilizar el ritmo de trabajo y las herramientas de edición MIDI pueden ser seleccionadas a través de comandos. El secuenciador permite que cada canal sea reproducido por un sonido diferente además de mostrar una pre-visualización gráfica del arreglo. Existen distintas herramientas de edición, incluyendo una visualización en notación musical. Herramientas como loops, cuantización, aleatoriedad y transposición simplifican el proceso de creación de arreglos. La creación de beats es simplificada y el groove puede ser duplicado en la sensación rítmica de otra pista. La expresión realista puede ser agregada a través de la manipulación de controladores en tiempo real. Una mezcla puede ser llevada a cabo y el MIDI puede ser sincronizado con pistas de audio o video grabadas. Los avances pueden ser guardados y llevados a otra computadora o estudio.[29][30]

Los secuenciadores pueden tomar diferentes formas como editores de ritmos de batería que permiten al usuario crear ritmos a través de clics en rejillas de patrones[2] y hacer loops con secuencias, por ejemplo el ACID Pro, que permite al MIDI ser combinado con audios pregrabados, cuyos tiempos y notas son empatados. La secuencia de cúes es utilizada para activar diálogos, efectos de sonido y segmentos musicales en transmisiones.[2]

Software para edición de partituras

[editar]A través de MIDI, las notas en un piano pueden ser automáticamente transcritas a una partitura.[5] El software editor de partituras usualmente carece de herramientas avanzadas de secuenciación y se encuentra optimizado para la creación de partituras profesionales para instrumentistas.[30] Estos programas permiten la especificación de dinámicas y marcas de expresión, acordes y letras, además del diseño de partituras complejas.[30]: 167 El software disponible permite la impresión de partituras en braille.[31]

La ScoreCloud de DoReMIR Music Research es conocida como la mejor herramienta para la transcripción en tiempo real de MIDI a partitura.[32]

SmartScore (antes MIDIScan) de SmartScore permite revertir este proceso y puede reproducir archivos MIDI desde una partitura en un escáner.[33]

Entre los programas conocidos para la edición de partituras están Finale de MakeMusic y Encore creado originalmente por Passport Designs Inc., actualmente le pertenece a GVOX. Sibelius, originalmente creado para las computadoras RISC de Acorns, era muy bien aceptado que, antes de que las versiones de Windows y Macintosh estuvieran disponibles, los compositores adquirieron una Acorns solo para utilizar Sibelius.[34]

Editores y librerías

[editar]Los editores de patches permiten al usuario programar su equipo mediante el uso de una interfaz. Estos fueron esenciales con la llegada de sintetizadores más complejos como el Yamaha FS1R,[35] el cual tenía miles de parámetros programables pero tenía una interfaz que constaba de solo 15 botones pequeños, cuatro perillas y una pantalla pequeña LCD.[36] Los instrumentos digitales usualmente desaniman a los usuarios a la experimentación debido a la falta de control que permiten en sus perillas y switches,[37] pero los editores de patch pueden dar órdenes a instrumentos hardware y dispositivos de efectos la misma funcionalidad que existe en sintetizadores de software a los usuarios.[38] Algunos editores están diseñados para instrumentos específicos o dispositivos de efectos, mientras que otros, editores "universales" soportan distintos tipos de equipos e idealmente pueden controlar los parámetros de cada dispositivo.[2]

Las librerías de patches tienen la función especializada de organizar los sonidos en colecciones de equipos y permitir la transmisión de bancos enteros de sonidos entre un instrumento y una computadora. Esto permite al usuario aumentar las capacidades de almacenamiento de patches del dispositivo con una computadora[2]: 133 y compartir patch con otros usuarios del mismo instrumento.[39] Editores/librerías universales que combinan las dos funciones fueron comunes como "Galaxy" de Opcode Systems y SoundDiver de eMagic. Estos programas han caído en desuso debido a la llegada de la síntesis por computadora, aunque Unisyn de Mark of the Unicorn y Midi Quest de Sound Quest continúan disponibles. Kore de Native Instruments fue un intento por traer de vuelta el concepto de los editores/librerías a la era de los sintetizadores de software.[40]

Programas de auto-acompañamiento

[editar]Existen programas que de manera dinámica pueden generar pistas de acompañamientos llamadas programas de "auto-acompañamiento". Estos crean el arreglo de una banda completa a partir del estilo que el usuario seleccione, y los resultados son enviados a un dispositivo de sonido MIDI para generar los sonidos. Las pistas generadas pueden ser utilizadas como herramientas de pruebas o educativas, también como acompañamiento para presentaciones en vivo o ayuda para la composición de canciones. Algunos ejemplos son Band-in-a-Box,[41] el cual surge de la plataforma Atari en los ochenta, One Man Band,[42] Busker,[43] MiBAC Jazz, SoundTrek JAMMER[44] y DigiBand.[45]

Síntesis y sampling

[editar]Las computadoras pueden emplear un software para generar sonidos, los cuales pasan a través de un conversor de señal digital a analógica (DAC) a un sistema de altavoces.[5]: 213 La polifonía, el número de sonidos que pueden ser tocados de manera simultánea, depende de la potencia de la CPU de la computadora, así como del muestreo digital y de la resolución sonora de la reproducción, los cuales impactan de manera directa en la calidad del sonido resultante.[46] Los sintetizadores implementados en un software están sujetos a problemas de tiempo que no están presentes en los instrumentos de hardware reales, los cuales tienen sistemas operativos dedicados que no están sujetos a la interrupción de tareas de fondo como los sistemas operativos de escritorio. Estos problemas de tiempo pueden generar distorsiones debido al desfase entre diferentes pistas y clics cuando la reproducción es interrumpida. Los sintetizadores de software pueden ser afectados por latencia en la generación del sonido debido a que las computadoras utilizan Búfers de datos que retrasan la reproducción y se atrasan respecto de la señal MIDI (de comando).[47]

La síntesis de software surge en los años cincuenta, cuando Max Mathews de los Laboratorios Bell escribió el lenguaje de programación MUSIC-N, que era capaz de generar sonido pero no en tiempo real.[48] El primer sintetizador en correr directamente desde el CPU de una computadora[49] fue Reality, por Seer Systems de Dave Smith, el cual permitía una baja latencia a través de la integración de drivers y solo podía ser reproducido en tarjetas de sonido Creative Labs.[50] Algunos sistemas utilizaron un software dedicado para reducir el trabajo en el CPU, como el Kyma System de Symbolic Sound Corporation[48] y los sistemas Pulsar/SCOPE de Creamware/Sonic Core,[51] los cuales empleaban varios chips DSP en una Peripheral Component Interconnect (PCI) para dar energía a todos los instrumentos, efectos y mezcladoras.[52]

La capacidad de construir arreglos MIDI totalmente en una computadora permite al compositor posteriormente exportar el resultado como un archivo de audio.[16]

Música de videojuegos

[editar]Los primeros juegos de computadora eran distribuidos en disquetes y el reducido tamaño de los archivos MIDI hicieron que fueran una opción viable para la creación de bandas sonoras. Los juegos de la era DOS y las primeras versiones de Windows normalmente requerían una compatibilidad con las tarjetas de sonido Ad Lib o SoundBlaster. Esas tarjetas utilizaban la síntesis FM, la cual genera un sonido a través de la modulación de ondas sinusoidales. John Chowning, el pionero en la técnica, teorizó que la tecnología podría ser capaz de recrear con precisión cualquier sonido si suficientes ondas sinuosidades era empleadas, pero las tarjetas de audio económicas para computadora ejecutaban la síntesis FM con sólo dos ondas sinuosidales. Combinadas con las tarjetas de 8 bits, ofrecían un sonido descrito como "artificial"[53] y "primitivo".[54] Posteriormente se hicieron placas que tenían almacenadas muestras de audio que podían ser utilizadas en lugar de la síntesis FM. Estas eran costosas, pensaban sonidos de instrumentos MIDI como el E-mu Proteus.[54] La industria de las computadoras a mediados de los noventa se enfocó en tarjetas de sonido basadas en la síntesis de sonido mediante tablas de ondas con una reproducción de 16 bits pero estandarizadas en un ROM de 2MB, un espacio muy pequeño para muestras de audio de calidad para 128 instrumentos más percusión. Algunos fabricantes utilizaron muestras de 12 bits ajustados a esos 16 bits.[55]

Otras aplicaciones

[editar]MIDI ha sido adoptado también como un protocolo de control para aplicaciones no musicales. MIDI Show Control emplea comandos MIDI para dirigir las luces y activar eventos en producciones teatrales. VJ's y turntablistas lo utilizan para reproducir vídeos o sincronizar equipo y los sistemas de grabación lo utilizan para la sincronización y automatización. Apple Motion permite el control de parámetros animación a través de MIDI. El videojuego de disparos en primera persona 1987 llamado MIDI Maze(portado a Game Boy en 1991,a Game Gear en 1992 y a SNES en 1993) y el puzle Oxyd (1990) de Atari ST(portado a Windows en 1992) utilizaban MIDI para conectar computadoras. Algunos kits para el control de las luces o aplicaciones en el hogar emplean MIDI.[56]

Pese a su asociación con los dispositivos musicales, MIDI puede controlar cualquier dispositivo y puede leer y procesar cualquier comando MIDI. Es posible enviar una nave al espacio desde la tierra a otro destino, controlar la luz de la casa, la calefacción y el aire acondicionado o secuenciar semáforos, todo a través de comandos MIDI. El dispositivo u objeto que reciba la señal MIDI requerirá de un procesador General MIDI, en este caso, los cambios del programa activarían una función en ese dispositivo en lugar de las notas de un instrumento MIDI. Cada función puede ser establecida a un reloj (también controlado por MIDI) otra condición determinada por el creador del dispositivo.

Dispositivos MIDI

[editar]Conectores

[editar]

Inicialmente los cables midi terminaban en un conector DIN de 180°. Las aplicaciones estándar emplean solo tres de los cinco conductores: tierra y un par de cables balanceados que llevan un señal de 5v.[41] : 41 Esta configuración del conector solo puede llevar mensajes en una dirección, así que es necesario un cable para una comunicación de dos vías.[2]: 13 Algunas aplicaciones prioritarias como la alimentación phantom para algunos controladores utilizan los pines sobrantes para la transmisión de corriente directa (DC).[57]

Mediante Optoacopladores mantienen los dispositivos MIDI eléctricamente separados de otros conectores, lo cual impide bucles de masa[58]: 63 y protege al equipo de picos de voltage.[6]: 277 No había inicialmente un sistema manera de detectar errores en MIDI, así que el tamaño máximo del cable es de 15 metros (50 pies) para limitar interferencias destructivas.[59]

La mayoría de los dispositivos no copian los mensajes de la entrada a su puerto de salida. Un tercer tipo de puerto, el puerto "thru", emite una copia de todo lo que es recibido en el puerto de entrada "in", permitiendo que los datos sean transmitidos a otro instrumento[6]: 278 en una "Daisy chain".[60] No todos los dispositivos cuentan con un puerto thru y dispositivos que carecen de la característica de generar datos MIDI, como unidades de efectos o módulos de sonido, pueden no incluir un puerto de salida.[37]: 384

Manejo de dispositivos

[editar]Cada dispositivo en una cadena retrasa el sistema. Esto se evita a través de una caja MIDI thru, la cual contiene varias salidas que proporcionan una copia de la señal de entrada. Un mezclador MIDI es capaz de combinar múltiples dispositivos en una sola señal y permite que múltiples controladores sean controlados mediante un solo dispositivo. Un switch MIDI permite cambiar entre múltiples dispositivos y elimina la necesidad de volver a conectar los cables. Los paneles de conexiones MIDI combinan todas estas funciones. Tienen múltiples entradas y salidas que permiten cualquier combinación de canales de entrada para ser enviados a cualquier salida. Las conexiones pueden ser creadas utilizando un software, almacenándolas en una memoria y seleccionarlas desde comandos para cambio de programa MIDI.[2]: 47–50 Esto permite a los dispositivos funcionar como routers MIDI en situaciones donde no se encuentra una computadora disponible.[2]: 62–3 Los paneles de conexiones MIDI también son empleados para limpiar bits de datos MIDI desviados en sus entradas.

Se utilizan procesadores de datos MIDI para tareas y efectos especiales. Estos incluyen filtros MIDI, los cuales eliminan datos MIDI de una señal, y delays MIDI, los cuales envían una repetición de datos MIDI de entrada en un tiempo determinado.[2]: 51

Interfaces

[editar]La función principal de una interfaz MIDI por computadora es sincronizar los relés entre un dispositivo MIDI y la computadora.[60] Algunas tarjetas de sonido de computadora incluyen un conector MIDI estándar, mientras que en otras se conecta a través de D-sub DA-15 puerto de juegos, USB, firewire o ethernet. El creciente uso de conectores USB en los 2000's ha llevado a una disponibilidad de interfaces MIDI a USB que puedan transferir canales MIDI a computadoras con USB incluido. Algunos controladores MIDI están equipados con conectores USB y pueden ser conectados en computadoras que empleen software musical.

La transmisión serial MIDI lleva a problemas de sincronización. Músicos experimentados pueden detectar diferencias de 1/3 de milisegundos (ms)[cita requerida] (es el tiempo que tarda el sonido en viajar 4 pulgadas) y un mensaje MIDI de 3 bytes requiere 1ms para transmitirse.[61] Debido a que el MIDI es serial, solo puede ser enviado un evento a la vez. Si un evento es enviado a dos canales a la vez, el evento con número de canal mayor no podrá ser transmitido hasta que el primero haya acabado y será retrasado 1ms. Si un evento es enviado a todos los canales al mismo tiempo, el evento con un número de canal mayor será retrasado por mucho 16ms. Esto ha contribuido al surgimiento de interfaces MIDI con múltiples entradas y salidas debido a que la sincronización mejora cuando los eventos son enviados en diferentes puertos a diferencia de varios canales en un mismo puerto.[47] El término "tropiezo MIDI" se refiere a los errores audibles resultantes de una transmisión retrasada.[62]

Controladores

[editar]Existen dos tipos de controladores MIDI: controladores para performance que generan notas y son utilizados para ejecutar música,[63] y controladores que pueden no transmitir notas pero pueden transmitir otros tipos de eventos en tiempo real. Varios dispositivos son la combinación de los dos tipos.

Controladores para performance

[editar]

El MIDI fue diseñado con los teclados en mente y cualquier otro controlador que no posea un teclado es considerado como un controlador "alternativo".[64] Esto ha sido visto como una limitación para los compositores que no están interesados la música que emplea teclados, la flexibilidad y compatibilidad MIDI fue introducida a otros tipos de controladores incluyendo guitarras, instrumentos de viento y cajas de ritmo.[5]: 23

Teclados

[editar]Los teclados musicales son el tipo de controlador MIDI más común.[39] Se pueden encontrar en diferentes tamaños desde los de 25 teclas, modelos de dos octavas, hasta instrumentos de 88 teclas. Algunos solo incluyen el teclado, aunque existen modelos con otros controladores en tiempo real como perillas, sliders y palancas.[65] Usualmente tienen también conexiones para pedales de sustain y de expresión. La mayoría de los controladores con teclado permiten dividir el área de piano en zonas, las cuales pueden ser de diferentes tamaños y sobreponerse. Cada zona corresponde a un canal MIDI diferente y un set diferente de controladores, y pueden ser usados para tocar cualquier rango de notas seleccionado. Esto permite a un solo instrumento reproducir varios sonidos diferentes.[2]: 79–80 Las capacidades MIDI también pueden ser encontradas en instrumentos de teclado tradicionales como pianos[2]: 82 y pianos Rhodes.[66] Pedaleros pueden controlar los tonos de un órgano MIDI o pueden tocar un sintetizador como el Moog Taurus.

Controladores de viento

[editar]Los controladores de viento permiten que secciones MIDI sean tocadas con la misma expresión y articulación posible de los instrumentos de viento convencionales. Permiten que el aliento y el control de tono produzcan una manera más versátil de fraseo, particularmente cuando se tocan partes de instrumentos de viento físicamente modeladas o samples.[2]: 95 Un controlador típico de viento tiene un sensor que convierte la presión del aliento en información de volumen y puede controlar el tono aunque también se puede hacer con un sensor de presión en los labios y una perilla para el tono. Algunos modelos permiten la configuración de los diferentes sistemas de ejecución de diferentes instrumentos.[67] Dentro de los ejemplos de estos controladores podemos encontrar el EWI de Akai y el Electronic Valve Instrument (EVI). El EWI utiliza un sistema de botones y perillas modelados a partir de un instrumento de viento-madera, mientras que el EVI está basado en un instrumento de viento-metal y tiene tres switches que emulan las válvulas de una trompeta.[6]: 320–321

Baterías y controladores de percusión

[editar]

Los teclados de tipo piano pueden ser utilizados para accionar sonidos de baterías pero no son prácticos para tocar patrones repetitivos como redobles debido a las dimensiones de las teclas. Después de los teclados, los pads de batería son los controladores para performance MIDI más significativos.[6]: 319–320 Los controladores de percusión pueden estar integrados en cajas de ritmo, pueden ser superficies de control independientes o emular y sentirse como instrumentos de percusión. Los pads integrados en cajas de ritmos usualmente son muy pequeños y frágiles para ser tocados con baquetas y se tocan con los dedos.[2]: 88 Drum pads especializados como el Roland Octapad o el DrumKAT son tocados con las manos o baquetas y están construidos como un set de batería. Existen otros controladores de percusión con el MalletKAT, parecido al vibráfono,[2]: 88–91 y el Marimba Lumina de Don Buchla.[68] Se pueden instalar accionadores MIDI en una batería acústica e instrumentos de percusión. Los pads pueden accionar un dispositivo MIDI que puede ser incluso casero a partir de un sensor piezoeléctrico o un pad de práctica.[69]

Instrumentos controladores de cuerdas

[editar]Una guitarra puede ser ajustada con pastillas especiales que digitalicen la salida del instrumento y permiten tocar sonidos de sintetizadores. Cada cuerda está asignada a un canal MIDI distinto y dan la oportunidad al ejecutante de tocar el mismo sonido en todas la cuerdas o diferentes para cada una.[2]: 92–93 Algunos modelos, como el Yamaha G10, emplean electrónicos en lugar del cuerpo de una guitarra.[6]: 320 Otros sistemas, como las pastillas de Roland pueden ser incluidas o ajustadas a un instrumento estándar. Max Mathews diseño un violín MIDI para Laurie Anderson a mediados de los ochenta, además de violas, violonchelos, contrabajos y mandolinas.[70]

Controladores especializados para performance

[editar]Algunos controladores digitales para DJ pueden funcionar por sí solos como el FaderFox o el Xone 3D de Allen & Heath o pueden estar integrados por algún software específico como Traktor o Scratch Live. Estos comúnmente responden a la sincronización del reloj MIDI y permiten un control sobre la mezcla, samples, efectos y loops.[71]

Los accionadores MIDI adheridos a los zapatos o a la ropa son usados usualmente por performers. El sensor inalámbrico Kroonde Gamma puede capturar movimiento en señales MIDI.[72] Los sensores colocados en el escenario de la Universidad de Texas en Austin convierte los movimientos de los danzantes en mensajes MIDI[73] y la instalación Very Nervous System de David Rokeby crea música a partir de los movimiento de las personas.[74] Existen aplicaciones de software que permiten el uso de dispositivos iOS como controladores de gestos.[75]

Existen numerosos controladores experimentales los cuales abandonan las interfaces musicales tradicionales completamente. Algunos de estos incluyen el control a través de gestoras como el Buchla Thunder,[76] el C-Thru Music Axis,[77] el cual re-acomoda las escalas en una visualización isométrica,[78] o el continuum de Haken Audio.[79] Los controladores experimentales MIDI pueden ser creados a partir de objetos inusuales como una tabla de planchar con sensores de calor instalados[80] o un sofá con sensores de presión equipados.[81]

Controladores auxiliares

[editar]Los sintetizadores de software poseen de un gran poder y versatilidad pero algunos ejecutantes consideran que existe una división de la atención entre un teclado MIDI y un teclado de computadora con un mouse que roba la inmediatez en la experiencia de tocar.[82] Dispositivos dedicados al control MIDI en tiempo real permiten un beneficio ergonómico además de ofrecer una sensación de conexión con el instrumento en lugar del uso de un mouse o un botón digital. Los controladores en general son dispositivos con varios propósitos que están diseñados para trabajar con varios tipos de equipos o pueden estar diseñados para trabaje con algún software específico. Algunos ejemplos son el APC40 de Akai para Ableton Live y el MS-20ic de Korg que es una reproducción del sintetizador analógico MS-20. El controlador MS-20ic incluye cables para patch que pueden ser usados para controlar la señal en la reproducción virtual del sintetizador MS-20, también puede controlar otros dispositivos.[83]

Superficies de control

[editar]Las superficies de control son dispositivos de hardware que permiten una variedad de controles que transmiten mensajes de control en tiempo real. Estos instrumentos con software pueden ser programados sin un uso excesivo de movimiento de mouse[84] o el ajuste de dispositivos de hardware sin la necesidad de operarlos a través de varios menús. Botones, controles deslizantes y perillas son los controladores más comunes. También se pueden encontrar codificadores rotatorios, controles de transport, joysticks, controladores de listón, touchpads vectoriales como el Kaoss pad de Korg y controladores ópticos como el D-Beam de Roland. Las superficies de control pueden ser usadas para mezclar, automatizar secuencias, tornamesas y control de luces.[84]

Controladores especializados en tiempo real

[editar]Las superficies de control de audio usualmente tienen un parecido con las mesas de mezcla en su apariencia y permiten cierto nivel de control para cambiar parámetros como el nivel de sonido y los efectos aplicados a pistas individuales de una grabación multipista o presentación en vivo.

Los pedales MIDI son comúnmente utilizados para enviar cambios de programa MIDI a dispositivos de efectos pero pueden ser combinados con los pedales de algún instrumento que permita una programación detallada de los unidades de efectos. Los pedales están disponibles en forma de switches prendido/apagado, momentáneos o pedales en donde su posición determina su valor MIDI.

Controladores deslizantes son utilizados para MIDI y órganos virtuales. Junto con un set de controladores deslizantes para un control del timbre, permiten controlar efectos estándar de un órgano como la velocidad de rotación , el vibrato y coro de un Leslie speaker.[85]

Instrumentos

[editar]

Un instrumento MIDI tiene puertos para enviar y recibir señales MIDI, una CPU para procesar dichas señales, una interfaz que permita al usuario programarlo, un circuito de audio que genere sonidos y controladores. El sistema operativo y los sonidos de fábrica usualmente están almacenados en una memoria de solo lectura (ROM).[2]: 67–70

Un instrumento MIDI también puede ser un módulo independiente (sin la necesidad de un teclado) conformado por una tarjeta de sonido General MIDI (GM, GS y /XG) editable dentro de la misma, incluyendo cambios de transposición del tono, cambios de instrumento MIDI, ajuste de volumen, panel, niveles de reverberación y otros controladores MIDI. Normalmente, el módulo MIDI incluye una pantalla grande, permitiendo al usuario visualizar la información dependiendo de la función seleccionada. Otras funciones incluyen el visualizar la lírica, usualmente incluida en un archivo MIDI o Karaoke MIDI, listas de pistas, librería de canciones y pantallas de edición. Algunos módulos MIDI incluyen un armonizador y la capacidad de reproducir y reajustar el transpose de archivos MP3.

Sintetizadores

[editar]Los sintetizadores pueden emplear cualquier variedad de técnicas para generar sonido. Estos normalmente incluyen un teclado integrado, o pueden existir como "módulos de sonido" que generan sonidos a partir de un controlador externo. Los módulos de sonidos están típicamente diseñados para ser colocados en un rack de 19 pulgadas.[2]: 70–72 Los fabricantes producen comúnmente un sintetizador en versiones independiente y para rack, usualmente la versión con teclado varía de tamaño.

Samplers

[editar]Un sampler puede grabar y digitalizar audio, almacenarlo en una memoria de acceso aleatorio (RAM) y reproducirlo posteriormente. Los samplers normalmente permiten al usuario editar un sample y guardarlo en un disco duro, aplicarle efectos y modificar su sonido a través de las mismas herramientas usadas en los sintetizadores. También pueden tener un teclado o estar montados en un rack.[2]: 74–8 Los instrumentos que generan sonidos a través de su reproducción pero que no tienen capacidades de grabación son conocidos como "ROMplers".

Los samplers no se convirtieron en instrumentos MIDI viables tan rápido como lo hicieron los sintetizadores debido al costo de la memoria y la potencia de procesamiento necesaria entonces.[6]: 295 El primer sampler MIDI de bajo costo fue el Ensoniq Mirage, lanzado en 1984.[6]: 304 Los samplers MIDI normalmente están limitados debido a sus pequeñas pantallas empleadas para editar las formas de onda sampleadas, aunque algunos pueden ser conectados a un monitor de computadora.[6]: 305

Cajas de ritmos

[editar]Las cajas de ritmos normalmente son dispositivos especializados que reproducen samples de batería y sonidos de percusión. Usualmente tienen un secuenciador que permite la creación de patrones ritmos para incorporarlos en el arreglo de alguna canción. Comúnmente tienen múltiples salidas que permiten que cada uno de los sonidos sea asignado a cada una. Los sonidos individuales de las baterías pueden ser reproducidos desde otro instrumento MIDI o desde un secuenciador.[2]: 84

Workstations y secuenciadores de hardware

[editar]

La tecnología de los secuenciadores surgió antes que el MIDI. Los secuenciadores analógicos emplean señales de control de voltaje para controlar sintetizadores analógicos pre-MIDI. Los secuenciadores MIDI normalmente operan a través de funciones de transporte creadas a partir de las grabadoras. Son capaces de grabar secuencias MIDI y organizarlas en pistas individuales a través del concepto de la grabación multipista. Las workstations combinan controladores de teclado con un generador de sonidos interno y un secuenciador. Las workstations pueden ser usadas para crear arreglos completos y reproducirlos a través de los sonidos integrados, funcionando como pequeños estudios de producción. Usualmente incluyen una unidad de almacenamiento y capacidades de transferencias.[2]: 103–4

Dispositivos de efectos

[editar]Los efectos de audio son frecuentemente usados en el escenario y en las grabaciones como la reverberación, delay y chorus, pueden ser ajustados de manera remota a través de señales MIDI. Algunas unidades solo permiten un cierto número de parámetros que puede ser controlados de esta manera, pero la mayoría responde ante mensajes de cambio de programa. El H3000 Ultra-harmonizer de Eventide es un ejemplo de una unidad que permite un control completo MIDI que funciona como un sintetizador.[6]: 322

Especificaciones técnicas

[editar]Los mensajes MIDI están conformados de una "palabra" de 8 bits (llamados bytes) que son transmitidos de manera serial a 31.25 kbit/s. Esta tasa fue escogida debido a que es una división exacta de 1 MHz, la velocidad en la que varios de los primeros microprocesadores operan.[6]: 286 El primer bit de cada palabra identifica si la palabra es un byte de estatus o de datos, los siguientes siete bits son la información.[2]: 13–14 Un bit de inicio y otro de pausa son agregados a cada byte por cuestiones de sincronización, así que un mensaje MIDI requiere de diez bits para transmitirse.[6]: 286

Una conexión MIDI puede llevar dieciséis canales independiente de información. Los canales son numerados del 1 al 16 pero en realidad corresponden al orden del código binario del 0 al 15. Un dispositivo puede ser configurado para solo escuchar canales específicos e ignorar los mensajes enviados de otros (modo “Omni Off”) o puede escuchar a todos los canales sin importar su dirección (“Omni On”). Un dispositivo puede ser monofónico (el inicio de una nueva señal de “note-on” MIDI implica el final de la nota previa) o polifónico (múltiples notas pueden sonar al mismo tiempo, hasta que el límite de la polifonía del instrumento se haya alcanzado, las notas hayan terminado su envolvente o el comando “note-off” haya sido recibido. Los dispositivos que reciben los mensajes normalmente tienen cuatro combinaciones de los modos “omni off/on” vs. “mono/poly”.[2]: 14–18

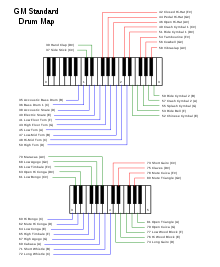

Instrumentos General MIDI

[editar]Estos son los números de los 128 timbres de instrumentos de la especificación General MIDI, incluida en la especificación detallada MIDI 1.0, del inglés "Complete MIDI 1.0 detailed specification":

|

|

|

|

Mensajes

[editar]Un mensaje MIDI es una instrucción que controla algún aspecto del dispositivo receptor. Un mensaje MIDI consiste en un byte de estatus, el cual indica el tipo del mensaje, seguido de dos bytes de datos que contienen los parámetros.[20] Los mensajes MIDI pueden ser "mensajes de canal", los cuales son enviados a unos de los dieciséis canales y puede ser escuchado solo por los dispositivos en ese canal, o "mensajes de sistema", los cuales pueden ser escuchados por todos los dispositivos. Cualquier dato no relevante para un dispositivo receptor es ignorado.[37]: 384 Existen cinco tipos de mensajes: "Channel Voice", "Channel Mode", "System Common", "System Real-Time" y "System Exclusive".[86]

Los mensajes Channel Voice transmiten datos de performance en tiempo real a través de un solo canal. Algunos ejemplos son los mensajes "note-on" que contienen el número de nota MIDI que especifica el tono de la misma, un valor de velocidad que indica cuanta fuerza tiene la nota y el número del canal; los mensajes "note-off" indican el final de la nota; mensajes de cambio de programa que modifican el patch del dispositivo y cambios de control que ajustan los parámetros del instrumento. Los mensajes Channel Mode incluyen los mensajes Omni/mono/poly mode on y off, así como mensajes que restablecen todos los controladores a su estado inicial o para enviar mensajes "note-off" para todas las notas. Los mensajes System no incluyen los números de los canales y son recibidos por cada dispositivo MIDI conectado. El MIDI time code es un ejemplo de un mensaje System común. Los mensajes System Real-Time contienen datos para sincronización e incluyen MIDI clock y Active Sensing.[2]: 18–35

Mensajes System Exclusive

[editar]Los mensajes System Exclusive (SysEx) son la mayor razón de la flexibilidad y longevidad del estándar MIDI.[87] Permiten que los fabricantes creen mensajes propietarios específicos de los instrumentos de cada fabricante, los cuales permiten un control del equipo de manera específica y no contenidos en los mensajes estándar MIDI.[6]: 287 Los mensajes SysEx solo funcionan en un dispositivo específico en un sistema. Cada fabricante tiene un identificador único que está incluido en los mensajes SysEx, el cual hace que los mensajes solo sean escuchados por un dispositivo específico y sean ignorados por todos los demás. Varios instrumentos también incluyen un SysEx ID, el cual permite que dos dispositivos del mismo modelo sean direccionados de manera independiente mientras están conectados al mismo sistema.[88] Los mensajes SysEx pueden incluir una mayor funcionalidad que el estándar MIDI permite. Están dirigidos a un instrumento en específico y son ignorados por los otros dispositivos conectados al sistema. Muchos mensajes sysex no están documentados.

La implementación del mapa MIDI

[editar]No todos los dispositivos midi responden a todos los mensajes definidos en la especificación MIDI. Por ejemplo hay muchos instrumentos reales que producen sonidos en la realidad que abarcan menos octavas que la referencia (un piano de 88 teclas), como por ejemplo una trompeta. La implementación del mapa MIDI fue estandarizado por la MMA como un forma en que los usuarios para que conozcan las capacidades que tiene un instrumento y como responde a los mensajes.[2]: 231 En la documentación de todo dispositivo midi hay usualmente una lista con los comandos midi que usa (mapa Midi).

Extensiones

[editar]

La flexibilidad del MIDI y su gran aceptación ha llevado a varios refinamientos del estándar, además ha permitido que se aplique a propósitos más allá de los que se tenían inicialmente planeados.

General MIDI

[editar]MIDI permite la selección de los sonidos de un instrumento a través de mensajes de cambio de programa pero no hay una garantía de que dos instrumentos produzcan el mismo sonido dada una misma localización de programa.[89] Inicialmente el programa #0 podía ser el piano en un instrumento y en otro puede ser una flauta. El estándar General MIDI (GM) fue establecido en 1991 y permite un banco de sonidos estandarizados que permite que un archivo Standard MIDI creado en un dispositivo pueda sonar similar en otro. El GM especifica un banco de 128 sonidos organizados en 16 familias de 8 instrumentos relacionados, y asigna un número de programa específico a cada uno de estos instrumentos. Los instrumentos de percusión son colocados en el canal 10 y un valor específico MIDI es colocado en cada sonido percusivo. Los dispositivos compiladores GM deben de ofrecer polifonía de 24 notas.[90] Cualquier cambio de programa dado seleccionara el mismo tipo de sonido de instrumento en cualquier instrumento compatible GM[91]

El estándar GM elimina las variación en el mapping de una nota. Algunos fabricantes difieren en qué nota debe representar el Do central, pero el GM especifica que la nota número 68 toca La 440, la cual ajusta el Do central en 60. Los dispositivos compatibles GM requieren responder a la velocidad (intensidad), aftertouch y pitch bend, estar especificados a valores de default al inicio y ser compatibles con ciertos números de controladores como el pedal de sustain y números de parámetros registrados[92] Una versión simplificada de GM, denominada "GM Lite", es utilizada en teléfonos móviles y otros dispositivos con limitaciones respecto a la capacidad de procesamiento.[89]

GS, XG y GM2

[editar]Con el uso se vio que solamente 128 instrumentos de GM no eran suficientes. Tanto roland como Yamaha desarrollaron conjuntos adicionales. El estándar general de Roland, o GS, es un sistema que incluye sonidos adicionales, baterías y efectos, permite un comando de "selección de banco" que puede acceder a ellos y usar un número de parámetros no registrados MIDI (NRPNs) para acceder a nuevos sonidos y nuevas funciones. Por su parte, Yamaha desarrolló su propio sistema diferente, el Extended General MIDI, o XG en 1994. XG ofrece de manera similar otros sonidos, baterías y efectos, pero usa controladores estándar en lugar de los NRPNs para la edición e incrementa la polifonía a 32 voces. Ambos estándares GS y XG incluyen la compatibilidad con la especificación GM, pero no son compatibles entre sí.[93] Ninguno de estos dos estándares han sido implementados más allá de sus propios creadores pero son comúnmente empleados por softwares musicales de ambos fabricantes y de otros.

Compañías pertenecientes a la Association of Musical Electronics Industry (AMEI) de Japón desarrollaron el General MIDI Level 2 en 1992. GM2 mantiene su compatibilidad con GM pero incrementa la polifonía a 32 voces, estandariza los números de los controladores como el sostenuto y soft pedal (una corda), RPNs y mensajes Universal System Exclusive, además incorpora el estándar de Afinación MIDI.[94] GM2 es la base del mecanismo de selección de instrumento en Scalable Polyphony MIDI (SP-MIDI), una variante MIDI para dispositivos de baja potencia que permite una polifonía escalada acorde a la potencia de procesamiento del dispositivo.[89]

MIDI Tuning Standard

[editar]La mayoría de los sintetizadores MIDI usan afinación por temperamento igual. El MIDI Tuning Standard (MTS), creado en 1992, permite también afinaciones alternativas.[95] MTS permite microafinaciones que pueden ser cargadas desde un banco de 128 patches y permite el ajuste en tiempo real del tono de las notas.[96] Los fabricantes no necesitan cumplir este estándar. Aquellos que lo emplean no requieren implementar todas las funciones.[95]

MIDI Time Code

[editar]Un secuenciador puede manejar un sistema MIDI con su reloj interno, pero cuando el sistemas contiene múltiples secuenciadores, necesitan estar sincronizados por un mismo reloj. MIDI Time Code (MTC), desarrollado por Digidesign,[97] implementa mensajes SysEx[98] que han sido desarrollados especialmente para cuestiones de sincronización y es capaz de convertir datos entre el estándar SMPTE time code.[6]: 288 MIDI Clock está basado en el tempo, pero el SMPTE está basado en los cuadros por segundo y es independiente del tempo. MTC, como código SMPTE, incluye información acerca de posición y puede ser ajustado por sí mismo si un pulso está fuera de tiempo.[99] Las interfaces MIDI como MIDI Timepiece de Mark of the Unicorn pueden convertir entre SMPTE a MTC.[100]

MIDI Machine Control

[editar]MIDI Machine Control (MMC) consiste en una serie de comandos SysEx[101] que operan los controles de transport de los dispositivos hardware de grabación. MMC permite que un secuenciador envíe comandos "Start", "Stop" y "Record" a una grabadora o un sistema de disco duro de grabación además de avanzar o rebobinar el dispositivo y así reproducir desde el mismo punto del secuenciador. Ningún dato de sincronización está involucrado, aunque hay dispositivos que pueden sincronizar a través de MTC.[102]

MIDI Show Control

[editar]

MIDI Show Control (MSC) es una serie de comandos SysEx que permiten secuenciar y activar de manera remota dispositivos de control de un show como la iluminación, música y playback, además de sistemas de control de movimiento.[104] Algunas aplicaciones incluyen la producción de escenarios, exhibiciones de museos, sistemas de grabación de audio y parques de atracciones.[103]

MIDI timestamping

[editar]Una solución para los problemas de sincronización MIDI es marcar los eventos MIDI con un indicador cuando son reproducidos y almacenarlos en un buffer en la interfaz MIDI adelantada al evento. Enviando datos anticipados se reduce la probabilidad de que un pasaje con mucha información envíe una gran cantidad de información que sature el enlace de transmisión. Una vez almacenada en la interfaz, la información no estará sujeta a problemas de sincronización asociados con la latencia del USB o interrupciones del sistema operativo y puede ser transmitida con cierto grado de precisión.[105] MIDI timestamping solo funciona cuando el hardware y el software son compatibles. MTS de MOTU, AMT de eMagic y Midex 8 de Steinberg son implementaciones que fueron incompatibles una con otras, requerían de usuarios que tuvieran software y hardware fabricados por la misma compañía para incrementar sus ganancias.[47] Timestamping está integrado dentro de las interfaces FireWire MIDI[106] y Core Audio de Mac OS X.

MIDI Sample Dump Standard

[editar]Una capacidad no prevista de los mensajes SysEx era usarlos para el transporte de samples de audio entre instrumentos. SysEx es muy poco usado para este propósito ya que las palabras MIDI están limitadas a siete bits de información y un sample de 8 bits requiere de dos bytes para su transmisión en lugar de uno. Esto llevó al desarrollo del estándar Sample Dump Standard (SDS), el cual establece un protocolo para la transmisión de samples.[6]: 287 El SDS fue mejorado con un par de comandos que permiten la transmisión de la información de los puntos de loop de un sample sin requerir que todo el sample sea transmitido.[107]

Downloadable Sounds

[editar]La especificación de Downloadable Sounds (DLS), creada en 1997, permite que dispositivos móviles y tarjetas de sonido de computadora expandieran sus tablas de ondas con sets de sonidos descargables.[108] La especificación DLS Level 2 creada en 2006 y definida como la arquitectura estandarizada de los sintetizadores. El estándar Mobile DLS emplea los bancos DLS combinados con SP-MIDI como archivos Mobile XMF.[109]

Hardwares alternativos de transporte de señales midi

[editar]Además de la tasa de transmisión 31.25 kbit/s en un conector DIN de cinco pines, otros conectores comunes han sido usados para la misma información eléctrica y la transmisión de señales MIDI en diferentes formas a través de USB, IEEE 1394 o FireWire y Ethernet . Algunos samplers y grabadoras de disco duro pueden transmitir datos MIDI entre ellos con SCSI.

USB y FireWire

[editar]Los miembros de USB-IF en 1999 desarrollaron un estándar para MIDI a través de USB, el "Universal Serial Bus Device Class Definition for MIDI Devices"[110] El MIDI sobre el USB ha sido más común que otras interfaces que ha sido empleadas para las conexiones MIDI (serial, joystick, etc.) han desaparecido de las computadoras personales. Los sistemas operativos Microsoft Windows, Macintosh OS X y Apple iOS han incluido drivers para compatibilidad con "Universal Serial Bus Device Class Definition for MIDI Devices". Los drivers también están disponibles para Linux. Algunos fabricantes decidieron implementar una interfaz MIDI sobre el USB que está diseñado para operar diferente de la especificación, usando drivers personalizados.

Apple Computer desarrolló la interfaz FireWire durante los años noventa. Comenzó a aparecer en cámaras de video digitales hacia finales de la década y en modelos de la computadora de Apple G3 Macintosh en 1999.[111] Este interfaz propietario fue creado para aplicaciones multimedia.[106] A diferencia del USB, FireWire usa controladores inteligentes que pueden manejar su propia transmisión sin la atención de un CPU principal.[112] Al igual que los dispositivos MIDI estandarizados, los dispositivos FireWire pueden comunicarse entre sí sin la intervención de una CPU o computadora.[113]

Conectores XLR

[editar]El sintetizador Voyetra-8 de Octave-Plateau fue el primero en implementar MIDI a través de conectores XLR en lugar de los conectores DIN de 5 pines. Fue lanzado antes de la salida del MIDI y fue adaptado con una interfaz MIDI manteniendo su conector XLR.[114]

Serial paralelo y el puerto joystick MIDI

[editar]Debido a que el uso de computadoras en los estudios creció, comenzaron a salir dispositivos MIDI que se pudieran conectar directamente a la computadora. Estos normalmente usaban un conector Mini-DIN de ocho pines que fue usado por Apple para los puertos serie y para impresoras ante de la introducción de los modelos Power Macintosh G3. Interfaces MIDI fueron creadas con la intención de que fueran la parte central del estudio, como Mark of the Unicorn, fueron posibles debido al modo de transmisión de datos "rápido" que podía tomar ventaja de la habilidad de los puertos seriales de operar 20 veces más rápido que la velocidad estándar MIDI.[2]: 62–3 [113] Los puertos Mini-DIN fueron integrados en algunos instrumentos MIDI de finales de los noventa y permitían que se pudieran conectar directamente a la computadora.[115] Algunos dispositivos conectados a través del puerto paralelo DB-25 o en el puerto de joystick pueden ser encontrados en algunas tarjetas de sonido de PC.[113]

mLAN

[editar]Yamaha introdujo el protocolo mLAN en 1999. Fue concebido como una red de área local para instrumentos musicales usando FireWire y fue diseñado para llevar múltiples canales MIDI juntos con audio digital de múltiples canales, transferencias de archivos de datos y time code.[111][112] mLan fue usado en un número de productos de Yamaha, comúnmente en las mezcladoras digitales, en sintetizador Yamaha Motif y en productos como FIREstation de PreSonus y el Korg Triton Studio.[116] Desde 2007 no han sido lanzado productos mLan.

Ethernet

[editar]La implementación del MIDI en una red de computadoras permite nuevas capacidades de conexiones y permite un canal con gran ancho de banda que las primeras alternativas de MIDI, como ZIPI, trataron de crear. Las implementaciones propietarias han existido desde los ochenta, como lo es el uso de cables de fibra óptica para la transmisión.[2]: 53–4 La especificación abierta RTP MIDI del Grupo de trabajo de ingeniería de internet está adquiriendo el apoyo de la industria debido a que los protocolos propietarios MIDI/IP requieren costos altos de licencias o no ofrecen ninguna ventaja además de la velocidad sobre el protocolo MIDI original. Apple ha apoyado este protocolo desde Mac OS X 10.4 y existe un driver de Windows basado en la implementación de Apple desde Windows XP y para las nuevas versiones desde 2012.[117]

OSC

[editar]El protocolo OpenSound Control (OSC) fue desarrollado en Center for New Music and Audio Technologies (CNMAT) de la Universidad de California en Berkeley y es empleado por programas como Reaktor, Max/MSP y Csound, además de algunos controladores, incluyendo el Lemur Input Device.[118] OSC puede ser transmitido a través de conexiones Ethernet pero no es tan usado como una solución en los estudios, a la fecha carece de un apoyo general tanto por de hardware y software. El tamaño de los mensajes OSC contra los mensajes MIDI lo convierten en una solución no práctica para varios dispositivos móviles además de que sus ventajas de velocidad sobre MIDI no son perceptibles cuando transmiten los mismos datos.[119] OSC no tiene una propiedad pero no es apoyado por los estándares de alguna organización.

MIDI Inalámbrico

[editar]Han existido sistemas para la transmisión de MIDI de manera inalámbrica desde los años ochenta.[2]: 44 Varios transmisores comerciales permiten un transmisión inalámbrica de señales MIDI y OSC a través de Wi-Fi y Bluetooth.[120] Dispositivos iOS pueden funcionar como interfaz de control MIDI usando Wi-Fi y OSC.[121] Una radio XBee puede ser usado para construir un transmisor MIDI como un proyecto DIY.[122] Los dispositivos Android pueden funcionar como superficies de control a través de diferentes protocolos como Wi-Fi y Bluetooth.[123]

Versiones de MIDI

[editar]Una nueva versión de MIDI establecida, llamada de manera tentativa "Protocolo HD" o "High-Definition Protocol", fue anunciada como "HD-MIDI" en 2012.[28] Este nuevo estándar ofrece retrocompatibilidad con el MIDI 1.0 y está planeado que soporte grandes velocidades de transmisión, permitir la detección de dispositivos con solo conectarlos, enumerarlos y ofrecer un gran rango de datos y resolución. Los números de los canales y los controladores aumentaran, nuevos tipos de eventos serán agregados y los mensajes serán simplificados. Nuevo eventos serán soportados como Note Update y Direct Pitch que están enfocados a controladores de guitarra.[124][125] Las capas físicas propuestas incluyen protocolos basados en Ethernet como RTP MIDI y Audio Video Bridging.[113] El protocolo HD y un protocolo de transporte basado en User Datagram Protocol (UDP) están bajo la revisión de High-Definition Protocol Working Group (HDWG) de MMA, el cual incluye a los representantes varias compañías.[125] Prototipos de dispositivos basados en las primeras fases del protocolo han sido mostrados de manera privada en NAMM usando tanto conexiones alambicas como inalámbricas,[124] sin embargo es incierto si el protocolo será retomado por la industria.[126] En 2015, las especificaciones del protocolo HD están cerca de su finalización y MMA desarrolla las políticas de licencias y certificaciones de productos.[127] Debido a que el costo de almacenamiento de datos ha disminuido, la música MIDI se ha visto remplazada por audio comprimido en productos comerciales, haciendo nuevamente del MIDI una herramienta para la producción musical. La conectividad MIDI y un sintetizador de software aún se incluye en Windows, OS X y iOS pero no en Android.

MIDI 2.0

[editar]El 17 de enero de 2020 se presentó el estándar MIDI 2.0 en el Show NAMM de invierno en Anaheim, California, en una sesión titulada "Strategic Overview and Introduction to MIDI 2.0" realizada por representantes de Yamaha, Roli, Microsoft, Google, y la MIDI Association.[128] Esta actualización añade comunicación bidireccional y mantiene la compatibilidad con el estándar anterior.[129]

Véase también

[editar]Referencias

[editar]- ↑ Swift, Andrew. (May 1997), «A brief Introduction to MIDI», SURPRISE (Imperial College of Science Technology and Medicine), archivado desde el original el 30 de agosto de 2012, consultado el 22 de agosto de 2012.

- ↑ a b c d e f g h i j k l m n ñ o p q r s t u v w x y z aa ab ac ad ae af ag ah ai aj Huber, David Miles. "The MIDI Manual". Carmel, Indiana: SAMS, 1991.

- ↑ http://www.instructables.com/id/What-is-MIDI/

- ↑ a b Chadabe, Joel (1 de mayo de 2000). «Part IV: The Seeds of the Future». Electronic Musician (Penton Media) XVI (5). Archivado desde el original el 28 de septiembre de 2012.

- ↑ a b c d e Holmes, Thom. Electronic and Experimental Music: Pioneers in Technology and Composition. New York: Routledge, 2003

- ↑ a b c d e f g h i j k l m n ñ o p q r s t u v Manning, Peter. Electronic and Computer Music. 1985. Oxford: Oxford University Press, 1994. Print.

- ↑ http://www.grammy.com/news/technical-grammy-award-ikutaro-kakehashi-and-dave-smith

- ↑ http://www.grammy.com/videos/technical-grammy-award-recipients-ikutaro-kakehashi-and-dave-smith-at-special-merit-awards

- ↑ Paul, Craner (Oct 1991). «New Tool for an Ancient Art: The Computer and Music». Computers and the Humanities 25 (5): 308-309. JSTOR 30204425. doi:10.1007/bf00120967.

- ↑ Macan, Edward. Rocking the Classics: English Progressive Rock and the Counterculture. New York: Oxford University Press, 1997. p.191

- ↑ Shuker, Roy. Understanding Popular Music. London: Routledge, 1994. p.286

- ↑ Demorest, Steven M. Building Choral Excellence: Teaching Sight-Singing in the Choral Rehearsal. New York: Oxford University Press, 2003. p. 17

- ↑ Pertout, Andrian. Mixdown Monthly, #26. 26 June 1996. Web. 22 August 2012

- ↑ Crawford, Renee. An Australian Perspective: Technology in Secondary School Music". Journal of Historical Research in Music Education. Vol. 30, No. 2. Apr 2009. Print.

- ↑ «IKUTARO KAKEHASHI & DAVE SMITH AND ROYER LABS TO RECEIVE TECHNICAL GRAMMY® AWARD». Consultado el 20 de diciembre de 2012.

- ↑ a b Lau, Paul. "Why Still MIDI? Archivado el 2 de mayo de 2013 en Wayback Machine.." Canadian Musician. Norris-Whitney Communications Inc. 2008. HighBeam Research. 4 September 2012

- ↑ Anderton, Craig. "MIDI For Guitarists: A Crash Course In MIDI Effects Control". Sound On Sound. SOS Publications. May 1995.

- ↑ «Digital audio workstation – Intro». Archivado desde el original el 10 de enero de 2012.

- ↑ a b McCutchan, Ann. The Muse That Sings: Composers Speak about the Creative Process. New York: Oxford University Press, 1999. p. 67-68,72

- ↑ a b c Brewster, Stephen. "Nonspeech Auditory Output". The Human-Computer Interaction Handbook: Fundamentals, Evolving Technologies, and Emerging Applications. Ed. Julie A. Jacko; Andrew Sears. Mahwah: Lawrence Erlbaum Associates, 2003. p.227

- ↑ Campbell, Drew. ""Click, Click. Audio" Stage Directions. Vol. 16, No. 3. Mar 2003.

- ↑ Hass, Jeffrey. "Chapter Three: How MIDI works 10 Archivado el 7 de junio de 2015 en Wayback Machine.". Indiana University Jacobs School of Music. 2010. Web 13 August 2012

- ↑ "MIDI Files Archivado el 22 de agosto de 2012 en Wayback Machine.". midi.org Music Manufacturers Association. n.d. Web. 27 August 2012

- ↑ "RIFF-based MIDI File Format". digitalpreservation.gov. Library of Congress. 26 March 2012. Web. 18 August 2012

- ↑ a b c Crawford, Walt. "MIDI and Wave: Coping with the Language". Online. Vol. 20, No. 1. Jan/Feb 1996

- ↑ "MIDI Assoc. pushes for new licensing agreement. (MIDI Manufacturers Association)." Music Trades. Music Trades Corp. 1996. HighBeam Research. 4 September 2012

- ↑ a b Wiffen, Paul. "Synth School, Part 3: Digital Synthesis (FM, PD & VPM)". Sound on Sound Sep 1997. Print.

- ↑ a b Battino, David. "Finally: MIDI 2.0 Archivado el 3 de octubre de 2011 en Wayback Machine." O'Reilly Digital Media Blog. O'Reilly Media, Inc. 6 October 2005. Web. 22 August 2012

- ↑ Gellerman, Elizabeth. "Audio Editing SW Is Music to Multimedia Developers' Ears". Technical Horizons in Education Journal. Vol. 22, No. 2. Sep 1994

- ↑ a b c Desmond, Peter. "ICT in the Secondary Music Curriculum". Aspects of Teaching Secondary Music: Perspectives on Practice. ed. Gary Spruce. New York: RoutledgeFalmer, 2002

- ↑ Solomon, Karen. "You Gotta Feel the Music". wired.com. Condé Nast. 27 February 2000. Web. 13 August 2012.

- ↑ Inglis, Sam. "ScoreCloud Studio". Sound On Sound. SOS Publications. Jan 2015. Print.

- ↑ Cook, Janet Harniman. "Musitek Midiscan v2.51". Sound On Sound. SOS Publications. Dec 1998. Print.

- ↑ "The Social Impact of Computers- One Man's Story". computinghistory.org.uk. n.p. n.d. 1 August 2012

- ↑ Johnson, Derek. "Yamaha FS1R Editor Software". Sound on Sound. Mar 1999.

- ↑ Johnson, Derek, and Debbie Poyser. "Yamaha FS1R". Sound on Sound. Dec 1998.

- ↑ a b c Gibbs, Jonathan (Rev. by Peter Howell) "Electronic Music". Sound Recording Practice, 4th Ed. Ed. John Borwick. Oxford: Oxford University Press, 1996

- ↑ "Sound Quest MIDI Quest 11 Universal Editor". squest.com. n.p. n.d. Web. 21 August 2012

- ↑ a b "Desktop Music Handbook – MIDI Archivado el 14 de agosto de 2012 en Wayback Machine.". cakewalk.com. Cakewalk, Inc. 26 November 2010. Web. Retrieved 7 August 2012.

- ↑ Price, Simon. «Price, Simon. "Native Instruments Kore". ''Sound on Sound'' Jul 06». Soundonsound.com. Consultado el 27 de noviembre de 2012.

- ↑ a b Bozeman, William C. Educational Technology: Best Practices from America's Schools. Larchmont: Eye on Education, 1999.

- ↑ "One Man Band v11 - Live-on-stage arranger"

- ↑ "Busker - Score editor and player"

- ↑ "Jammer Professional 6". soundtrek.com. SoundTrek. 11 August 2008. Web. Retrieved 7 August 2012.

- ↑ "AthTek DigiBand 1.4". AthTek.com. AthTek. 01 May 2013.

- ↑ Lehrman, Paul D. "Software Synthesis: The Wave Of The Future?" Sound On Sound. SOS Publications. Oct 1995. Print.

- ↑ a b c Walker, Martin. "Identifying & Solving PC MIDI & Audio Timing Problems Archivado el 10 de enero de 2012 en Wayback Machine.". Sound On Sound. SOS Publications. Mar 2001. Print.

- ↑ a b Miller, Dennis. "Sound Synthesis On A Computer, Part 2". Sound On Sound. SOS Publications. May 1997. Print.

- ↑ "MIDI Ancestors and Milestones Archivado el 30 de octubre de 2012 en Wayback Machine.". keyboardmag.com. New Bay Media. n.d. Web. 6 August 2012.

- ↑ Walker, Martin. "Reality PC". Sound On Sound. SOS Publications. Nov 1997. Print.

- ↑ Wherry, Mark. "Creamware SCOPE Archivado el 25 de diciembre de 2011 en Wayback Machine.". Sound On Sound. SOS Publications. Jun 2003. Print.

- ↑ Anderton, Craig. "Sonic Core SCOPE Xite-1 Archivado el 30 de octubre de 2012 en Wayback Machine.". keyboardmag.com. New Bay Media, LLC. n.d. Web.

- ↑ David Nicholson. "HARDWARE Archivado el 2 de mayo de 2013 en Wayback Machine.." The Washington Post. Washingtonpost Newsweek Interactive. 1993. HighBeam Research. 4 September 2012

- ↑ a b Levy, David S. "Aztech's WavePower daughtercard improves FM reception. (Aztech Labs Inc.'s wavetable synthesis add-on card for Sound Blaster 16 or Sound Galaxy Pro 16 sound cards) (Hardware Review) (Evaluation). Archivado el 2 de mayo de 2013 en Wayback Machine." Computer Shopper. SX2 Media Labs LLC. 1994. HighBeam Research. 4 September 2012

- ↑ Labriola, Don. "MIDI masters: wavetable synthesis brings sonic realism to inexpensive sound cards. (review of eight Musical Instrument Digital Interface sound cards) (includes related articles about testing methodology, pitfalls of wavetable technology, future wavetable developments) (Hardware Review) (Evaluation). Archivado el 2 de mayo de 2013 en Wayback Machine." Computer Shopper. SX2 Media Labs LLC. 1994. HighBeam Research. 4 September 2012

- ↑ "Interface Circuits Archivado el 31 de mayo de 2013 en Wayback Machine.". MIDI Kits. n.p. 30 August 2012. Web. 30 August 2012.

- ↑ Lockwood, Dave. "TC Electronic G Major Archivado el 20 de marzo de 2012 en Wayback Machine.". Sound On Sound. SOS Publications. Dec 2001. Print.

- ↑ Mornington-West, Allen. "Digital Theory". Sound Recording Practice. 4th Ed. Ed. John Borwick. Oxford: Oxford University Press, 1996.

- ↑ "Richmond Sound Design – Frequently Asked Questions". richmondsounddesign.com. Web. 5 August 2012.

- ↑ a b Hass, Jeffrey. "Chapter Three: How MIDI works 2 Archivado el 17 de junio de 2015 en Wayback Machine.". Indiana University Jacobs School of Music. 2010. Web. 13 August 2012.

- ↑ Robinson, Herbie. "Re: core midi time stamping Archivado el 28 de octubre de 2012 en Wayback Machine.". Apple Coreaudio-api Mailing List. Apple, Inc. 18 July 2005. 8 August 2012.

- ↑ Shirak, Rob. "Mark of the Unicorn Archivado el 23 de marzo de 2014 en Wayback Machine.". emusician.com. New Bay Media. 1 October 2000. Web. Retrieved 8 August 2012.

- ↑ "MIDI Performance Instruments". Instruments of Change. Vol. 3, No. 1 (Winter 1999). Roland Corporation, U.S.

- ↑ "MIDI Products Archivado el 16 de julio de 2012 en Wayback Machine.". midi.org. MIDI Manufacturers Association. n.d. 1 August 1012

- ↑ «The beginner's guide to: MIDI controllers». Computer Music Specials. Consultado el 11 de julio de 2011.

- ↑ "Rhodes Mark 7 Archivado el 13 de julio de 2015 en Wayback Machine.". keyboardmag.com. New Bay Media, LLC. n.d. Web. Retrieved 7 August 2012.

- ↑ White, Paul. "Yamaha WX5". Sound On Sound. SOS Publications. Jul 1998. Print.

- ↑ «"Marimba Lumina Described". ''buchla.com''. n.p. n.d. Web». Buchla.com. Archivado desde el original el 1 de noviembre de 2012. Consultado el 27 de noviembre de 2012.

- ↑ White, Paul. "DIY Drum Pads And Pedal Triggers". Sound On Sound SOS Publications. Aug 1995. Print.

- ↑ Batcho, Jim. "Best of Both Worlds". Strings 17.4 (2002): n.a. Print.

- ↑ Price, Simon. "Allen & Heath Xone 3D". Sound On Sound. SOS Publications. Sep 2006. Print.

- ↑ Beilharz, Kirsty. Wireless gesture controllers to affect information sonification.

- ↑ Pinkston; Kerkhoff; McQuilken (10 de agosto de 2012). The U. T. Touch-Sensitive Dance Floor and MIDI Controller. The University of Texas at Austin.

- ↑ Cooper, Douglas. "Very Nervous System". Wired. Condé Nast. 3.03: Mar 1995.

- ↑ "The Glimpse". midiinmotion.fschwehn.com. n.p. n.d. Web. 20 August 2012

- ↑ «"Buchla Thunder". ''buchla.com''. Buchla and Associates. n.d. Web». Buchla.com. Archivado desde el original el 1 de noviembre de 2012. Consultado el 27 de noviembre de 2012.

- ↑ "MIDI Products Archivado el 16 de julio de 2012 en Wayback Machine.". midi.org. The MIDI Manufacturers Association. n.d. Web. 10 August 2012.

- ↑ «"Note pattern". ''theshapeofmusic.com''. n.p. n.d. Web. 10 Aug 2012». Theshapeofmusic.com. Archivado desde el original el 19 de febrero de 2012. Consultado el 27 de noviembre de 2012.

- ↑ «"Overview". ''hakenaudio.com''. Haken Audio. n.d. Web. 10 Aug 2012». Hakenaudio.com. Archivado desde el original el 17 de julio de 2012. Consultado el 27 de noviembre de 2012.

- ↑ Gamboa, Glenn. "MIDI Ironing Boards, Theremin Crutches Squeal at Handmade Music Event". Wired.com. Condé Nast. 27 September 2007. 13 August 2012. Web.

- ↑ "MIDI Products Archivado el 16 de julio de 2012 en Wayback Machine.". midi.org. MIDI Manufacturers Association. n.d. 13 August 2012. Web.

- ↑ Preve, Francis. "Dave Smith", in "The 1st Annual Keyboard Hall of Fame". Keyboard (US). NewBay Media, LLC. Sep 2012. Print. p.18

- ↑ "Korg Legacy Collection". vintagesynth.com. Vintage Synth Explorer. n.d. Web. 21 August 2012

- ↑ a b Walker, Martin. "Controlling Influence Archivado el 10 de enero de 2012 en Wayback Machine.". Sound On Sound. SOS Publications. Oct 2001. Print.

- ↑ «"Drawbar Manual v. 1.2". Voce, Inc. n.d. Web. 10 Aug 2012». Voceinc.com. Archivado desde el original el 5 de abril de 2013. Consultado el 27 de noviembre de 2012.

- ↑ Hass, Jeffrey. "Chapter Three: How MIDI works 3 Archivado el 19 de junio de 2015 en Wayback Machine.". Indiana University Jacobs School of Music. 2010. Web. 13 August 2012.

- ↑ «SysEx: Flexibilidad MIDI».

- ↑ Hass, Jeffrey. "Chapter Three: How MIDI works 9 Archivado el 7 de junio de 2015 en Wayback Machine.". Indiana University Jacobs School of Music. 2010. Web. 13 August 2012.

- ↑ a b c Bello, Juan P. "MIDI: sound control". nyu.edu. New York University. n.d. Web. 18 August 2012

- ↑ «"General MIDI Standard". ''www.harfesoft.de''. n.p. n.d. Web». Harfesoft.de. Consultado el 27 de noviembre de 2012.

- ↑ "General MIDI Standard". pgcc.edu. Prince George's Community College. n.d. Web.

- ↑ Glatt, Jeff. "General MIDI Archivado el 23 de octubre de 2012 en Wayback Machine.". The MIDI Technical Fanatic's Brainwashing Center. n.p. n.d. Web. 17 August 2012

- ↑ Nagle, Paul. "Yamaha MU50 & Yamaha CBX-K1". Sound On Sound. SOS Publications. Sep 1995. Print.

- ↑ "About General MIDI Archivado el 3 de enero de 2012 en Wayback Machine.". midi.org. MIDI Manufacturers Association. n.d. Web. 17 August 2012

- ↑ a b "The MIDI Tuning Standard". microtonal-synthesis.com. n.p. n.d. Web. 17 August 2012

- ↑ "MIDI Tuning Archivado el 30 de noviembre de 2012 en Wayback Machine.". midi.org. MIDI Manufacturers Association. n.d. Web. 17 August 2012