openstack+cephインテグレーション

- 1. Openstack+Cephインテグレーション のご紹介 Icehouse/Firefly版 2014/7/16 Open Programmable Infrastructure Environment 14/07/16 Copyright 2014(C) OSS Laboratories Inc. All Rights Reserved 1

- 2. Ceph の特徴 l 分散ストレージ l ベンダフリー l 汎⽤用PCサーバ/汎⽤用OS(Linux)を使⽤用 l 特別なハードウェア不要 l オープンソース l フォールトトレラント、No SPOF l PB以上のスケールアウト l 汎⽤用プロトコル l POSIXファイルシステム l ブロックデバイス l REST(AWS S3/SWIFT互換) l WAN越しリモートレプリケーション(RGWのみ) l RW同期(LANのみ) l Strong Consistency 214/07/16 Copyright 2014(C) OSS Laboratories Inc. All Rights Reserved

- 3. RADOS Reliable, Autonomous, Distributed Object Store ブロック デバイス MDSMonitors OSDs Cephのアーキテクチャ 3 CephFS POSIX互換ファイ ルシステム Kernel-client及び FUSE-clientから 使⽤用できる Librados C, C++, java, Python, Ruby, PHP からRADOSに アクセスできるAPI ライブラリ RADOSGW (RADOS Gateway) AWS S3及び OpenStack SWIFT互換の REST APIを提供 するhttpプロキシ RBD (RADOS Block Device) Linuxカーネルか らRADOSをブロッ クデバイスとして 使⽤用できる API Kernel Client ノード ブロック デバイス vfs ブロックデバイ スドライバ MDSMonitors OSDs MDSMonitors OSDs API librbd Kernel Client FUSE Client Ext4/xfs/btrfs ブロック デバイス ノード ブロック デバイス vfs ブロックデバイ スドライバ Ext4/xfs/btrfs

- 4. 従来型ストレージとの違い 14/07/16 Copyright 2014(C) OSS Laboratories Inc. All Rights Reserved 4 Hypervisor V M ⾼高価 V M V M RAID ストレージ Hypervisor V M V M V M RAID ストレージ FC SAN 筐体障害対応には ⼆二重化必要 スケールアップ 拡張に1ヶ⽉月? Hypervisor V M 安価 V M V M 汎⽤用サーバ Linux Hypervisor V M V M V M 汎⽤用サーバ Linux 筐体障害対応は、不要 (最低3台以上) スケールアウト 追加に数分 TCP/IP TCPが通れば 良い ローリング アップグレード 無停⽌止保守 FWアップ グレード時 停⽌止 従来型ストレージ Cephストレージ

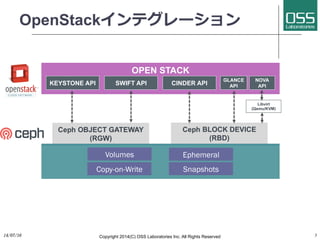

- 5. OpenStackインテグレーション 14/07/16 Copyright 2014(C) OSS Laboratories Inc. All Rights Reserved 5 Volumes Ephemeral Copy-on-Write Snapshots

- 6. Cinder/Nova連携 RBD Cinder Server Libvirt (QEMU/KVM) VM Boot from volume ボリューム作成/接続 Volume Image Copy-on-write clone librbd Nova/compute VM Libvirt (QEMU/KVM) VM librbd VM ライブマイグレーション

- 7. Ceph COW clone l COW:Copy-on-write l ⾼高速なボリューム作成、低容量消費 14/07/16 Copyright 2014(C) OSS Laboratories Inc. All Rights Reserved 7 クライアント WRITE READ

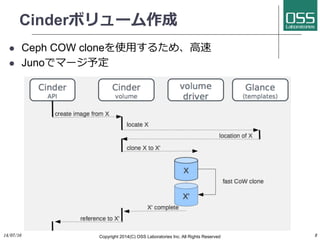

- 8. Cinderボリューム作成 l Ceph COW cloneを使⽤用するため、⾼高速 l Junoでマージ予定 14/07/16 Copyright 2014(C) OSS Laboratories Inc. All Rights Reserved 8

- 9. Cinder snapshot/backup on Ceph l CephのRBD Snapshotを使⽤用 l RBD snapshotは、読み込み専⽤用 l Snapshotから、ブート可能なボリュームを作成(COW clone) l Cinder backup on Ceph l 差分バックアップサポート(Ceph RBD snapshot) l 異なるPG(ラック/ゾーン)を指定 14/07/16 Copyright 2014(C) OSS Laboratories Inc. All Rights Reserved 9

- 11. SWIFT/Keystone連携 Keystone Server RADOSGW RESTful Object Store Query token Access with token Grant/revoke SWIFTのバックエンドとしてCeph RADOS GWを使⽤用

- 12. OpenstackでのCeph使いどころ 14/07/17 Copyright 2014(C) OSS Laboratories Inc. All Rights Reserved 12 l コントローラノード l RBDカーネルクライアントを使⽤用し、 下記ファイルをCeph上にマウント l データベースファイル l 各種テンポラリファイル l 各種設定ファイル l ログ l Cinder/Glance l 各コンピュートノードにlibrbdを設定 し、イメージ、ボリュームとして使⽤用 する l Swift l RADOS GWを使⽤用し、バックアップ 置き場とする コントローラ 10gb Public 管理 ストレージ Ceph 同期 コントローラ Ceph ネットワーク Ceph ネットワーク コンピュート HA Proxy HA Proxy外部 NW プロダクション構成例 10gb

- 13. OpenStack+Cephのメリット l OpenStack 全体の可⽤用性の向上 l MySQL のデータさえダンプ取得すれば、 リストア可能 l OS イメージ・スナップショットは Ceph 上にあ るのでバックアップ不要 l Compute ノード上のインスタンスデータは Ceph のスナップショットから復旧 l Network ノードは分散・冗⻑⾧長可能、データのバッ クアップは不要 l 最⼩小構成(3ノード)から始めて、スケールアウ ト可能 14/07/16 Copyright 2014(C) OSS Laboratories Inc. All Rights Reserved 13

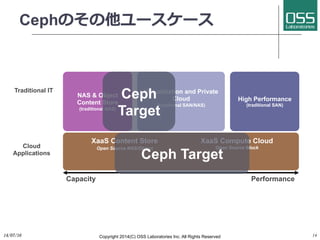

- 14. Cephのその他ユースケース 14/07/16 Copyright 2014(C) OSS Laboratories Inc. All Rights Reserved 14 Virtualization and Private Cloud (traditional SAN/NAS) High Performance (traditional SAN) PerformanceCapacity NAS & Object Content Store (traditional NAS) Cloud Applications Traditional IT XaaS Compute Cloud Open Source Block XaaS Content Store Open Source NAS/Object Ceph Target Ceph Target

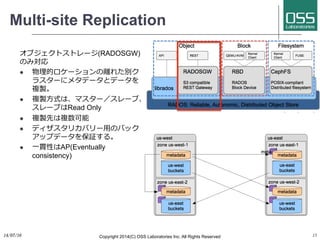

- 15. Multi-site Replication オブジェクトストレージ(RADOSGW) のみ対応 l 物理的ロケーションの離れた別ク ラスターにメタデータとデータを 複製。 l 複製⽅方式は、マスター/スレーブ、 スレーブはRead Only l 複製先は複数可能 l ディザスタリカバリー⽤用のバック アップデータを保証する。 l ⼀一貫性はAP(Eventually consistency) 1514/07/16 Copyright 2014(C) OSS Laboratories Inc. All Rights Reserved

- 16. Erasure coding(イレージャーコーディング) l Erasure Coding:定訳はないが、「消失符号」あるいは「消失訂正符号」という訳語も⼀一 部で使われている。 l オブジェクトを分割して消失訂正符号を付加し、物理的に異なるノードに分散して格納す ることで、その分割したデータのいくつかが消失した場合でも、元のオブジェクトを復元 することができる⼿手法で、マイクロソフトのAzureストレージにも採⽤用されている技術。 l 実装の仕組みは複数のアルゴリズムが⽤用意されているが、⼀一般的にオブジェクトの容量に 対して20% 40%程度の符号を付加すれば良いことから、レプリケーション(複製)に⽐比 べ物理的なディスクの利⽤用効率(実効容量)が⾼高い。 l ただし、オブジェクトの書き込みの都度、符号化処理を⾏行行うので、パフォーマンスが劣化 する可能性があり、ディスクの利⽤用効率を優先する⼤大規模案件やパフォーマンスを要求し ないアーカイブ⽤用途などに適している。 Erasure Coding レプリケーション 利用効率(2ディスク障害で の保証) 約140% 200% CPU使用率 High Low 読み書き速度 遅い 速い

- 17. キャッシュ・ティアリング CEPH STORAGE CLUSTER Write ReadRead/Write SSD HDD

- 18. 参考情報 14/07/16 Copyright 2014(C) OSS Laboratories Inc. All Rights Reserved 18 http://www.mellanox.com/related-docs/whitepapers/ WP_Deploying_Ceph_over_High_Performance_Networks.pdf

- 19. 参考情報 14/07/16 Copyright 2014(C) OSS Laboratories Inc. All Rights Reserved 19 2,419MB/sec (8M Seq. READ) 110k IOPS (4k Seq. READ)

- 20. ⽇日本Cephユーザー会 l https://groups.google.com/forum/#!forum/ceph-jp l 普通にGoogleで検索しても出てこないので l Google Groupの中で検索して下さい。 14/07/16 Copyright 2014(C) OSS Laboratories Inc. All Rights Reserved 20