はじめに この記事では今回開発したWebアプリ、自閉症識別(後に理由を説明しますが、動作が大変モッサリです)を公開するまでの経緯や考え・思いをまとめた。 6月中旬に差し掛かる頃から、Aidemy PewmiumのAIアプリ開発コースで、Pythonを用いてアプリ開発を行えるようになることを目標に学んできた。その成果として開発したのが、顔写真から自閉症を判別するWebアプリだ。 この記事では私自身がプログラミング超初心者として、そしていち支援者として感じたことも多く綴っているため、必要に応じて適宜読み飛ばしてもらえると良いかもしれない。 開発開始に至るまで 私はこちらの記事にあるように、保育士として児童発達支援に関わってきた。大変ではあるが非常に楽しい仕事だった。とはいえAidemyの講座受講中、成果物を何にするかをずっと考えていたが、この領域で何かやろうなんてことは全く考えていなかった。

絞り込み

-

検索対象

-

ブックマーク数

-

期間

-

セーフサーチ

データセットの検索結果1 - 40 件 / 69件

-

個人用メモです。 機械学習は素材集めがとても大変です。 でもこの素材集め、実は無理してやらなくても、元から良質な無料データベースがあったようなのです。 URLはこちら YouTube8-M https://research.google.com/youtube8m/explore.html 提供されているサービスは以下の通り 800万個の動画 19億個のフレーム 4800個の分類 使い方はExploreから画像セットを探し、ダウンロードするだけ。 他の方法も見つけた open images dataset 「すごい神だな」と思ったのは これもう完成されてますよね もちろんこの認識前の画像もセットでダウンロードできます。 Youtube-8Mとは、画像数を取るか、精度で取るか、という違いでしょうか。 他にも良い素材集を教えていただきました (はてなブックマーク情報 @sek_165 さん )

-

2022年04月25日 NDLラボのGitHubから、次の2件を公開しました。ライセンスや詳細については、各リポジトリのREADMEをご参照ください。 NDLOCR 国立国会図書館(以下、「当館」とします。)が令和3年度に株式会社モルフォAIソリューションズに委託して実施したOCR処理プログラムの研究開発事業の成果である、日本語のOCR処理プログラムです。 このプログラムは、国立国会図書館がCC BY 4.0ライセンスで公開するものです。なお、既存のライブラリ等を利用している部分については寛容型オープンライセンスのものを採用しているため、商用非商用を問わず自由な改変、利用が可能です。 機能ごとに7つのリポジトリに分かれていますが、下記リポジトリの手順に従うことで、Dockerコンテナとして構築・利用することができます。 リポジトリ : https://github.com/ndl-lab/

-

どうもこんにちは。最近、大規模言語モデル(LLM)の個人開発に取り組んでいる@kun1em0nと申します。この度、最近話題のChatGPTの最新モデルGPT-4を無料で使用できるアプリを作成したので公開いたします。今回アプリを無料で公開する意図についてこの記事で説明したいと思います。 Japanese-Alpaca-LoRAの作成前回の記事ではスタンフォード大学が作成したStanford Alpacaの日本語対応モデル Japanese-Alpaca-LoRAを作成し公開した話を紹介しました。 このモデルの作成に使ったデータの大元(Alpacaデータ)はText-davinci-003というOpenAIサービスで出力した結果になりますが、OpenAIの利用規約ではコンテンツ生成者はOpenAIサービスで出力した結果を競合モデルの開発用途に使用してはならないと記載されています。ただ、コンテン

-

言語モデルのChatGPTや画像生成AIのDALL·Eを手がけるAI研究所のOpenAIは、AI技術の悪用を防ぎ社会に友好的な形で発展させることを目的に、サム・アルトマン氏やイーロン・マスク氏らが2015年に発足させた非営利組織です。そんなOpenAIの創始メンバーに名を連ねるイルヤ・サツキヴァー氏が、AIをオープンにするという設立当初の理念は誤りだったと、IT系ニュースサイト・The Vergeのインタビューの中で語りました。 OpenAI co-founder on company’s past approach to openly sharing research: ‘We were wrong’ - The Verge https://www.theverge.com/2023/3/15/23640180/openai-gpt-4-launch-closed-research-il

-

Stable Diffusionを「いらすとや」で追加学習する - TadaoYamaokaの開発日記

- 263 users

- tadaoyamaoka.hatenablog.com

- テクノロジー

- 2022/09/18

前回、Stable Diffusionをdanbooruデータセットを使用して追加学習することを試した。 今回は、自分でデータセットを作成して追加学習することを試す。 データセットには、画像とキャプションが揃っている必要があり、キャプションがない場合はCLIPで疑似ラベルを生成するなどする必要がある。 今回は、画像に対するキャプションがある「いらすとや」をスクレイピングして、データセットを作成した。 データセット作成 「いらすとや」から全ての画像とキャプションを取得した。 画像に複数バリエーションがある場合は、1つ目の画像のみを使用した。 キャプションは、日本語になっているため、Googleスレッドシートで、「=GOOGLETRANSLATE(XX,"ja","en")」を使って英語に変換を行った。 合計で、22891枚の画像とキャプションのセットが用意できた。 画像サイズ変換 画像は、5

-

PythonでTableau風 BIツールによる視覚的データ探索をやってみよう 〜PyGWalker〜 - Qiita

- 259 users

- qiita.com/hima2b4

- テクノロジー

- 2023/02/24

更新情報 -目次- はやくもUI改善等 Ver.upが図られています。以下内容の記事を追加しました。 1. データフレーム表示 2. ヒストグラムの描き方 3. ダークモード対応 4. オンライン版 5. 海外のデータイノベーション支援団体でも人気 はじめに Tableauはご存じでしょうか? 私は使ったことはありませんが、名前だけはよく耳にします。 これは、専門家でなくてもデータの収集・分析・加工ができるBI(ビジネス・インテリジェンス)ツールのひとつです。 なんと、Jupyter Notebook上(Google ColabもOK)で実行できる Tableau風 BIツール「PyGWalker」が登場しました。 Tableauそのものではありませんが、ドラッグ&ドロップの簡単な操作でデータ分析や視覚的な探索が実行できます。 こんなのが出てくるとは・・・すごい。 しかも、数行のコードで実

-

【📩 仕事の相談はこちら 📩】 お仕事の相談のある方は、下記のフォームよりお気軽にご相談ください。 https://forms.gle/G5g1SJ7BBZw7oXYA7 もしもメールでの問い合わせの方がよろしければ、下記のメールアドレスへご連絡ください。 info*galirage.com(*を@に変えてご送付ください) 🎁 「生成AIの社内ガイドライン」PDFを『公式LINE』で配布中 🎁 「LINEで相談したい方」や「お問い合わせを検討中の方」は、公式LINEでご連絡いただけますと幸いです。 (期間限定で配信中なため、ご興味ある方は、今のうちに受け取りいただけたらと思います^^) https://lin.ee/3zRuqKe おまけ①:生成AIアカデミー より専門的な「生成AIエンジニア人材」を目指しませんか? そんな方々に向けて、「生成AIアカデミー(旧:生成AIエンジニア

-

最近の自然言語処理では、大規模なテキストから単語の分散表現や言語モデルを学習させて使っています。学習する際のテキストとしては、分量や利用しやすさの都合からWikipediaが選ばれることが多いですが、その前処理は意外と面倒で時間のかかる作業です。そこで、本記事では比較的最近リリースされた前処理済みのデータセット「Wiki-40B」とその使い方を紹介します。 Wiki-40Bとは? Wiki-40Bは、40言語以上のWikipediaを前処理して作られたデータセットです。このデータセットは言語ごとに学習/検証/テスト用に分かれているので、単語分散表現や言語モデルの学習・評価に使えます。言語ごとの対応状況については、以下のページを参照するとよいでしょう。 wiki40b | TensorFlow Datasets 前処理としては、大きくは以下の2つに分けられます。 ページのフィルタリング ペー

-

何をした? Youtube上に公開されている動画の音声から、ディープラーニング技術を用いた音声合成ツールを構築しました。 今回対象にしたのは、バーチャルユーチューバー・にじさんじの委員長こと 月ノ美兎 さん(Youtubeチャンネル) です。 ※選出理由は、単純に私がYoutube上で一番推している方だからです。 成果 動画から抽出した音声と、音声を文章に起こしたテキストの組み合わせのデータセット約50分ぶんを教師データとして学習した結果 ※学習に必要なデータ量は最低でも1時間程度と言われているので、まだまだ足りていません… 月ノ美兎さんの音声合成ツールを作ってみた https://t.co/YVdWW9vREb via @YouTube — K2 (@K2ML2) May 29, 2020 発話内容が不明瞭な箇所がありますが、一応ご本人の声に近い音声を作成することができているかと思います

-

地名項目の位置情報(緯度経度)の推定については、精度を改善する余地が大きいため、今後も各種資料を精査しながら精度を向上させていきます。現状では、地図上のマーカーの位置が最適でない場合もあるかと思いますが、今後さまざまな精度向上の取り組みを進めていく予定です。 都道府県 一覧 合計 80502 件 検索 歴史的地名/現代地名による統合検索では、現代および歴史的な市区町村名や現代の町丁・字名による検索が可能です。 地名(の一部)を入力: 概要 『日本歴史地名大系』地名項目データセットとは、ジャパンナレッジ版『日本歴史地名大系』(平凡社)の中から、行政地名に関連する地名項目をまとめたデータセットです。2023年11月現在、地名項目=80,502件を提供しています。 出典 『日本歴史地名大系』地名項目データセット

-

次回の更新記事:LLMは個人の金銭管理を適切にサポートできるのか?(公開予定日:2025年01月06日) OpenAIは新しいフレームワーク「PRM」を発表しました。これは、大規模言語モデル(LLM)の数学能力を向上させるためのもので、AIが問題を解く際の誤りをプロセスベースで特定・修正する能力を強化します。このフレームワークで訓練した大規模言語モデルは、DeepMind社の作成した数学問題集(MTAHデータセット)において他のモデルを凌駕し最も優れたパフォーマンスを見せました。 また、この手法は数学だけでなく推論能力を必要とする広範な問題の解決にも応用できる可能性があり、注目を集めています。 参照論文情報 タイトル:Let’s Verify Step by Step 著者:Hunter Lightman, Vineet Kosaraju, Yura Burda, Harri Edward

-

最終更新日: 2020年3月4日 AIの高まりとともにデータの大切さが再認識される今、オープンにさまざまなデータが公開され、気軽に活用できるようになっています。 オープンデータの存在は、膨大なデータから学習を行う機械学習にとって不可欠で、構築したいAIに合わせてオープンデータを選択し、活用することが必要です。 一方、オープンデータのみでは競合優位性のあるAIは構築できません。マクロなオープンデータと、独自に収集したミクロなデータを組み合わせて、独自のAIを構築していくことが重要です。 オープンデータを活用したサービスを構築する際には、サービスのUX(ユーザー体験)を高め、いかにユニークなデータを取得できるかが勝負なのでオープンデータに頼りすぎないようにしましょう。 今回、オープンデータ・データセットを6カテゴリに分類し、100個選出しました。自身のサービスやAIの構築に活かせそうなデータを

-

StableLMのファインチューニングってできるのかな?と調べたところ、GitHubのIssueで「モデル自体の性能がまだ良くないから、ファインチューニングの段階ではないよ」というコメントがありまして。 シートの中身を見てみるlm-evalシートstablelm-base-alpha-7bは54行目にありまして、確かに他の言語モデルと比較するとまだまだな性能のようです。応援したいですね。 シートの列の意味それぞれの列の意味については推定ですが以下の通りです。 RAM 言語モデルのGPUメモリ消費量。 lambada(ppl) LAMBADAデータセットによる測定値。ロングレンジの言語理解能力をテストする(文章全体を読まないと答えられないタスクでの評価)。PPLはPerplexityという指標で、モデルの予測の不確かさを示す。PPLが低いほど、モデルの予測精度が高い。 lambada(acc

-

-

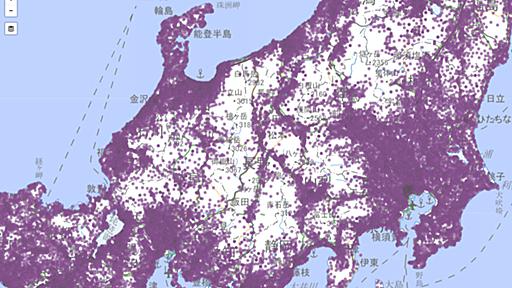

Googleが世界の各地で「不要不急の外出がどれだけ控えられているか」が一目でわかるレポートを公開、日本の各都道府県のデータもチェック可能

- 84 users

- gigazine.net

- テクノロジー

- 2020/04/06

新型コロナウイルス感染症(COVID-19)が流行している国や地域では、不要不急の外出を控える動きが強まっています。そのような動きが実際にどれほどの規模に達しているのか、Googleが「世界各地の小売店・スーパーマーケット・公園・駅・職場・自宅にいる人がどれだけ増減したか」がわかる詳細なレポートを公開しています。 COVID-19 Community Mobility Reports https://www.google.com/covid19/mobility/ Googleが公開したデータは、Googleのスマートフォン向けアプリで「ロケーション履歴」をONにしているアカウントの情報に基づいています。Googleマップなどを利用するユーザーは世界中に何億人もいるため、そのユーザーの一部しかロケーション履歴をONにしていなかったとしても得られるデータは膨大です。なお、収集されたデータはG

-

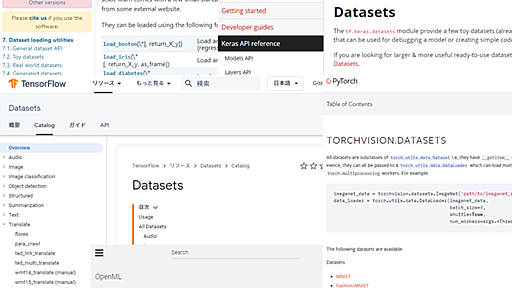

PyTorch/TensorFlow/Keras/scikit-learnライブラリ内蔵のデータセット一覧

- 84 users

- atmarkit.itmedia.co.jp

- テクノロジー

- 2020/07/22

PyTorch/TensorFlow/Keras/scikit-learnライブラリ内蔵のデータセット一覧:AI・機械学習のデータセット辞典 機械学習やディープラーニング用の主要ライブラリが提供する「画像/音声/テキストなどのデータセット」の名前とリンクを表にまとめ、典型的な使い方を簡単に紹介する。 連載目次 本連載「AI・機械学習のデータセット辞典」では、ここまで主に、scikit-learnやKeras/TensorFlow(tf.keras)、TensorFlow Datasets、PyTorchといった主要なPythonライブラリに共通的に含まれる代表的なデータセットを紹介し、各ライブラリでの典型的な実装コード例を示してきた。しかし、これらの全ライブラリに共通的に含まれているデータセットはまれで非常に少ない。よってこれからは、個々のライブラリに1つしか含まれていないようなこまごまと

-

AI活用のコンサルティング事業を手掛けるAPTO(東京都渋谷区)とエイアイ・フィールド(東京都品川区)は10月5日、AIの学習データとして利用できる、実在しない男女の顔写真3000枚の無償配布を始めた。法人を対象に11月30日までの期間限定で提供し、商用利用も認める。「AI市場の加速に貢献できれば」(2社)という。 エイアイ・フィールドが自社の技術で自動生成した、実在しない10代~90代の男女の画像を提供。APTOが作成した年齢・性別などのアノテーション(画像を説明するテキスト情報)も付属する。申し込みは専用サイトで受け付ける。 もともとはエイアイ・フィールドが自社サービスで活用するために作成した画像だったが、6月に用途を研究目的に限った上で1000点を無料配布したところ、利用者からの反響があったことから、データを2000点追加し、商用利用を認めた上で再配布することを決めたという。 関連記

-

ReazonSpeech¶ ReazonSpeechは、世界最大のオープン日本語音声コーパスを構築するプロジェクトです。 日本語音声技術の推進を目的として、35,000時間の日本語音声コーパスを公開しています。 音声認識モデル・コーパス作成ライブラリをオープンソースライセンスで配布しています。

-

日本の政府系のオープンデータで一番有名なのが「e-Stat」である。統計学やデータサイエンスに携わるもの/学ぶものであれば、名前は聞いたことがあるだろう。かつては各省庁がバラバラに管理&公開していた公的データを、一カ所に集めて誰でも簡単に利用できるようにしたサイトである(2008年から運用が開始され、2018年にリニューアルされた)。 統計分野は多岐にわたり、「国土・気象」「人口・世帯」「労働・賃金」「農林水産業」「鉱工業」「商業・サービス業」「企業・家計・経済」「住宅・土地・建設」「エネルギー・水」「運輸・観光」「情報通信・科学技術」「教育・文化・スポーツ・生活」「行財政」「司法・安全・環境」「社会保障・衛生」「国際」「その他」という17分野が提供されている。データセットは、条件指定によるフィルタリングやグラフ化が行える。例えば人口ピラミッドのグラフも簡単に作成できる。 また、もちろん無

-

Wikipediaを元にした日本語の名寄せデータセットを作成しました - Sansan Tech Blog

- 62 users

- buildersbox.corp-sansan.com

- テクノロジー

- 2020/03/10

こんにちは、DSOC 研究開発部の奥田です。以前の私のブログ記事ではコーギーの動画を見ていると書きましたが、とうとうコーギーを家族として迎え入れ、現在生後6ヶ月の子犬と暮らしております。 さて私たちDSOCでは、SansanやEightの価値を高めるために様々な自然言語処理のタスクに取り組んでおります。例えばニュース記事からの固有表現抽出では、私たちのサービスに特化した固有表現を対象に研究開発しています。その他にも様々あるなかで、特に重要かつ困難とされているものの一つに「名寄せ」というタスクがあります。AIや人工知能と呼ばれるものが発達した現代においても、人間には当たり前にできるタスクが機械には難しいことがまだまだ存在します。 今回は、その「名寄せ」というタスクにおける日本語でのデータセットを作成してみました。これをきっかけに、日本語での名寄せというタスクの研究が進み分野が活性化することを

-

Deleted articles cannot be recovered. Draft of this article would be also deleted. Are you sure you want to delete this article? オミータです。ツイッターで人工知能のことや他媒体で書いている記事など を紹介していますので、人工知能のことをもっと知りたい方などは気軽に@omiita_atiimoをフォローしてください! 画像認識の定番データセットImageNetはもう終わりか 2012年にAlexNet[Krizhevsky, A.(2012)]が登場してから、画像認識分野での発展は著しい。その発展を支えてきたものこそ大規模データセットImageNet[Deng, J.(2009)]である。ImageNetでSoTAを達成すると、そのモデルには最強モデルの称号が与え

-

トップカンファレンスにおけるデータセットシフトと機械学習 - Ridge-institute R&D Blog

- 51 users

- iblog.ridge-i.com

- テクノロジー

- 2021/03/10

こんにちは,株式会社Ridge-iのリサーチチームの@machinery81です. 今回はNeurIPS2020で発表されたデータセットシフトを扱う機械学習に関連する論文を紹介します. 本記事は,Ridge-i主催の論文読み会で発表した以下の資料に基づいています. TL;DR 機械学習におけるデータセットシフト Covariate Shift Target Shift Concept Shift Domain Shift Sample Selection Bias Taxonomy of NeurIPS2020 papers about Dataset Shift 論文紹介 Rethinking Importance Weighting for Deep Learning under Distribution Shift Importance Weighting for Distribut

-

-

-

Deleted articles cannot be recovered. Draft of this article would be also deleted. Are you sure you want to delete this article? (DCASEホームページより) はじめに 音を題材とした異常検知のデータセットによる機械学習コンペが始まりました。 音に関するコンペ自体が珍しいなか、タスクとして一般的な分類などでもなく、更に難しい異常検知が設定されました。 個人的に2019年に画像の異常検知に積極的に取り組んだのですが、音声は周波数領域に変換すると画像のように取り扱えることから、チャレンジしたい題材でした。下記は画像にチャレンジしたときの記事です。 欠陥発見! MVTec異常検知データセットへの深層距離学習(Deep Metric Learning)応用 深層距離学習

-

人口や労働・賃金、農林水産、土地・建物、運輸・観光、教育など、政府機関が調査した統計をもとにデータ分析を進めていきたい場合もあるだろう。このような場合に活用できるのが「e-Stat」だ。今回は「e-Stat」からデータを抽出してダウンロードする方法を紹介していこう。 データのダウンロード 「e-Stat」とは、政府機関が調査した統計データを公開しているWebサイトのことだ。何らかの統計データをキーワードで検索したときに、このWebサイト内にあるページにたどり着くケースも少なくないので、この機会に使い方を学んでおくとよいだろう。 参考までに「e-Stat」のトップページを紹介しておこう。この画面の右上には「ログイン」ボタンが用意されているが、会員登録しなくても誰でも利用することが可能である。 「e-Stat」のトップページ カテゴリやキーワードなどで統計情報を絞り込んでいくと、データをダウン

-

概要 GSIデータセット(愛称。正式名称は「CNNによる地物抽出用教師データセット」。以下、「本データセット」といいます)は、地上画素寸法20cm級の空中写真画像を対象として、画像内に写っている地物の範囲を、セマンティックセグメンテーションという手法で抽出する際に用いる機械学習用のデータセットです。道路や建物といった、多くの研究で取り組まれている主要な地物だけでなく、高塔や水制といったマイナーな地物や、広葉樹林や針葉樹林などの自然植生、水田や畑などの既耕地も対象としています。 本データセットは、国土地理院の特別研究「AIを活用した地物自動抽出に関する研究(平成30年度~令和4年度)」の研究成果として作成されたものです。このデータセットを使って学習させたモデルによる地物抽出性能が一定以上(抽出性能の評価に用いられる一般的な指標の一つであるF値という値が0.600以上となったもの。:当初はF≧

-

e-Statでは政府が提供する様々な統計データをXMLやJSONで取得するAPIを使用できます。 ##APIの利用登録と動作テスト 1.下記のURLからAPIの利用申請をします。 http://www.e-stat.go.jp/api/regist-login/ 2.APIを登録申請が完了すると「メールアドレス」と「パスワード」でログインが可能になります。 3.ログイン後、再度ログイン画面に行くと「利用者情報変更/削除」と「アプリケーションIDの取得」がおこなえる画面が表示されます。 利用者情報変更では、登録時に指定したデータを変更することができます。 4.appIDの発行を行う。 「アプリケーションIDの取得」画面で名称とURLを入力して、「発行」ボタンを押すとappIDが取得できます。 urlは存在しない場合は「http://localhost/」等を入力してください。 appIDは3

-

-

-

LLM のデータセットまとめ|npaka

- 35 users

- note.com/npaka

- テクノロジー

- 2023/04/03

LLMのデータセットをまとめました。 1. 事前学習データセット1-1. Text・Wikipedia (ja) ・fujiki/wiki40b_ja ・llm-jp-corpus-v2 (ja) ・llm-jp-corpus-v2 ・shisa-pretrain-en-ja-v1 (ja) ・augmxnt/shisa-pretrain-en-ja-v1 ・youlery (ja) ・ce-lery/mistral-3b-dataset ・ayousanz/OSCOR-2301-ja-cleaned ・ayousanz/c4-ja-cleaned ・Common Crawl (multilingual) ・Wikipedia (en) ・Wiki Demo (en) ・RefinedWeb (en) ・RedPajama V2 (en) ・Pile (en) ・SkyPile (zh)

-

顔コレデータセット | 顔貌コレクション(顔コレ)

- 34 users

- codh.rois.ac.jp

- テクノロジー

- 2020/02/21

顔コレデータセット(KaoKore Dataset)は、日本の絵巻物や絵本に登場する様々な顔貌画像「顔コレ(顔貌コレクション)」を、機械学習に利用しやすい形式で提供するデータセットです。データセットをご利用の際には、引用、ライセンス、利用ガイドラインなどをご確認ください。 顔コレデータセットは、複数の組織がIIIF (International Image Interoperability Framework)形式で公開する絵巻物・絵本に登場する様々な顔貌画像の所在情報とメタデータをまとめたものです。 2022年5月現在、最新バージョン(v1.3)のデータセットは、9,683件の顔貌データを提供します。データセットの内容は以下の通りです。 顔貌画像(画素:256×256)の所在情報(URL)をまとめたテキストファイル 専門家が付与した属性情報(メタデータ)をまとめたテキストファイル 機械学

-

Dataset Searchは、2018年9月からグーグル(Google)が提供しているサイトの一つで、世界中からデータセットを検索できる(=ググれる)。「機械学習で利用するデータセットを手軽に探したい」という場合に、最初に実行してみるツールとして非常に有用である。通常のGoogle検索では、例えば「PyTorch cats dogs images classification」などのようなキーワードを入れて検索することになるだろうが、その結果、必ずしもデータセットのみがヒットするわけではない。それと比べると、データセットのみを効率的に表示してくれるので便利である。 データセット検索 例えば図1は、Dataset Searchで実際にデータセットを検索しようとしているところである。

-

機械学習をコモディティ化する AutoML ツールの評価 - RAKUS Developers Blog | ラクス エンジニアブログ

- 33 users

- tech-blog.rakus.co.jp

- テクノロジー

- 2020/11/12

こんにちは、開発エンジニアの amdaba_sk(ペンネーム未定)です。 昨年度まで、ラクスの開発部ではこれまで社内で利用していなかった技術要素を自社の開発に適合するか検証し、ビジネス要求に対して迅速に応えられるようにそなえる 「開(か)発の未(み)来に先(せん)手をうつプロジェクト(通称:かみせんプロジェクト)」というプロジェクトがありました。本年度からは規模を拡大し、「技術推進プロジェクト」と名称を改めて再スタートされました。 本記事では、昨年度かみせんプロジェクトとしての最後のテーマとなった機械学習テーマの延長として 2020 年度上期に行った「AutoML ツールの調査と評価」について取り組み結果を報告します。 (ちなみに機械学習テーマは前年度から継続していたこともあり、上期で終了となってしまいました。残念……) なお過去の報告記事はかみせんカテゴリからどうぞ。技術推進プロジェクト

-

ABEJAアドベントカレンダー2020の19日目の記事です。 この記事は何? 結局AIって何個データ必要なの?ってよく聞かれると思います。 そんなん知るか この記事では、ある程度精度が出ている既存のタスクにおいて、どんなデータを、どのくらいの量与えているかを調べた結果です。ちなみに、僕自身、すべてのタスクを扱ったことがあるわけでは無いので、ほぼ一部適当な部分もあるかと思いますが、ご容赦ください。あと、このデータが入ってないよ!ってツッコミも歓迎です。 あと、技術は常に進んでいるので、ちゃんと最新技術を追っておけば、より少ないデータで良い結果を出すことが出来ないこともない。が、最新技術とはいえ銀の弾丸ではないのが通常で、例えlightweightGANがでたからと言って、100枚で学習できます!とか勝手に広がると困っちゃう。色んなタスクにおいて、まぁ大体どんなタスクも一般的にはこんなもんよっ

-

Papers With CodeのDatasets: 人気度まで分かるデータセット一覧サイト:AI・機械学習のデータセット辞典 データセットが効率よく見つけられるPapers With CodeのDatasetsを紹介。各データセットのページでは、データセット利用に向くタスクや、ベストな性能を発揮するモデル、コードありの論文、各ライブラリのデータローダー、データセットの人気傾向などを確認できる。 連載目次 最近、非常に有用な新しいデータセットの一覧サイトが登場したので紹介したい。 Papers With CodeのDatasetsとは? 「Papers With Code」というサイトをご存じだろうか? さまざまなタスク(例えば画像分類やテキスト生成など)に対して現時点でベストな性能を発揮する「機械学習モデル」や、スターの多い「コードあり論文」などをランキング形式で紹介してくれる、無料でオ

-

キーボードショートカット一覧

j次のブックマーク

k前のブックマーク

lあとで読む

eコメント一覧を開く

oページを開く